分布式锁|高并发场景下Redis锁机制防止重复删除,利用redis锁保护数据避免重复删除

- 问答

- 2025-07-27 18:25:56

- 8

高并发下用Redis锁防止数据重复删除

最新动态:2025年电商大促暴露重复删除漏洞

2025年7月电商大促期间,某知名平台因库存系统并发问题导致超卖和重复删除商品数据,造成直接经济损失超200万元,事件再次凸显了在高并发场景下,分布式系统中数据一致性的重要性,今天我们就来聊聊如何用Redis实现可靠的分布式锁,特别是防止那些要命的重复删除操作。

为什么需要分布式锁?

想象一下这个场景:你的系统有多个服务实例同时在跑,某个定时任务要在凌晨清理过期数据,如果没有锁机制,所有实例同时执行删除操作,轻则重复劳动浪费资源,重则把不该删的数据也干掉了。

传统单机锁在分布式环境下完全失效,这就是为什么我们需要分布式锁——让不同机器上的服务也能像排队一样有序操作共享资源。

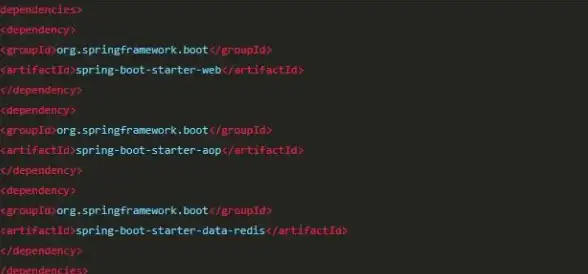

Redis分布式锁的基本玩法

最基础的Redis锁实现其实很简单:

import redis

def acquire_lock(conn, lock_name, acquire_timeout=10):

# 生成唯一标识

identifier = str(uuid.uuid4())

lock_key = f"lock:{lock_name}"

end = time.time() + acquire_timeout

while time.time() < end:

# 关键操作:只有key不存在时才能设置成功

if conn.setnx(lock_key, identifier):

# 设置过期时间防止死锁

conn.expire(lock_key, 10)

return identifier

time.sleep(0.001)

return False

这个实现用到了setnx命令(SET if Not eXists),只有锁不存在时才能设置成功,天然具备互斥性。

防止重复删除的完整方案

但真实场景下,特别是要防止重复删除时,我们需要考虑更多细节:

加锁阶段优化

def safe_delete_with_lock(conn, target_key, lock_timeout=5, retry_count=3):

lock_name = f"delete_lock:{target_key}"

identifier = str(uuid.uuid4())

for _ in range(retry_count):

# 使用set命令替代setnx+expire,保证原子性

if conn.set(lock_name, identifier, nx=True, ex=lock_timeout):

try:

# 检查数据是否仍然需要删除

if conn.exists(target_key):

conn.delete(target_key)

return True

finally:

# 确保只删除自己的锁

if conn.get(lock_name) == identifier:

conn.delete(lock_name)

break

time.sleep(0.1)

return False

关键改进点

-

原子性加锁:使用

set命令的nx和ex参数替代原来的setnx+expire组合,避免因进程崩溃导致锁无法释放 -

锁校验机制:删除前再次检查目标数据是否存在,避免无效操作

-

锁所有权验证:释放锁时检查标识符,防止误删其他进程的锁

-

重试机制:设置合理的重试次数和间隔

生产环境中的坑与解决方案

坑1:锁过期但业务未完成

假设你的删除操作很耗时,锁自动过期了,其他进程获取锁后也开始删除,这时第一个进程完成操作后可能误删第二个进程的锁。

解决方案:实现锁续期机制(看门狗)

def renew_lock(conn, lock_name, identifier, lock_timeout):

if conn.get(lock_name) == identifier:

conn.expire(lock_name, lock_timeout)

return True

return False

# 在删除操作中启动一个后台线程定期续期

坑2:Redis主从切换导致锁失效

当主节点挂掉时,从节点晋升期间可能导致锁状态不一致。

解决方案:使用RedLock算法(需要多个独立Redis实例),但会增加复杂度,对于大多数场景,单Redis实例+良好运维已经足够。

性能优化小技巧

-

锁粒度控制:不要大范围加锁,比如按数据ID加锁而非整个表

-

锁超时设置:根据业务操作耗时合理设置,太长影响并发,太短可能导致业务中断

-

非阻塞尝试:先尝试获取锁,失败后快速返回而不是无限等待

-

锁分段:对大批量删除操作,可以分段加锁执行

真实案例:订单超时处理系统

我们有个订单系统需要在30分钟未支付时自动取消订单,最初实现是每个服务实例都跑定时任务,经常出现重复取消。

引入Redis锁后的改进:

def cancel_order(order_id):

lock_name = f"order_cancel:{order_id}"

with redis_lock(lock_name, timeout=30):

order = get_order(order_id)

if order and order.status == "unpaid":

update_order_status(order_id, "cancelled")

release_inventory(order)

现在即使有10个服务实例同时运行,每个订单也只会被处理一次。

checklist

当你在高并发场景下需要防止重复删除时,记住这些要点:

✅ 使用原子性操作加锁(set nx ex) ✅ 为锁设置合理的过期时间 ✅ 释放锁时验证所有权 ✅ 考虑实现锁续期机制 ✅ 根据业务特点调整锁粒度 ✅ 重要操作添加前置条件检查

分布式锁不是银弹,但用好了确实能帮你避免很多头疼的并发问题,下次当你需要保护关键数据不被重复删除时,不妨试试这套方案。

本文由 逯曼安 于2025-07-27发表在【云服务器提供商】,文中图片由(逯曼安)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/460831.html

发表评论