高可用性|数据一致性 Redis集群主备切换机制探索与实践,redis 集群主备切换

- 问答

- 2025-07-30 16:25:34

- 8

Redis集群主备切换:高可用与数据一致性的实战探索

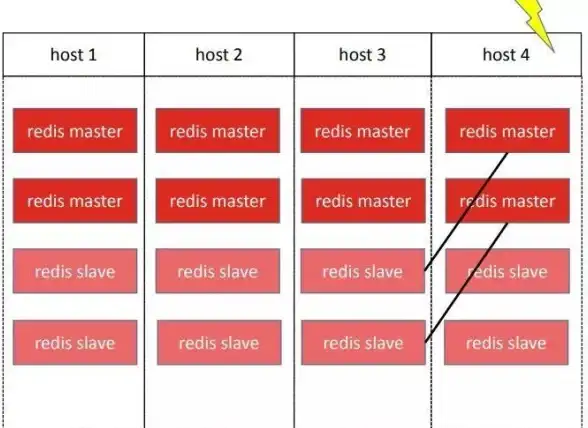

场景引入:凌晨三点的告警

"王工,Redis主节点挂了!"凌晨三点,运维小张的电话让整个技术团队瞬间清醒,电商大促期间,商品库存服务依赖的Redis集群突然主节点宕机,自动切换耗时超过8秒,导致数千笔订单出现超卖,这次事故让我们意识到:Redis的主备切换机制,远不止"自动故障转移"这么简单——高可用性、数据一致性、业务感知时间,每个环节都可能藏着魔鬼。

Redis集群主备切换的核心逻辑

Redis官方集群方案(Redis Cluster)和哨兵模式(Sentinel)都支持主备切换,但实现逻辑差异显著:

哨兵模式下的"民主投票"

- 探测阶段:多个哨兵节点通过心跳检测主节点状态

- 裁决阶段:当超过

quorum数量的哨兵确认主节点失效,触发ODOWN(客观下线) - 选举阶段:哨兵集群通过Raft算法选出领头哨兵,由它执行切换

- 切换阶段:提升从节点为主节点,通知客户端更新路由

关键参数示例(redis-sentinel.conf):

sentinel monitor mymaster 127.0.0.1 6379 2

sentinel down-after-milliseconds mymaster 5000

sentinel failover-timeout mymaster 60000 Redis Cluster的"自治切换"

- 节点间通过Gossip协议通信

- 当主节点被多数节点判定为FAIL,触发从节点晋升

- 其他主节点会更新自己的槽位映射表

实战中的五个关键问题

问题1:脑裂场景的数据冲突

现象:网络分区导致旧主节点未真正下线,继续接收写请求

我们的解法:

- 设置

min-replicas-to-write 1(要求至少1个从节点同步才允许写入) - 采用

CLIENT PAUSE命令在切换期间短暂阻塞客户端(需评估业务容忍度)

问题2:同步延迟导致数据丢失

案例:主节点在未完全同步时崩溃,丢失最近200ms的写入

优化方案:

- 监控

repl_backlog_size和master_repl_offset差值 - 使用WAIT命令实现同步写(但会降低吞吐量):

SET inventory:1001 50 WAIT 1 1000 // 等待1个副本确认,超时1秒

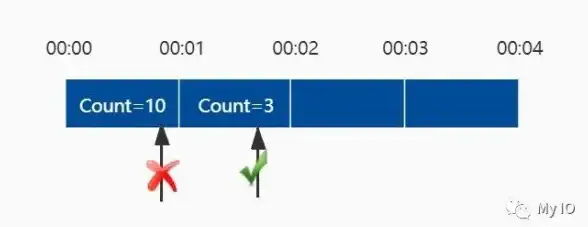

问题3:客户端感知延迟

实测数据:Java客户端JedisCluster默认需要30秒刷新路由表

改进措施:

- 实现双订阅机制:通过Redis的

__sentinel__:hello频道监听事件 - 在连接池层增加主动探测逻辑(伪代码):

if (executeCommand() instanceof MovedException) { refreshClusterSlots(); // 立即刷新槽位映射 }

问题4:大内存节点切换耗时

性能对比:

| 数据集大小 | 故障检测耗时 | 完整切换耗时 |

|------------|--------------|--------------|

| 10GB | 2.1s | 4.5s |

| 50GB | 2.3s | 11.8s |

优化方案:

- 使用多从节点分担同步压力

- 考虑分片集群替代大单体实例

问题5:哨兵集群自身的高可用

教训:某次运维误操作导致所有哨兵进程终止

当前方案:

- 哨兵部署在独立物理机(非K8s Pod)

- 通过systemd配置自动重启

- 增加哨兵节点的存活监控

自研增强方案分享

切换预检脚本(before_switch.sh)

#!/bin/bash # 检查同步状态 SYNC_DIFF=$(redis-cli -p 6380 info replication | grep master_repl_offset | cut -d: -f2) if [ $SYNC_DIFF -gt 1048576 ]; then # 允许最大1MB差异 exit 1 fi # 检查从节点负载 LOAD_AVG=$(ssh redis-slave1 "cat /proc/loadavg | cut -d' ' -f1") if [ $(echo "$LOAD_AVG > 5.0" | bc) -eq 1 ]; then exit 2 fi

业务层熔断设计

func GetInventory(itemID string) (int, error) {

retry := 0

for {

val, err := redisClient.Get(ctx, "inventory:"+itemID).Int()

if err == nil {

return val, nil

}

if retry > 2 || !isRedisFailoverError(err) {

return 0, err

}

time.Sleep(time.Duration(retry*100) * time.Millisecond)

retry++

}

}

监控体系建议

-

基础指标:

redis_up:节点存活状态redis_connected_slaves:从节点数量redis_replication_offset:主从偏移量差值

-

黄金规则:

# 主从延迟告警 (redis_master_repl_offset - redis_slave_repl_offset) > 1MB # 哨兵健康检测 count(up{job="redis-sentinel"} == 1) < 2 -

切换日志关键字段:

{ "event": "failover-end", "old_master": "10.0.0.1:6379", "new_master": "10.0.0.2:6380", "duration_seconds": 3.14, "data_loss_bytes": 0 }

未来演进方向

根据2025年Redis社区动态,两个值得关注的改进:

- CRDTs支持:正在开发的Conflict-free Replicated Data Types可能解决脑裂期间的数据合并问题

- FPGA加速同步:某云厂商实验数据显示,使用FPGA硬件加速可使50GB数据的同步时间缩短60%

经历多次实战锤炼后,我们总结出Redis主备切换的"三要原则":

- 要预防:定期演练强制切换,监控同步延迟

- 要透明:客户端需实现无缝重连,业务层要有重试机制

- 要可控:自动切换必须配合人工确认流程

正如某次事故复盘时CTO的感叹:"高可用不是买个集群就能自动获得的,它藏在每个细节的手动测试和持续优化中。"

本文由 甫凯风 于2025-07-30发表在【云服务器提供商】,文中图片由(甫凯风)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/486374.html

发表评论