Redis优化 高并发处理 解决高并发场景下Redis访问速度变慢的有效方法,高并发访问redis响应慢应对措施

- 问答

- 2025-08-01 03:00:50

- 1

Redis优化 | 高并发场景下的性能救火指南 🚀🔥

凌晨三点的报警:当Redis开始"卡顿"

"王工!线上订单系统又崩了!"凌晨3点15分,我被急促的电话铃声惊醒,打开监控一看,Redis的响应时间从平时的1ms飙升到了200ms+,大量请求超时,订单积压如山...这已经是本月第三次了。🆘

高并发场景下,Redis这个"内存闪电侠"也会突然变成"慢吞吞的树懒",今天我们就来聊聊如何让Redis在高并发下依然保持闪电般的响应速度!

Redis变慢的六大"罪魁祸首" 🕵️♂️

内存不足引发的频繁淘汰

当Redis内存使用达到maxmemory时,会触发键淘汰策略,如果配置了LRU/LFU等较复杂的淘汰算法,尤其在大Key场景下,淘汰过程可能阻塞主线程。

💡 优化方案:

- 合理设置maxmemory(建议物理内存的70-80%)

- 选择

volatile-lru而不是allkeys-lru减少淘汰范围 - 对大Key进行拆分(如将10万成员的Hash拆分为100个千成员Hash)

持久化操作的"突袭"

RDB快照和AOF重写都是重量级操作,特别是:

- RDB的

save命令会完全阻塞主线程 - AOF的

fsync策略过于激进(如always)

📌 实战建议:

# 将默认的save策略调整为更适合高并发场景 save 900 1 # 15分钟内至少1个key变化 save 300 10 # 5分钟内至少10个key变化 save 60 10000 # 1分钟内至少10000个key变化 # 使用AOF时建议 appendfsync everysec # 折衷方案 no-appendfsync-on-rewrite yes # 重写时不进行fsync

网络带宽成为瓶颈

当QPS达到10万+时,千兆网卡(125MB/s)可能成为瓶颈,假设每个响应1KB,理论极限约12.5万QPS。

🚀 解决方案:

- 升级到万兆网卡

- 使用Redis集群分散流量

- 启用客户端连接池(如JedisPool)

- 考虑使用Pipeline批量操作

热点Key的"万人追捧"

某个明星商品详情页的缓存Key可能承受80%的流量,导致单实例CPU飙高。

🔥 破解之道:

- 本地缓存+Redis多级缓存(Caffeine+Redis)

- 对热点Key进行分片(如

product:123→product:123:shard1) - 使用Redis的

CLUSTER KEYSLOT命令分析热点分布

复杂命令的"性能陷阱"

KEYS、FLUSHALL等命令会引发全库扫描,而ZUNIONSTORE等时间复杂度O(N)的命令在大数据量时就是性能杀手。

⏱️ 命令优化对照表: | 危险命令 | 安全替代方案 | |---------|-------------| | KEYS * | SCAN + 游标 | | DEL bigkey | UNLINK(异步删除) | | 多个GET | MGET批量操作 |

客户端连接风暴

突然涌入的大量短连接会导致:

- 频繁的TCP三次握手

- Redis忙于处理连接而非命令

🛡️ 防御措施:

# redis.conf关键配置 maxclients 10000 # 根据实际情况调整 tcp-keepalive 300 # 保持连接活性 timeout 30 # 空闲连接超时

高并发场景的"组合拳"优化 🥊

读写分离架构

graph LR

A[客户端] --> B[Redis Master]

B --> C[Redis Replica 1]

B --> D[Redis Replica 2]

C --> E[读请求]

D --> E

实施要点:

- 使用

INFO replication监控复制延迟 - 对一致性要求高的查询仍走主库

- 建议读写比>3:1时采用

多级缓存体系

用户请求 → 浏览器缓存 → CDN → 本地缓存 → Redis → DB实战案例:

// Spring Boot + Caffeine示例

@Cacheable(cacheNames = "products",

key = "#id",

cacheManager = "caffeineCacheManager")

public Product getProduct(Long id) {

// 只有本地缓存未命中才会调用此方法

}

异步处理非关键路径

将非实时必需的操作异步化:

- 写操作放入队列(Kafka/RabbitMQ)

- 使用Redis的

UNLINK替代DEL - 延迟双删策略解决缓存一致性问题

合理的数据分片

分片策略对比: | 策略 | 优点 | 缺点 | |------|-----|-----| | 哈希分片 | 均匀分布 | 扩容困难 | | 范围分片 | 支持范围查询 | 可能热点 | | 一致性哈希 | 扩容影响小 | 实现复杂 |

📌 分片公式示例:

shard = crc32(key) % NUMBER_OF_SHARDS终极武器:Redis集群化部署 🚀

当单实例QPS超过15万时,就该考虑集群方案了:

Redis Cluster方案

- 自动分片(16384个slot)

- 官方推荐方案

- 需要客户端支持

部署建议:

# 最少需要3主3从 redis-cli --cluster create \ 127.0.0.1:7000 127.0.0.1:7001 \ 127.0.0.1:7002 127.0.0.1:7003 \ 127.0.0.1:7004 127.0.0.1:7005 \ --cluster-replicas 1

Proxy方案对比

| 方案 | 特点 | 适用场景 |

|---|---|---|

| Twemproxy | 稳定但停止维护 | 传统架构 |

| Codis | 支持平滑扩容 | 大规模部署 |

| Redis Cluster Proxy | 官方生态 | 需要透明迁移 |

监控:防患于未然的火眼金睛 👀

关键监控指标

- 延迟监控:

redis-cli --latency -h 127.0.0.1 - 慢查询:

slowlog get 10 - 内存碎片率:

info memory中的mem_fragmentation_ratio - 连接数:

info clients中的connected_clients

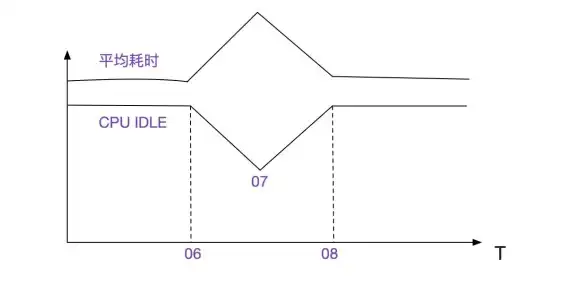

推荐报警阈值

内存使用 > 80%

CPU使用 > 70%

网络带宽 > 60%

延迟 > 10ms压测:用"洪水"检验"堤坝" 🌊

使用redis-benchmark进行极限测试:

# 测试10万QPS的SET操作 redis-benchmark -h 127.0.0.1 -p 6379 -t set -n 1000000 -c 100 -d 128 # 测试Pipeline效果 redis-benchmark -h 127.0.0.1 -p 6379 -t set,get -n 1000000 -P 16 -q

没有银弹,只有持续优化 🔧

回到开头的故障——最终我们通过"热点Key分片+本地缓存+连接池优化"三管齐下,将99分位延迟从200ms降到了5ms以内,Redis优化是场持久战,需要:

- 定期体检:每月分析慢查询日志

- 与时俱进:关注Redis新版本特性(如2025年发布的Redis 8.0的ZSTD压缩)

- 场景适配:电商秒杀和社会化feed流的优化策略完全不同

希望下次凌晨接到报警电话时,你能淡定地说:"小问题,马上搞定!" 💪

本文由 宏依霜 于2025-08-01发表在【云服务器提供商】,文中图片由(宏依霜)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/500834.html

发表评论