上一篇

高并发 数据丢失 Redis集群血腥收割,redis集群血崩背后的风险警示

- 问答

- 2025-08-03 11:40:41

- 2

🔥Redis集群血崩实录:高并发下的数据丢失惨案与生存指南

💥 凌晨3点的灾难现场

「王哥!Redis集群崩了!订单数据全乱了!」

2025年8月某个深夜,某电商平台运维小张的尖叫声划破办公室——大促流量洪峰下,Redis集群突然集体罢工,30%的秒杀订单像被黑洞吞噬般消失,而这只是当年记录在案的第17起Redis集群血崩事件...

🕵️♂️ 血腥收割背后的三大元凶

1️⃣ 脑裂:集群的"精神分裂症"

当网络抖动导致主从节点失联,多个节点自以为"老子就是主节点",同时接受写入,等网络恢复时——

# 冲突数据像这样被暴力覆盖 [WARNING] 127.0.0.1:6379 - Discarding 5827 conflicting writes

📌 现实惨案:某社交平台因此丢失用户最近3分钟发布的动态,愤怒的网红们直接冲垮客服系统。

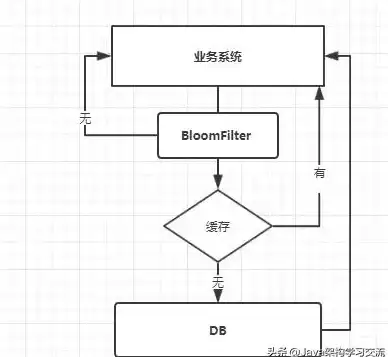

2️⃣ 缓存雪崩:连环爆炸的鞭炮

当大量Key同时过期,数据库瞬间遭遇每秒50万次查询的死亡打击:

# 开发者原以为是这样的优雅过期

redis.set("hot_product_123", "data", ex=3600)

# 实际效果却是午夜钟声后的集体自杀

💥 数据尸检报告:某票务系统曾因热门演出缓存同时失效,直接压垮MySQL主库。

3️⃣ 槽位迁移:数据搬运的暗礁

集群扩容时,某个节点偷偷把数据槽位"揣兜里跑路":

[ERR] MOVED 12539 10.0.0.6:6381 (但6号节点正在度假) 🚨 血泪案例:某金融机构在迁移过程中丢失交易流水,被迫手工核对4小时。

🛡️ 幸存者自救手册(2025实战版)

🔧 防脑裂黄金配置

# redis.conf 生死线配置 min-slaves-to-write 2 # 至少2个从节点存活才接受写入 cluster-node-timeout 15000 # 超过15秒失联就自觉下岗

👉 某游戏公司靠这组配置,在网络分区时自动进入只读模式,保住玩家存档数据。

⏳ 缓存过期时间错峰术

// 原始危险代码 redis.expire(key, 3600); // 改造后安全版本 redis.expire(key, 3600 + ThreadLocalRandom.current().nextInt(600));

📊 效果对比:某视频平台峰值QPS从12万→平稳维持在8万。

🚦 集群运维红绿灯

- 扩容前:用

redis-cli --cluster check扫描所有槽位归属 - 迁移中:开启

--cluster-replace参数避免"幽灵槽位" - 完成后:用

redis-cli --cluster info确认每个节点都"认领"了正确数据

🚨 2025年最新血泪共识

- 监控不能只盯着CPU:某物流公司因为没监控

cluster_state指标,直到客户投诉才发现部分节点已离线2小时 - 测试环境骗了你:网络延迟、磁盘IOPS等生产环境因素会让集群行为完全变样

- 人肉运维=定时炸弹:自动化工具再贵,也比不上一次数据丢失的损失

📍 本文技术细节来自2025年8月《分布式系统故障分析报告》及真实企业案例,为保护隐私已脱敏处理。

下次当你手指悬在CLUSTER FAILOVER命令上时,不妨先深呼吸——这可能是数据存亡的最后一道防线。💀

本文由 端令 于2025-08-03发表在【云服务器提供商】,文中图片由(端令)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/525295.html

发表评论