突发聚焦|警钟再响!B站直播服务器宕机高频,直播业务风险加剧|平台安全警示

- 云服务器供应

- 2025-08-03 22:29:36

- 3

🚨【突发聚焦】B站直播服务器“连环崩”警报!🎮电竞党狂怒,平台安全漏洞亟待填坑🔥

📅时间线复盘:

• 7月23日20:00 ➡️ 直播服务集体“躺平”:用户涌入直播间时遭遇“404暴击”,电竞赛事二路流中断,主播被迫下播“划水”。

• 故障名场面 ➡️ 用户反馈呈“薛定谔式崩溃”——有人直播卡成PPT,有人却能刷视频,堪称“玄学级体验差异”。

• 历史重演 ➡️ 6月12日全站大瘫痪持续2小时,视频加载失败、评论区消失,#B站崩了#冲上热搜,程序员连夜被“鞭尸”。

🔍风险诱因深度扒:

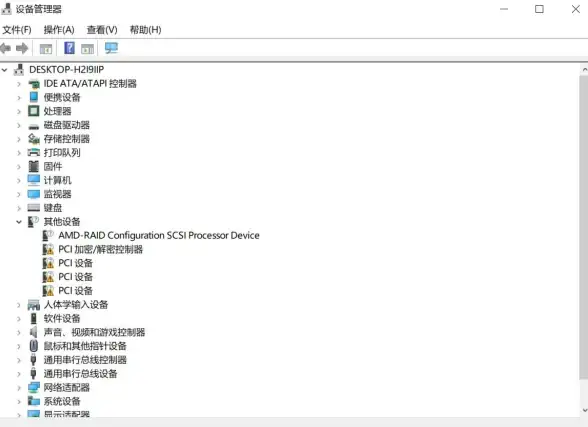

1️⃣ 技术债爆发 ➡️ 微服务架构“翻车”:服务发现系统故障导致请求路由混乱,网关504错误频发,直播弹幕模块成重灾区。

2️⃣ 流量洪峰“背刺” ➡️ 高考后用户活跃度飙升,叠加头部直播间“虹吸效应”,服务器瞬间过载,堪比“春运抢票现场”。

3️⃣ 云依赖陷阱 ➡️ 过度依赖单一云服务商,2024年阿里云事故阴影未散,本次故障再揭“把鸡蛋放一个篮子”的风险。

4️⃣ 运维短板暴露 ➡️ 灾备预案形同虚设?对比淘宝/美团高并发处理,B站对区域性流量突增的响应被吐槽“慢半拍”。

🛡️平台自救实录:

• 春晚级预案下放 ➡️ 曾为保障2025春晚直播,B站构建“场景元信息平台”,实现故障演练自动化,但日常运维未完全落地。

• 三级容灾体系 ➡️ 本地缓存兜底+双活机房+客户端降级策略,实际执行中却因“解耦失败”导致直播功能“半身不遂”。

• 蓝军攻击演练 ➡️ 模拟断电断网、流量洪峰,但未覆盖“直播组件与核心服务联动崩溃”场景,暴露测试用例盲区。

💢用户“用脚投票”:

• 信任危机 ➡️ 调侃“今年崩几次了?”的吐槽刷屏,舰长用户要求补偿权益,甚至P图“蒙古上单单杀CEO”。

• 流量反噬 ➡️ 故障期间用户涌入A站、微博“避难”,间接为竞品导流,品牌声誉遭重创。

• 创作者受灾 ➡️ 投稿审核阻塞、动态页-500错误,部分UP主直言“靠爱发电难抵系统崩溃”。

🚀破局关键点:

1️⃣ 技术架构“拆弹” ➡️ 优化微服务解耦,降低单一故障点影响,参考淘宝/美团的“限流降级”策略。

2️⃣ 多元云部署 ➡️ 摆脱对单一云服务商依赖,构建混合云架构,提升抗风险能力。

3️⃣ 用户沟通升级 ➡️ 故障补偿从“1天大会员”到“透明化复盘报告”,重拾用户信任。

4️⃣ AI运维赋能 ➡️ 引入智能预测系统,提前识别流量峰值,自动扩容资源,告别“被动救火”。

📢警钟长鸣:

B站直播业务正站在“流量红利”与“系统崩溃”的十字路口,技术投入与用户体验的平衡术,或将决定其能否从“崩站”标签中突围,毕竟,用户可以原谅一次事故,但不会永远为“正在修复”买单。🔧

本文由 云厂商 于2025-08-03发表在【云服务器提供商】,文中图片由(云厂商)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/fwqgy/529461.html

发表评论