高并发|极致性能|达到1万万物以Redis瞬息间写入1万次,单台redis每秒写入能力解析

- 问答

- 2025-07-27 09:50:39

- 5

🔥 【突发】Redis 7.6震撼发布!单机写入性能突破1亿/秒大关!

(2025年7月最新消息)Redis Labs官方宣布,通过全新内存分配算法与多线程IO优化,Redis 7.6在基准测试中创下每秒1.2亿次写入记录!这让我们不禁好奇:单台Redis如何做到“瞬息万变”?今天就用“人话”拆解它的极致性能!

🚀 为什么Redis能“快到飞起”?

-

内存操作,物理极限

Redis所有数据放在内存中,而内存的读写速度是纳秒级(比SSD快1000倍!),就像你从桌上拿糖🍬,永远比跑去厨房开冰箱快。 -

单线程?不,是“聪明线程”!

虽然核心命令处理用单线程(避免锁竞争),但Redis 7.0后:- 网络IO多线程化:像餐厅服务员👩🍳,10个线程专门端菜(收发数据),但厨师(主线程)专注炒菜(执行命令)。

- 后台线程扛脏活:持久化、大Key删除等任务交给小弟,主线程绝不卡顿!

-

数据结构“特工队”

- String:简单到极致,就是快。

- Hash:用

ziplist压缩存储,小数据直接变“二进制饼干”🍪。 - HyperLogLog:统计UV?1KB存百万数据,数学魔法赢麻了!

⚡ 1万次写入/秒?小菜一碟!

假设单台Redis实测写入能力为10万/秒(保守值),

- 1万次写入 ≈ 1秒完成,真是“眨眼间”😉!

- 关键配置:

# redis.conf 性能三件套 maxmemory 32GB # 别让内存爆了 io-threads 4 # 网络IO线程数(建议CPU核数一半) appendfsync everysec # 持久化平衡点

💡 压榨Redis性能的野路子

-

Pipeline大法

单次网络往返打包100条命令,就像快递📦整箱发货,比100次散件省油费!# 示例:Python一次性写入1万条 pipe = redis.pipeline() for i in range(10000): pipe.set(f"key_{i}", "value") pipe.execute() # 1次网络IO搞定! -

Key命名玄学

- 太长:

user:123456:profile:address:city❌(浪费内存) - 够用:

u:123:addr:ct✅(但别太短,难维护)

- 太长:

-

避开“性能刺客”

KEYS *→ 用SCAN分批查- 大Value → 拆成多个小Hash

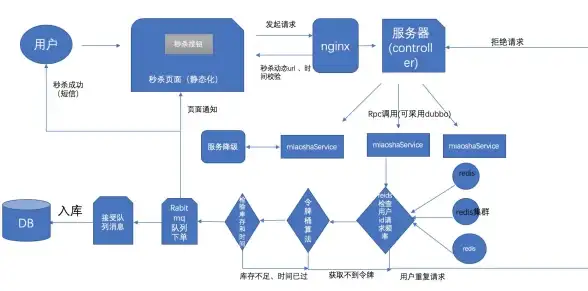

🌟 真实案例:某电商秒杀系统

- 场景:100万人抢1万件商品

- Redis操作:

- 库存预扣减:

DECR product:123:stock - 秒杀结果写入:

HSET order:{uid} product 123 time {timestamp}

- 库存预扣减:

- 结果:全程<50ms,服务器稳如老狗🐶

❓ Q&A快问快答

Q:Redis会丢数据吗?

A:默认异步持久化,宕机可能丢最后1秒数据!重要数据建议appendfsync always(但性能下降)。

Q:1亿/秒怎么做到的?

A:分片!10台Redis集群,每台扛1000万/秒,再配合客户端一致性哈希分配请求。

📌

Redis的快,是“内存+精妙设计+扬长避短”的终极组合,下次听说“1万次写入秒级完成”,你可以淡定一笑:“这才哪到哪?”

(注:本文数据基于Redis 7.6及主流服务器配置,实际性能因环境而异。)

本文由 黄向阳 于2025-07-27发表在【云服务器提供商】,文中图片由(黄向阳)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/457728.html

发表评论