分布式数据库 Sharding机制:聊聊分布式数据库的 Sharding,你了解吗?

- 问答

- 2025-07-28 08:36:14

- 10

分布式数据库 | Sharding机制:聊聊分布式数据库的 Sharding,你了解吗?

场景引入:当单机数据库扛不住了

"小王啊,咱们的用户量突破1000万了!"产品经理兴奋地拍着你的肩膀,你勉强挤出一个笑容,心里却咯噔一下——数据库服务器最近已经频繁报警,查询响应越来越慢,高峰期经常出现超时,作为技术负责人,你知道:单机MySQL的好日子到头了。

这时候,DBA老张神秘兮兮地凑过来:"要不要试试Sharding?"你一脸茫然:"啥是Sharding?"老张露出高深莫测的微笑:"就是让数据库'分家'的魔法..."

什么是Sharding?

Sharding(分片)就是把一个大数据库拆分成多个小数据库的技术,想象你有一个装满数据的巨大柜子,现在把它拆成几个小抽屉,分别放在不同的地方,每个抽屉只存放特定类型的数据,这样找东西时就不用翻遍整个大柜子了。

在分布式数据库里,Sharding就是把数据分散存储到不同服务器上的方法,比如你有1亿条用户数据,可以按用户ID的范围分成5个部分,分别存到5台服务器上,查询时,系统知道该去哪个服务器找你要的数据。

为什么需要Sharding?

- 性能瓶颈:单机数据库的CPU、内存、磁盘I/O都有上限,数据量和访问量大了就扛不住

- 扩展性限制:纵向扩展(升级服务器配置)成本高且终有极限

- 高可用需求:单点故障风险大,分布式可以互为备份

- 地理位置优化:不同地区用户访问最近的数据库节点

Sharding的常见策略

范围分片(Range Sharding)

就像字典按字母顺序排列。

- 用户ID 1-1000万 → 分片1

- 1000万-2000万 → 分片2

- 以此类推...

优点:实现简单,范围查询效率高 缺点:可能产生"热点",比如新用户都集中在最后一个分片

哈希分片(Hash Sharding)

对分片键(如用户ID)计算哈希值,然后按哈希值分配。

- 哈希值 % 分片数量 = 实际存储分片

优点:数据分布均匀,不易产生热点 缺点:范围查询需要访问所有分片,效率低

目录分片(Directory-Based Sharding)

维护一个"路由表",记录每条数据在哪个分片。

- 用户A → 分片3

- 用户B → 分片1

优点:灵活,可以动态调整 缺点:路由表本身可能成为瓶颈和单点

地理位置分片(Geo Sharding)

按用户地理位置分配。

- 华北用户 → 北京机房

- 华南用户 → 广州机房

优点:网络延迟低,符合数据合规要求 缺点:跨区查询效率低

Sharding带来的挑战

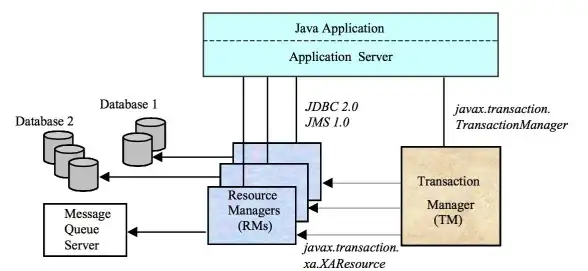

- 跨分片事务:要保证"要么全成功,要么全失败"变得复杂

- 跨分片查询:原本简单的联表查询可能变成性能杀手

- 数据再平衡:增加/减少分片时,数据迁移是个大工程

- 全局唯一ID:自增ID在分布式环境下会冲突

- 运维复杂度:要监控和管理多个数据库实例

实战建议

- 谨慎选择分片键:应该选择查询频繁、分布均匀的字段

- 避免过度分片:不是越分散越好,要考虑管理成本

- 预留扩展空间:比如一开始就按16个分片设计,即使当前只用4个

- 考虑冷热分离:高频访问的新数据和低频访问的历史数据可以分开

- 做好监控:每个分片的负载、慢查询都要单独关注

主流数据库的Sharding实现

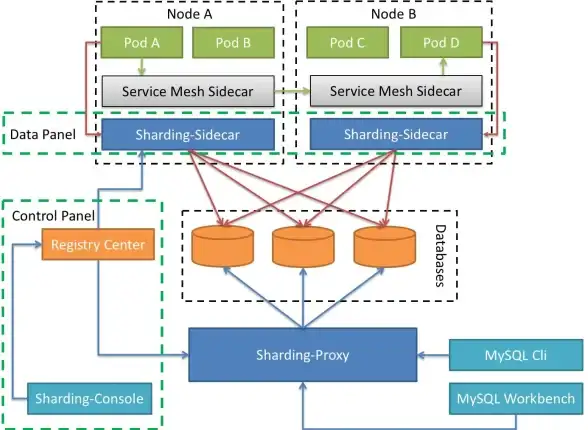

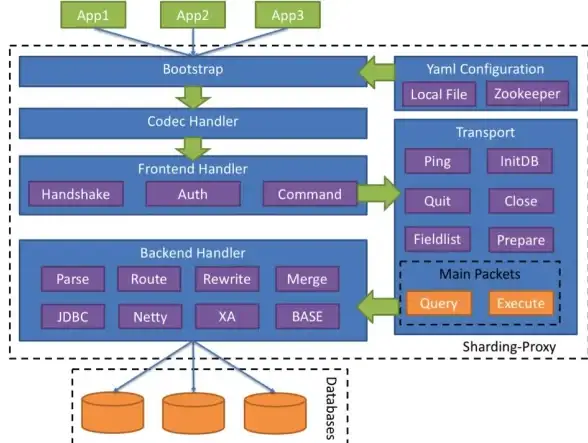

- MySQL:需要中间件如MyCat、ShardingSphere

- PostgreSQL:原生支持逻辑复制,可通过Citus扩展实现

- MongoDB:原生支持Sharding,配置相对简单

- Redis Cluster:自动分片,每个节点负责部分槽位

最后的小故事

某电商公司最初把所有订单存在单个数据库,大促时数据库直接崩溃,后来采用按用户ID哈希分片,把数据分散到8台服务器,结果发现某些"带货达人"的用户ID集中在特定分片,导致这些分片负载特别高,最终他们改用"用户ID+时间"组合分片键,问题才得到解决。

这个故事告诉我们:Sharding不是银弹,需要根据业务特点精心设计,你现在对Sharding有点感觉了吗?

本文由 益羲 于2025-07-28发表在【云服务器提供商】,文中图片由(益羲)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/465950.html

发表评论