Flink SQL 动态表与连续查询核心思想全解析:深入理解Flink SQL动态表和连续查询

- 问答

- 2025-07-28 12:51:44

- 10

Flink SQL动态表与连续查询核心思想全解析

场景引入:当实时数据流遇到SQL查询

想象一下,你正在运营一个电商平台,每秒都有成千上万的用户浏览商品、下单支付,传统的批处理方式每小时统计一次销售额显然已经不能满足实时监控业务的需求,这时候,你需要的是一种能够"持续不断"分析数据流的技术——这正是Flink SQL动态表和连续查询的用武之地。

"昨天的销售额是多少?"这种问题批处理就能回答,但"过去5分钟哪些商品最受欢迎?"或者"当前支付成功率是多少?"这类实时问题,就需要Flink SQL的动态表和连续查询能力了。

动态表:流与表的统一视角

什么是动态表?

动态表(Dynamic Table)是Flink SQL对流式数据处理的核心抽象,它巧妙地将传统数据库中的静态表概念扩展到了流处理领域:

- 静态表:数据是固定的,查询结果是确定不变的

- 动态表:数据随时间不断变化,查询结果也会随之更新

用生活中的例子来说,静态表就像一张照片,记录了某个瞬间的状态;而动态表则像一段视频,展现了状态随时间的变化过程。

动态表的工作原理

- 流到表的转换:Flink将数据流(如Kafka消息)转换为动态表

- 表的持续更新:新数据到达时,动态表会生成对应的"添加"(INSERT)、"删除"(DELETE)或"更新"(UPDATE)操作

- 查询作用在动态表上:SQL查询不再是一次性操作,而是持续监控表的变化

-- 创建一个动态表,连接Kafka数据源

CREATE TABLE user_clicks (

user_id STRING,

item_id STRING,

click_time TIMESTAMP(3),

WATERMARK FOR click_time AS click_time - INTERVAL '5' SECOND

) WITH (

'connector' = 'kafka',

'topic' = 'clicks',

'properties.bootstrap.servers' = 'kafka:9092',

'format' = 'json'

);

这张user_clicks表会随着Kafka中新的点击事件不断"生长",这就是动态表的典型例子。

连续查询:永不停止的SQL引擎

连续查询的本质

传统SQL查询执行一次就结束了,而连续查询(Continuous Query)会一直运行,每当底层动态表发生变化时就重新计算并输出结果。

这就像你打开股票软件,看到的不是某个时间点的股价快照,而是随着市场变动不断更新的实时走势图。

连续查询的两种模式

- 无界查询(Unbounded Query):结果表会无限增长,比如简单的SELECT查询

-- 这个查询会输出所有点击事件 SELECT * FROM user_clicks;

- 聚合查询(Aggregate Query):结果会随着时间推移不断更新

-- 每分钟统计热门商品

SELECT

item_id,

COUNT(*) as click_count,

HOP_START(click_time, INTERVAL '5' SECOND, INTERVAL '1' MINUTE) as window_start

FROM user_clicks

GROUP BY

item_id,

HOP(click_time, INTERVAL '5' SECOND, INTERVAL '1' MINUTE);

这个查询每分钟会输出过去一分钟内各商品的点击量,而且每5秒会更新一次结果(因为滑动窗口步长是5秒)。

状态管理:连续查询的"记忆"

连续查询之所以能持续计算,是因为Flink会维护查询的状态,比如上面的聚合查询,Flink需要记住过去一分钟内各商品的所有点击事件,才能正确计算计数。

当使用事件时间(event time)处理时,Flink还会根据水位线(watermark)来判断何时可以安全地计算并输出某个时间段的聚合结果。

动态表与连续查询的协作机制

完整处理流程

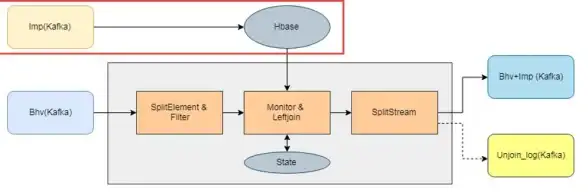

- 数据流摄入:从Kafka等源获取数据流

- 转换为动态表:将流数据映射为不断变化的表

- 连续查询执行:在动态表上执行SQL查询,生成新的动态表

- 结果输出:将结果动态表转换回流数据,发送到下游系统

原始数据流 → 动态表 → 连续查询 → 结果动态表 → 输出数据流更新日志(Changelog)概念

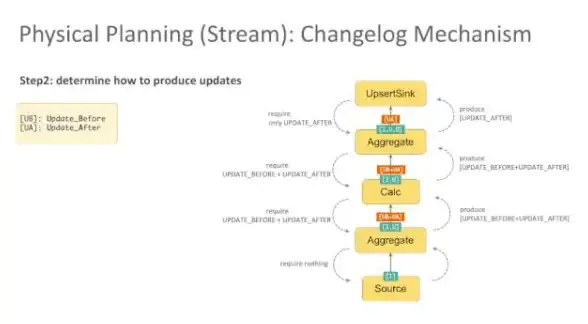

动态表的变化通过更新日志来表示,包含以下几种记录类型:

- +I:插入记录(INSERT)

- -U:更新前的记录(UPDATE_BEFORE)

- +U:更新后的记录(UPDATE_AFTER)

- -D:删除记录(DELETE)

连续查询处理这些更新日志,生成新的更新日志,形成处理流水线。

实际案例:电商实时分析系统

让我们通过一个完整的电商场景来理解这些概念的实际应用。

定义数据源

-- 用户点击事件流

CREATE TABLE clicks (

user_id STRING,

product_id STRING,

click_time TIMESTAMP(3),

WATERMARK FOR click_time AS click_time - INTERVAL '30' SECOND

) WITH (...);

-- 订单支付事件流

CREATE TABLE payments (

order_id STRING,

product_id STRING,

amount DECIMAL(10,2),

payment_time TIMESTAMP(3),

WATERMARK FOR payment_time AS payment_time - INTERVAL '1' MINUTE

) WITH (...);

实时业务指标计算

案例1:实时热门商品排名

-- 每5分钟统计热门商品

SELECT

product_id,

COUNT(*) AS click_count,

TUMBLE_START(click_time, INTERVAL '5' MINUTE) AS window_start

FROM clicks

GROUP BY

product_id,

TUMBLE(click_time, INTERVAL '5' MINUTE);

案例2:转化率分析

-- 计算点击到购买的转化率(每10分钟)

WITH

click_stats AS (

SELECT

product_id,

COUNT(*) AS clicks,

TUMBLE_START(click_time, INTERVAL '10' MINUTE) AS window_start

FROM clicks

GROUP BY

product_id,

TUMBLE(click_time, INTERVAL '10' MINUTE)

),

payment_stats AS (

SELECT

product_id,

COUNT(*) AS payments,

SUM(amount) AS revenue,

TUMBLE_START(payment_time, INTERVAL '10' MINUTE) AS window_start

FROM payments

GROUP BY

product_id,

TUMBLE(payment_time, INTERVAL '10' MINUTE)

)

SELECT

c.product_id,

c.clicks,

p.payments,

p.revenue,

(p.payments * 100.0 / c.clicks) AS conversion_rate,

c.window_start

FROM click_stats c

JOIN payment_stats p ON

c.product_id = p.product_id AND

c.window_start = p.window_start;

异常检测

-- 检测异常支付行为(同一用户短时间内多次支付)

SELECT

user_id,

COUNT(*) AS payment_count,

SUM(amount) AS total_amount,

HOP_START(payment_time, INTERVAL '10' SECOND, INTERVAL '5' MINUTE) AS window_start

FROM payments

GROUP BY

user_id,

HOP(payment_time, INTERVAL '10' SECOND, INTERVAL '5' MINUTE)

HAVING COUNT(*) > 5 OR SUM(amount) > 10000;

性能优化与最佳实践

合理设置水位线(Watermark)

水位线决定了系统对延迟数据的容忍度和结果输出的及时性:

-- 根据业务需求设置合理的水位线延迟 WATERMARK FOR event_time AS event_time - INTERVAL '5' SECOND -- 低延迟场景 WATERMARK FOR event_time AS event_time - INTERVAL '1' MINUTE -- 高准确性场景

状态大小管理

连续查询中的聚合操作会保存状态,需注意:

- 使用TTL(Time-To-Live)控制状态保留时间

- 对高基数(key数量多)的字段进行聚合时要谨慎

- 考虑使用

STATE RETENTION TIME语法限制状态保留

-- 设置状态保留时间为7天

CREATE TABLE orders (

...

) WITH (

...

'state-retention-time' = '7d'

);

选择适当的窗口类型

- 滚动窗口(TUMBLE):固定大小、不重叠的窗口

- 滑动窗口(HOP):固定大小、可重叠的窗口

- 会话窗口(SESSION):由不活动间隔划分的动态窗口

处理迟到数据

-- 允许延迟数据并设置副输出

SELECT

user_id,

COUNT(*) AS clicks

FROM clicks

GROUP BY

user_id,

TUMBLE(click_time, INTERVAL '1' HOUR)

-- 允许1分钟的延迟数据

WITH LATE FIRING DELAY INTERVAL '1' MINUTE

-- 将迟到太多无法处理的数据输出到副输出

EMIT AFTER WATERMARK WITH DELAY INTERVAL '5' MINUTE;

常见问题与解决方案

结果更新过于频繁

问题:某些查询可能导致结果频繁更新,给下游系统带来压力。

解决方案:

- 增大窗口大小或滑动步长

- 使用

EMIT语法控制输出频率

-- 每分钟计算一次,但每10秒输出一次增量结果

SELECT ...

FROM ...

GROUP BY ...

EMIT WITH DELAY INTERVAL '10' SECOND;

状态过大导致性能下降

问题:长时间运行的聚合查询可能积累大量状态。

解决方案:

- 设置合理的状态TTL

- 对无限流考虑使用

MATCH_RECOGNIZE进行模式检测而非全量聚合 - 分区处理数据

处理时间与事件时间的混淆

问题:错误地使用处理时间而非事件时间可能导致结果不准确。

解决方案:

- 明确区分

PROCTIME()(处理时间)和事件时间字段 - 确保源数据包含时间戳字段

- 正确设置水位线

未来展望:2025年的Flink SQL

截至2025年7月,Flink SQL在动态表和连续查询方面有了更多增强:

- 增强的流批一体:动态表API现在可以更无缝地在流和批模式间切换

- 更智能的状态管理:自动状态压缩和分层存储技术降低了大规模状态的内存需求

- 改进的事件时间处理:新的水位线生成策略提供了更灵活的延迟与准确性平衡

- 扩展的SQL语法:增加了更多流处理特有的语法糖,使查询编写更直观

流式SQL的新思维

理解Flink SQL的动态表和连续查询机制,实际上是在培养一种"流式思维",传统SQL开发者需要转变观念:

- 表不再是静态的快照,而是流动的河流

- 查询不是一次性的操作,而是持续观察的过程

- 结果是不断演化的,而非固定不变的

掌握了这种思维模式,你就能在实时数据处理领域游刃有余,构建出真正响应式的数据分析系统,Flink SQL通过将熟悉的SQL语法与强大的流处理能力结合,大大降低了实时应用开发的门槛,让更多开发者能够参与到实时数据处理的革命中来。

本文由 茂弘毅 于2025-07-28发表在【云服务器提供商】,文中图片由(茂弘毅)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/467496.html

发表评论