磁盘管理|系统优化 centos文件大小限制及解决方法详解

- 问答

- 2025-07-30 04:48:55

- 4

磁盘管理 | 系统优化:CentOS文件大小限制及解决方法详解

场景引入:当你的服务器突然罢工

想象一下,凌晨三点,你正睡得香甜,突然手机疯狂震动——监控系统报警,某台CentOS服务器上的关键服务崩溃了!你强撑睡意连上SSH,查日志发现一行刺眼的报错:"File too large",原来是一个日志文件暴涨到10GB,而系统却拒绝继续写入,这时候你才意识到:CentOS默认的文件大小限制在默默作祟。

别慌,今天我们就彻底搞懂CentOS的文件大小限制机制,并手把手教你如何突破这些限制,让你的服务器不再因"长大"而罢工。

CentOS文件大小限制的三大"守门员"

文件系统限制:EXT4/XFS的默认枷锁

CentOS常用的EXT4和XFS文件系统本身有默认限制:

-

EXT4:单个文件最大16TB(理论值),但实际受分区格式影响:

# 查看块大小和最大文件尺寸 dumpe2fs /dev/sda1 | grep "Block size\|File size"

若块大小为4KB,则文件最大支持2^32×4KB≈16TB。

-

XFS:理论支持单个文件8EB(1EB=100万TB),但需要手动调整:

# 创建XFS分区时指定大文件支持 mkfs.xfs -f -d agsize=16g /dev/sdb1

用户级限制:ulimit的温柔陷阱

即使文件系统允许,用户的shell限制也可能拦路:

# 查看当前用户限制 ulimit -a | grep "file size" # 输出示例: # file size (blocks, -f) unlimited

若显示unlimited则无限制,否则需修改:

# 临时生效 ulimit -f unlimited # 永久生效(需root) echo "* hard fsize unlimited" >> /etc/security/limits.conf

内核参数:fs.file-max的全局天花板

Linux内核限制整个系统同时打开的文件总数:

# 查看当前值 cat /proc/sys/fs/file-max # 典型值:794168(约80万) # 临时调整 sysctl -w fs.file-max=2000000 # 永久生效 echo "fs.file-max = 2000000" >> /etc/sysctl.conf sysctl -p

实战:突破限制的4种姿势

▶ 场景1:处理超大型日志文件

问题:/var/log/messages突破2GB后无法写入

解法:

- 改用XFS文件系统(需备份数据后重格式化)

- 或者调整EXT4为64位模式:

tune2fs -O 64bit /dev/sda1 resize2fs /dev/sda1

▶ 场景2:数据库表空间爆炸

问题:MySQL的ibdata1文件达到10GB上限

解法:

- 确保InnoDB使用独立表空间:

# /etc/my.cnf [mysqld] innodb_file_per_table=1

- 迁移数据到XFS分区

▶ 场景3:用户程序报错"Too many open files"

解法:

# 查看进程限制 cat /proc/<PID>/limits # 修改系统级限制 echo "fs.nr_open = 1000000" >> /etc/sysctl.conf

防患于未然的3个建议

-

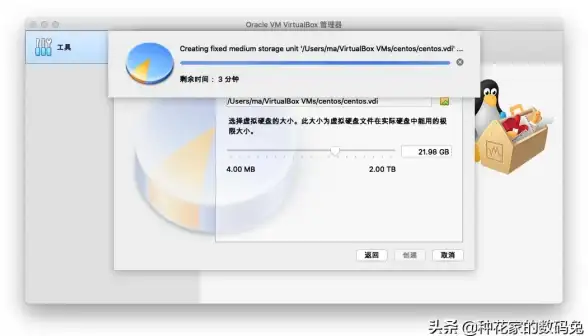

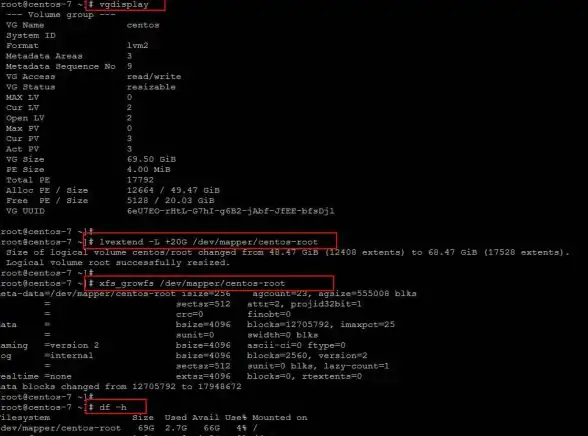

分区规划阶段:

- 对/var、/home等易增长目录使用XFS

- 使用LVM方便后期扩容

-

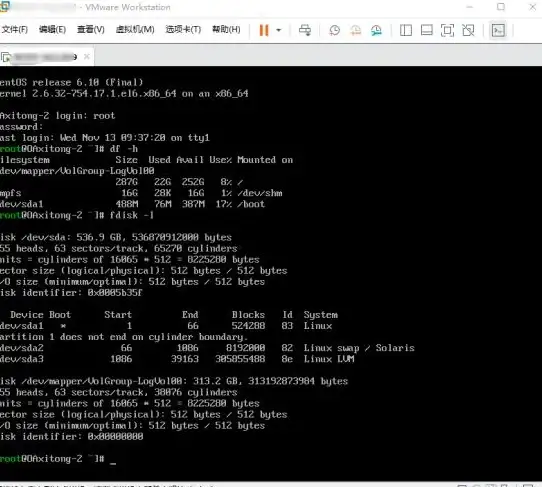

日常监控命令:

# 查看磁盘使用率 df -Th # 找出大文件 find / -type f -size +1G -exec ls -lh {} \; # 实时监控文件增长 watch -n 5 "du -sh /var/log/*" -

日志轮转配置:

编辑/etc/logrotate.conf,确保关键日志按大小切割:/var/log/nginx/*.log { size 100M rotate 10 compress }

本文由 汗昭懿 于2025-07-30发表在【云服务器提供商】,文中图片由(汗昭懿)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/481704.html

发表评论