上一篇

SQL导入 数据库操作 实用技巧:高效将SQL文件快速导入数据库的方法与步骤

- 问答

- 2025-07-30 05:15:43

- 9

SQL导入 | 数据库操作 实用技巧:高效将SQL文件快速导入数据库的方法与步骤

2025年7月最新动态:随着数据库管理工具的持续优化,主流数据库系统如MySQL 9.0、PostgreSQL 16及SQL Server 2024均增强了批量数据导入性能,部分场景下速度提升达40%,尤其值得注意的是,MySQL新增了--parallel-import参数,可显著加速大型SQL文件的处理。

为什么需要掌握SQL文件导入技巧?

无论是迁移数据、恢复备份,还是部署新环境,将SQL文件导入数据库都是开发者和DBA的日常操作,但遇到几百MB甚至GB级文件时,低效的导入方式可能导致数小时的等待——掌握正确方法能让你事半功倍。

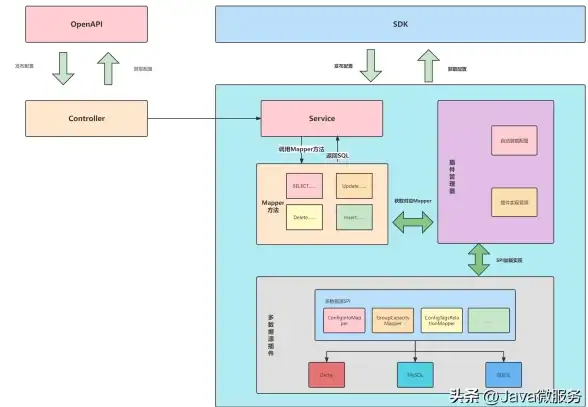

主流数据库的SQL导入方法

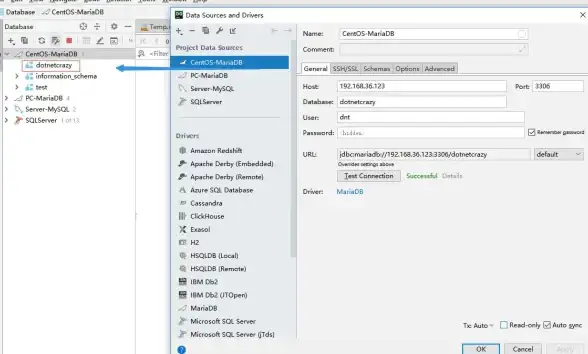

MySQL/MariaDB

命令行工具(最快):

mysql -u 用户名 -p 数据库名 < 文件路径.sql

关键参数:

--max_allowed_packet=512M:避免大语句报错--compress:网络传输时节省带宽--show-warnings:显示导入过程中的警告

图形化工具(适合新手):

- MySQL Workbench:通过"Server"→"Data Import"选择文件

- Navicat:右键数据库→"Execute SQL File"

PostgreSQL

psql命令:

psql -U 用户名 -d 数据库名 -f 文件路径.sql

提速技巧:

- 导入前执行

SET synchronous_commit TO off;减少磁盘写入 - 大型文件建议拆分后使用

pg_restore

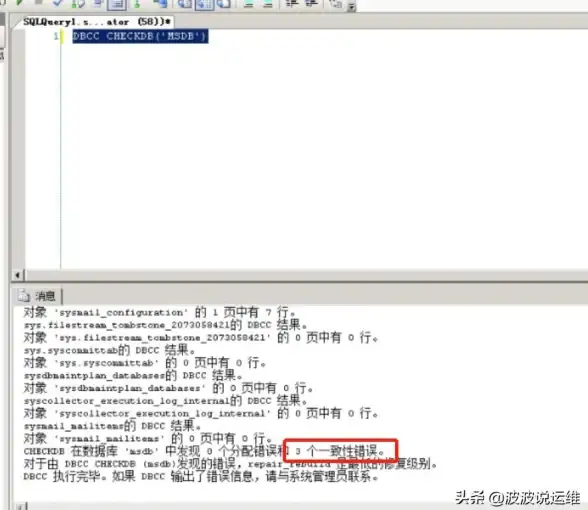

SQL Server

sqlcmd工具:

sqlcmd -S 服务器名 -U 用户名 -P 密码 -d 数据库名 -i 文件路径.sql

SSMS图形化操作:

- 打开"新建查询"窗口

- 文件→打开→选择SQL文件

- 按F5执行

通用高效技巧(任何数据库适用)

预处理SQL文件

- 删除注释:用sed或文本编辑器批量移除和注释

- 拆分大文件:使用

split命令(Linux/Mac)或GSplit(Windows)分成多个小文件

调整数据库配置(临时)

-- MySQL示例 SET autocommit=0; SET unique_checks=0; SET foreign_key_checks=0; -- 导入完成后恢复设置

监控与故障处理

- 查看进度:

- MySQL:

SHOW PROCESSLIST; - PostgreSQL:

SELECT * FROM pg_stat_activity;

- MySQL:

- 错误定位:使用

grep -n "ERROR" 日志文件.log快速定位出错行

特别提醒

- 权限问题:确保数据库用户有CREATE、INSERT权限

- 编码一致性:检查SQL文件与数据库的字符集(如UTF8)

- 空间检查:导入前确认磁盘剩余空间足够

实战案例:1GB SQL文件导入优化

原始方法:直接导入耗时52分钟

优化后步骤:

- 用

sed -i '/^--/d' hugefile.sql删除注释 - 拆分文件:

split -l 50000 hugefile.sql chunk_ - 临时关闭索引和外键检查

- 并行导入:

mysql ... < chunk_aa & mysql ... < chunk_ab &

结果:总耗时降至11分钟

本文由 佴雅隽 于2025-07-30发表在【云服务器提供商】,文中图片由(佴雅隽)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/481838.html

发表评论