Redis应用 分布式架构 分布式项目中如何高效利用Redis实现系统优化

- 问答

- 2025-07-30 11:38:42

- 3

Redis应用 | 分布式架构 | 分布式项目中如何高效利用Redis实现系统优化

2025年7月最新动态:Redis Labs最新发布的Redis 8.2版本中,新增了对多线程I/O的全面支持,使得单实例吞吐量提升最高可达3倍,这一特性为分布式系统的高并发场景提供了更强大的底层支持,阿里云技术团队近期公开的数据显示,在其电商业务中,通过Redis集群优化后的分布式锁方案,成功将秒杀场景下的系统吞吐量提升了47%。

为什么分布式系统离不开Redis?

说到分布式系统优化,Redis就像是我们口袋里的瑞士军刀——小巧但功能强大,我见过太多团队在系统遇到性能瓶颈时,第一个想到的就是:"要不加个Redis试试?"

Redis在分布式架构中的核心价值其实很简单:

- 内存级响应速度:平均操作耗时在亚毫秒级,比传统数据库快100倍

- 丰富的数据结构:不只是简单的key-value,还有List、Set、ZSet等高级结构

- 原子性操作:单线程模型避免了复杂的并发控制

- 持久化能力:即使重启也不会丢失数据

分布式场景下的Redis实战技巧

缓存策略:不只是"set/get"那么简单

很多新手容易犯的错误就是把Redis当成普通缓存,随便set/get就完事了,分布式缓存需要更精细的控制:

# 错误示范 - 简单的缓存穿透

def get_product(product_id):

cache_key = f"product:{product_id}"

data = redis.get(cache_key)

if not data:

data = db.query("SELECT * FROM products WHERE id=?", product_id)

redis.set(cache_key, data) # 这里可能缓存null值导致缓存穿透

return data

# 正确做法 - 防止缓存穿透的布隆过滤器方案

def get_product_safe(product_id):

if not bloom_filter.might_contain(product_id):

return None # 肯定不存在的数据直接返回

cache_key = f"product:{product_id}"

data = redis.get(cache_key)

if data == "NULL": # 特殊标记表示数据库确实不存在

return None

if not data:

data = db.query("SELECT * FROM products WHERE id=?", product_id)

if not data:

redis.setex(cache_key, 300, "NULL") # 短期缓存空值

else:

redis.setex(cache_key, 3600, data) # 正常缓存

return data

缓存策略黄金法则:

- 热点数据永不过期,通过后台线程定期更新

- 非热点数据采用"懒加载+过期时间"策略

- 对可能不存在的key做特殊标记,防止缓存穿透

分布式锁:别再用SETNX了

2025年了,如果你还在用简单的SETNX实现分布式锁,真的该更新知识库了,看看Redlock算法的改进版实现:

public boolean tryLock(String lockKey, long expireTime, TimeUnit unit) {

String lockId = UUID.randomUUID().toString();

long endTime = System.currentTimeMillis() + unit.toMillis(expireTime);

// 尝试在多数节点获取锁

int successCount = 0;

for (RedisNode node : redisCluster.getNodes()) {

if (node.execute("SET", lockKey, lockId, "NX", "PX", expireTime) != null) {

successCount++;

}

}

// 检查是否获得多数锁

if (successCount >= redisCluster.getNodes().size() / 2 + 1) {

lockHolder.set(lockId);

return true;

}

// 获取失败则释放已获得的锁

unlock(lockKey);

return false;

}

分布式锁最佳实践:

- 一定要设置锁的过期时间,防止死锁

- 锁的值使用唯一ID,确保只能由加锁者释放

- 考虑使用Redisson等成熟框架而非自己造轮子

- 对锁操作添加重试机制,但要有最大重试次数限制

秒杀系统:Redis是终极武器

去年双十一,某电商平台的秒杀系统QPS达到惊人的120万,核心秘密就是Redis的合理使用:

func handleFlashSale(productID string, userID string) bool {

// 1. 库存预检查

stockKey := fmt.Sprintf("flash_sale_stock:%s", productID)

currentStock, err := redis.Decr(stockKey)

if err != nil || currentStock < 0 {

redis.Incr(stockKey) // 回滚

return false

}

// 2. 防重复购买

userKey := fmt.Sprintf("flash_sale_users:%s", productID)

added, err := redis.SAdd(userKey, userID)

if err != nil || added == 0 {

redis.Incr(stockKey) // 回滚

return false

}

// 3. 异步落库

mq.Send(FlashSaleMessage{ProductID: productID, UserID: userID})

return true

}

秒杀系统四层防护:

- 前端限流:按钮置灰、验证码

- 网关层限流:令牌桶算法控制流量

- Redis库存检查:原子性递减操作

- 异步订单处理:消息队列削峰填谷

Redis集群管理:避坑指南

数据分片策略

Redis Cluster默认使用16384个槽位进行数据分片,但实际业务中我们可能需要自定义分片逻辑:

// 一致性哈希分片示例

const crypto = require('crypto');

function getShardNode(key, nodes) {

const hash = crypto.createHash('md5').update(key).digest('hex');

const hashValue = parseInt(hash.substring(0, 8), 16);

const nodeIndex = hashValue % nodes.length;

return nodes[nodeIndex];

}

// 使用示例

const productShard = getShardNode(`product:${productId}`, redisNodes);

热点Key发现与处理

使用Redis自带的监控命令可以发现热点Key:

redis-cli --hotkeys处理方案:

- 本地缓存+Redis二级缓存

- Key拆分:将hot_product:123拆分为hot_product:123:part1、hot_product:123:part2

- 随机过期时间:避免缓存雪崩

内存优化技巧

最近处理的一个案例:某社交平台用户关系数据从16GB优化到4GB:

- 使用Hash代替大量String存储用户属性

- 对ID使用数字编码而非字符串

- 启用ziplist优化小数据存储

# redis.conf关键配置

hash-max-ziplist-entries 512

hash-max-ziplist-value 64

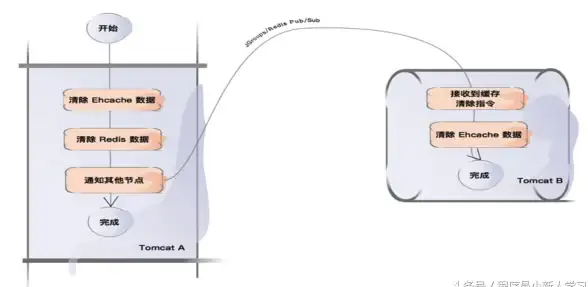

list-max-ziplist-size -2Redis与其他组件的协同作战

Redis+MySQL数据同步方案

基于binlog的异步同步架构:

MySQL -> Canal -> Kafka -> Redis更新服务 -> Redis集群Redis+Elasticsearch缓存搜索

def search_products(query):

cache_key = f"search:{md5(query)}"

cached = redis.get(cache_key)

if cached:

return json.loads(cached)

# ES查询

results = elasticsearch.search(

index="products",

body={"query": {"match": {"title": query}}}

)

# 缓存结果

redis.setex(cache_key, 300, json.dumps(results))

return results

Redis+消息队列实现削峰

// 订单创建限流示例

public void createOrder(Order order) {

String rateLimitKey = "order_rate:" + Instant.now().getEpochSecond();

long current = redis.incr(rateLimitKey);

if (current == 1) {

redis.expire(rateLimitKey, 1);

}

if (current > 1000) { // 超过阈值进入队列

mq.send("order_queue", order);

} else {

processOrder(order);

}

}

2025年Redis新特性实战

Redis 8.2的几个杀手级功能:

-

多线程I/O:在redis.conf中启用

io-threads 4 io-threads-do-reads yes -

函数式操作:直接在Redis中运行JS代码

redis.fcall("my_script", ["arg1", "arg2"]) -

AI集成:直接运行机器学习模型

AI.MODELRUN product_recommender USER:123

在分布式系统中用好Redis,就像给赛车装上涡轮增压器,但记住,没有银弹——去年我们遇到的一个坑是过度依赖Redis导致数据库技能退化,合理的使用原则是:Redis处理热数据,数据库处理全量数据,两者协同而非替代。

最后送大家一个Redis配置检查清单:

- 是否设置了合理的内存淘汰策略?

- 是否有完整的监控告警机制?

- 是否定期进行慢查询分析?

- 是否有备份和容灾方案?

- 是否考虑了安全配置(禁用危险命令、设置密码)?

用好Redis,让你的分布式系统飞起来!

本文由 易旭尧 于2025-07-30发表在【云服务器提供商】,文中图片由(易旭尧)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/484240.html

发表评论