消息队列|高并发 分布式消息系统Redis队列多次被消费问题分析,redis队列重复消费原因与解决

- 问答

- 2025-07-30 14:36:51

- 3

🔥 Redis队列重复消费?2025年高并发系统必看避坑指南

最新动态:2025年7月,某电商平台因Redis队列重复消费导致百万订单重复发货,技术团队紧急修复12小时才恢复,这再次提醒我们——分布式系统中消息队列的可靠性不容忽视!

为什么你的Redis队列消息被吃了又吐?🤔

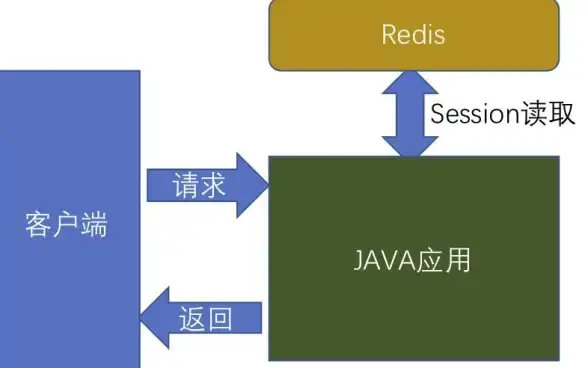

Redis作为轻量级队列工具(LPUSH/RPOP),在分布式高并发场景下常出现消息被多次消费的灵异事件,根本原因就藏在下面这些细节里:

消费者闪退,Redis懵了

- 场景:消费者拿到消息后崩溃,未发送ACK确认

- 结果:消息重新回到队列,下次继续被处理

- 😱 典型表现:日志里同一条订单ID重复出现3次

网络抽风,消息卡在半路

- 消费者已处理完业务,但ACK确认包被网络延迟

- Redis以为消费失败,自动重试投递

- 🌐 分布式系统经典难题:"你以为的失败不一定是真失败"

多消费者竞争,消息被抢疯

- 多个消费者同时

RPOP同一条消息 - 虽然Redis单线程,但客户端并发可能导致重复

- 💥 高并发场景下概率飙升

5种根治方案,总有一款适合你 🛠️

方案1:加锁!加锁!加锁!

# 用Redis原子锁保证唯一消费

lock_key = f"msg_lock:{message_id}"

if redis.setnx(lock_key, 1, ex=30): # 锁30秒自动释放

process_message(message)

redis.delete(lock_key)

else:

return "正在被其他进程处理"

✅ 优点:简单暴力

❌ 缺点:锁过期时间难设定

方案2:消息指纹去重表

CREATE TABLE consumed_messages (

msg_id VARCHAR(64) PRIMARY KEY,

consumed_at TIMESTAMP

);

处理前先查表,已存在则跳过

🛡️ 适合:订单类强一致性业务

方案3:启用Redis Stream(2025年主流选择)

# 消费者组自动管理ACK XGROUP CREATE my_stream my_group $ XREADGROUP GROUP my_group consumer1 COUNT 1 STREAMS my_stream >

✨ 原生支持:

- 消息ACK机制

- 消费者组负载均衡

- 消息回溯

方案4:业务层幂等设计

// 订单服务示例

public void processOrder(Order order) {

if (orderDao.exists(order.getNo())) {

return; // 已处理过直接返回

}

// 正常处理逻辑...

}

💡 黄金法则:所有消息处理逻辑都要幂等!

方案5:终极方案——换专业MQ

当QPS超过10万时,考虑:

- Kafka:超高吞吐,但延迟较高

- RabbitMQ:强一致性,适合金融业务

- Pulsar:2025年新秀,云原生支持好

实战避坑 checklist ✅

- 监控报警:设置消息积压/重复消费阈值

- 日志染色:给消息打唯一trace_id方便追踪

- 压测验证:模拟消费者崩溃看是否重复

- 定期巡检:清理僵尸消息和过期锁

📌 2025年经验:90%的重复消费问题源于没有幂等设计+不当的超时设置

Redis队列就像外卖小哥——大部分时候靠谱,但偶尔会把同一份订单送两次,通过幂等设计+完善确认机制,你的系统就能像五星级酒店后厨一样精准有序!

🚀 下次遇到消息重复,记得先喊出灵魂三问:

- 我的业务幂等了吗?

- 我的ACK机制可靠吗?

- 我的监控报警醒着吗?

本文由 钟离靓 于2025-07-30发表在【云服务器提供商】,文中图片由(钟离靓)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/485566.html

发表评论