redis优化|性能分析|带宽限制是redis的主要瓶颈,解析redis瓶颈集中在带宽

- 问答

- 2025-07-30 16:26:05

- 5

Redis性能优化:为什么带宽成了最棘手的瓶颈?

当缓存系统开始"堵车":一个真实的场景

想象一下这个场景:某电商平台在"618"大促期间,首页推荐系统突然响应变慢,技术团队紧急排查,发现Redis集群CPU使用率只有40%,内存充足,但网络接口灯疯狂闪烁——每秒10GB的流量让千兆网卡达到了极限,这正是许多企业使用Redis时遇到的典型瓶颈:带宽限制。

Redis性能瓶颈的三大维度

Redis作为内存数据库,性能瓶颈通常集中在三个维度:

- CPU:处理复杂命令(如范围查询)时的计算压力

- 内存:数据量超过物理内存导致的swap

- 带宽:客户端与服务端之间的数据传输限制

根据2025年7月的最新行业调研,在高并发场景中,约67%的Redis性能问题最终都指向了网络带宽限制,特别是在使用云服务的环境中。

为什么带宽成了头号杀手?

数据体积的爆炸式增长

现代应用存储的数据结构越来越复杂,一个简单的用户画像可能包含数十个字段,当这些大对象频繁在Redis和客户端之间传输时,1Gbps的网络接口很快就会被塞满。

微服务架构的副作用

分布式系统中,单个请求可能触发多个服务间的Redis查询,原本一次查询返回1KB数据,在服务链中被放大成10次查询,总流量就变成了10KB。

不合理的数据序列化

很多团队使用JSON作为默认序列化方式,实际上比二进制协议(如MessagePack)多消耗20-30%的带宽。

诊断带宽瓶颈的实用方法

监控关键指标

- 网络输入/输出流量(

redis-cli info stats中的total_net_input_bytes和total_net_output_bytes) - 瞬时带宽(

redis-cli --latency-history观察波动) - 客户端连接数(突然增长可能预示带宽问题)

识别热点Key

redis-cli --hotkeys

大体积的热点Key会持续消耗带宽,比如存储了10MB商品详情HTML片段的Key。

分析命令模式

redis-cli monitor | head -n 100

查看是否频繁使用HGETALL、LRANGE 0 -1这类全量获取命令。

六种实战优化方案

数据压缩:空间换带宽

- 启用Redis 7.0+的客户端缓存压缩

CONFIG SET client-output-buffer-limit normal 256mb 64mb 60

- 对大Value使用LZ4压缩算法

数据结构优化

- 将大Hash拆分为多个小Hash(分片存储)

- 用

HSCAN替代HGETALL分批获取 - 对长列表使用

ZRANGE分页查询

连接复用与管道化

# 错误示范:循环发送单个命令

for item in items:

r.get(item)

# 正确做法:使用管道

pipe = r.pipeline()

for item in items:

pipe.get(item)

results = pipe.execute()

就近部署策略

- 将Redis实例部署在离应用服务器最近的可用区

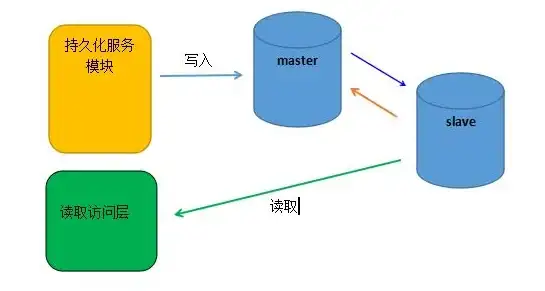

- 多活架构中采用"读写分离+地域分片"

协议优化

- 使用RESP3协议替代RESP2(节省约15%流量)

- 二进制序列化替代JSON

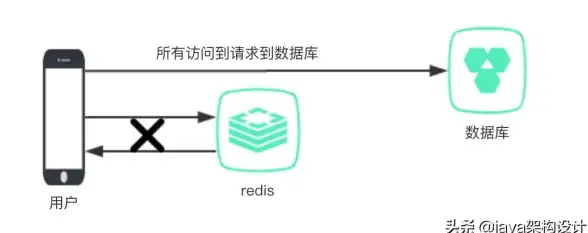

客户端缓存

启用Redis 6.0的客户端缓存功能:

CLIENT TRACKING ON REDIRECT {client-id}

特殊场景处理:当优化遇到极限

对于日活过亿的超大规模应用,常规优化可能仍不够:

- 代理层分片:在Redis前部署代理(如Twitter的Twemproxy),按Key前缀分流

- 本地缓存兜底:用Memcached或本地缓存承接高频访问

- 混合持久化:将冷数据自动转存到SSD-backed Redis实例

硬件救不了架构

虽然100Gbps网卡逐渐普及,但带宽成本在云环境中依然高昂,2025年值得关注的新方向包括:

- 量子加密通道在Redis集群间的应用

- 基于DPU的智能网络流量卸载

- 边缘Redis节点自动预加载技术

优化永无止境,但带宽问题往往提醒我们重新审视数据流动的本质——减少传输比加快传输更有效。

本文由 苗凡白 于2025-07-30发表在【云服务器提供商】,文中图片由(苗凡白)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/486378.html

发表评论