Redis优化 问题解析 深入浅出解决Redis常见问题的最佳答案,redis问题答案

- 问答

- 2025-07-30 23:21:46

- 8

Redis优化 | 问题解析 | 深入浅出解决Redis常见问题的最佳答案

场景引入:当你的Redis突然"罢工"了

想象一下这个场景:周五晚上9点,你的电商平台正在经历一波促销高峰,突然监控系统疯狂报警——Redis响应时间飙升,部分请求直接超时,客服电话被打爆,技术团队紧急集合,这时候,如果你提前了解过Redis常见问题的解决方案,可能10分钟就能恢复;否则,可能就是一个通宵的排查...

别担心,今天我们就用最直白的语言,聊聊Redis那些"坑"和填坑的最佳姿势。

Redis为什么突然变慢了?

1 内存不足引发的连锁反应

"老张,Redis怎么突然慢得像蜗牛?"——这可能是运维同学最常听到的抱怨之一。

问题表现:原本毫秒级响应的Redis,突然变成秒级响应,甚至超时。

根本原因:

- 内存达到maxmemory限制,Redis开始频繁淘汰数据

- 开启了swap,导致部分数据被交换到磁盘

- 大key导致内存分配不均衡

解决方案:

# 查看内存使用情况 redis-cli info memory # 紧急处理(临时扩容) config set maxmemory 8GB # 根据实际情况调整 # 长期方案 1. 合理设置maxmemory-policy(如volatile-lru) 2. 对大key进行拆分(比如一个10MB的hash拆成10个1MB的) 3. 添加监控,在内存使用达到80%时提前告警

2 持久化导致的性能抖动

典型场景:每到整点,Redis就会出现短暂卡顿。

幕后黑手:

- RDB持久化时fork阻塞

- AOF重写占用大量IO

优化方案:

# 检查持久化配置 config get save config get appendonly # 生产环境推荐配置 save 900 1 # 15分钟至少有1个key变化才保存 save 300 10 # 5分钟至少有10个key变化才保存 appendonly yes # 开启AOF appendfsync everysec # 折衷方案

专业建议:对于超大规模实例,考虑禁用持久化,改用从节点做持久化。

"我的数据怎么不见了?"——数据丢失问题

1 数据过期不准确

用户抱怨:"我设置了10分钟过期,为什么8分钟就没了?"

真相:Redis的过期删除是惰性+定期两种方式结合:

- 惰性删除:访问key时检查是否过期

- 定期删除:每100ms随机检查部分key

解决方案:

# 检查内存中已过期但未删除的key数量 redis-cli info stats | grep expired_keys # 调整配置(redis.conf) hz 10 # 提高定期删除频率(默认是10,最大500,但会增加CPU负担)

2 主从切换导致的数据丢失

灾难场景:主节点宕机,从节点晋升为主节点后,部分写入数据丢失。

核心原因:主从复制是异步的,主节点写入后还没同步到从节点就挂了。

终极方案:

# 要求至少N个从节点确认才认为写入成功 min-slaves-to-write 1 min-slaves-max-lag 10 # 从节点延迟不超过10秒

连接数爆满怎么办?

1 "Too many connections"错误

典型表现:应用无法连接Redis,日志显示达到最大连接数限制。

快速止血:

# 临时增加连接数限制

config set maxclients 10000

# 查看连接来源统计

redis-cli client list | awk '{print $2}' | cut -d= -f2 | sort | uniq -c | sort -nr

长期方案:

- 实现连接池(Java推荐使用Lettuce而不是Jedis)

- 合理设置超时:

timeout 300(5分钟无活动自动断开) - 对于Web应用,考虑使用Redis代理(如Twemproxy)

缓存雪崩/穿透/击穿——三大缓存杀手

1 缓存雪崩:大量key同时失效

场景还原:零点整,首页所有商品缓存同时过期,数据库瞬间被打垮。

防御策略:

# 设置过期时间时添加随机值 EXPIRE key 3600 + rand(600) # 实际1小时~1小时10分钟随机过期

2 缓存穿透:查询不存在的数据

恶意攻击:不断请求不存在的商品ID,每次都穿透到数据库。

解决方案:

- 布隆过滤器拦截

- 缓存空值:

SET nonexistent_key "NULL" 60

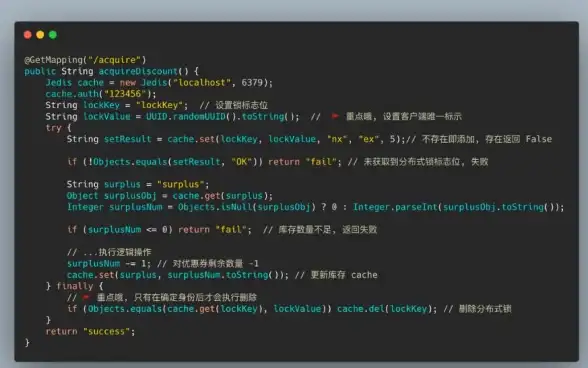

3 缓存击穿:热点key突然失效

明星商品效应:某爆款商品缓存过期瞬间,百万请求涌入数据库。

终极防御:

-- 使用Redis实现互斥锁

local key = KEYS[1]

local value = ARGV[1]

local ttl = tonumber(ARGV[2])

if redis.call("SETNX", key, value) == 1 then

redis.call("PEXPIRE", key, ttl)

return true

else

return false

end

那些"高级"但实用的优化技巧

1 内存优化:小就是快

惊人事实:一个10KB的key比10个1KB的key占用更多内存!

优化手段:

# 使用hash代替多个独立key HMSET user:1000 name "张三" age 30 city "北京" # 使用ziplist编码(redis.conf配置) hash-max-ziplist-entries 512 hash-max-ziplist-value 64

2 管道(pipeline)提升10倍吞吐量

对比测试:

# 普通模式(100次往返)

for i in range(100):

r.get(f"key_{i}")

# 管道模式(1次往返)

with r.pipeline() as pipe:

for i in range(100):

pipe.get(f"key_{i}")

results = pipe.execute()

3 延迟监控:找出慢查询

诊断工具:

# 设置慢查询阈值(微秒) config set slowlog-log-slower-than 10000 # 查看慢查询日志 slowlog get 10

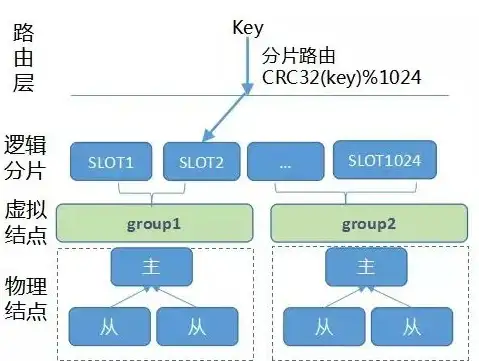

Redis集群常见坑点

1 数据倾斜:某些节点特别忙

排查方法:

redis-cli --cluster check 127.0.0.1:7000 | grep "keys in"

# 解决方案:

1. 使用hash tag强制相关key分配到同一节点:{user1000}.orders

2. 对大key进行拆分

2 集群扩容时的性能下降

经验之谈:迁移slot时,性能可能下降30%,建议:

- 在业务低峰期操作

- 分批迁移:

redis-cli --cluster reshard --cluster-from ... --cluster-to ... --cluster-slots 100 ...

终极建议:Redis不是银弹

虽然Redis很强大,但记住:

- 不适合存储大文件(超过10KB就考虑其他方案)

- 持久化不能替代备份(定期RDB备份到其他服务器)

- 单线程特性意味着长时间命令会阻塞所有请求(避免使用KEYS *)

最后送大家一个检查清单,遇到问题时可以快速排查:

- 内存是否快满了?→

info memory - 连接数是否超标?→

info clients - 是否有慢查询?→

slowlog get - 持久化是否正在进行?→

info persistence - 主从同步是否正常?→

info replication

掌握这些技巧,你就能像Redis专家一样思考和解决问题了!

本文由 镜谷蓝 于2025-07-30发表在【云服务器提供商】,文中图片由(镜谷蓝)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/489328.html

发表评论