Kafka 数据迁移 Kafka运维:你真的了解数据迁移的核心要点吗?

- 问答

- 2025-07-31 03:49:49

- 2

🚀 Kafka运维:你真的了解数据迁移的核心要点吗?

场景引入:

凌晨3点,你被报警短信惊醒——生产环境的Kafka集群磁盘即将爆满!📉 业务部门要求3天内完成数据迁移,但迁移过程中消费者频繁报错,数据一致性校验失败… 这时候才意识到,Kafka数据迁移远不是cp -r那么简单。

🔍 数据迁移的三大灵魂拷问

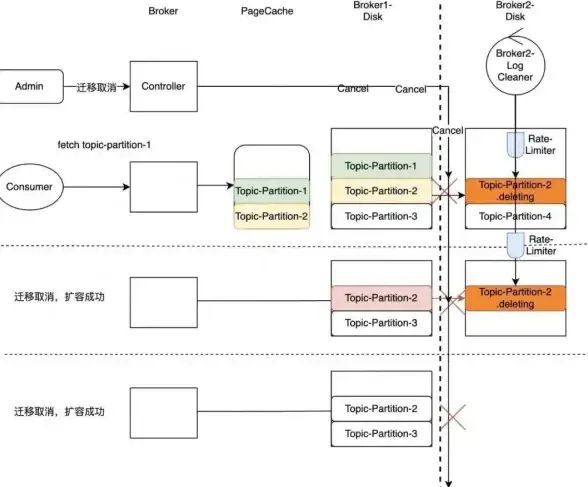

迁移前:你的方案能避开这些坑吗?

- “直接拷贝日志文件”行不行?

❌ 大忌!Kafka的log.dirs可能包含正在写入的活跃分段,直接拷贝会导致数据错乱,正确姿势是同步镜像工具(如MirrorMaker2)或分区重分配。 - “停机迁移”还是“热迁移”?

💡 业务低峰期停机迁移最安全(但需要协调上下游),热迁移则需监控同步延迟和重复消费风险。

迁移中:这些指标你敢不看?

- 监控看板必备项:

BytesIn/BytesOut:流量突增可能压垮网络UnderReplicatedPartitions:非零值=有副本同步滞后ConsumerLag:消费者是否被迁移拖垮?

- 隐藏雷区:

- 跨机房迁移时,网络带宽和ACL配置(比如突然发现新集群没开SASL认证…)

迁移后:如何证明数据没丢?

- 校验三板斧:

- 消息数比对:用

kafka-run-class工具统计迁移前后分区的消息总数 - 末端偏移量检查:

kafka-consumer-groups对比LSO和HW - 抽样校验:手动生产-消费测试关键业务Topic

- 消息数比对:用

🛠️ 实战技巧:MirrorMaker2迁移避坑指南

# 示例:MM2的增量同步配置(关键参数) echo ' clusters = source, target source.bootstrap.servers = kafka1:9092 target.bootstrap.servers = kafka2:9092 # 防止网络抖动导致频繁重试 tasks.max = 10 retries = 2147483647 # 同步进度监控 offset.syncs.topic.replication.factor = 3 ' > mm2.properties

⚠️ 注意:

- 心跳超时:默认

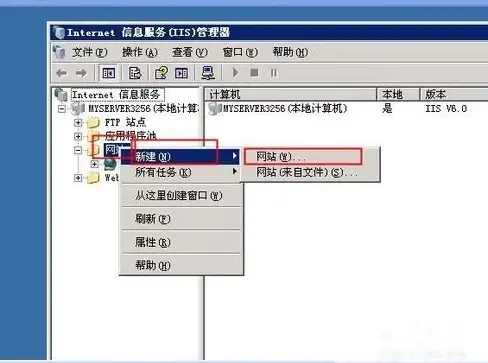

session.timeout.ms=10s,跨机房时建议调大 - 动态Topic:若源集群有自动创建的Topic,需提前在目标集群预建同名Topic

💡 来自2025年的经验总结

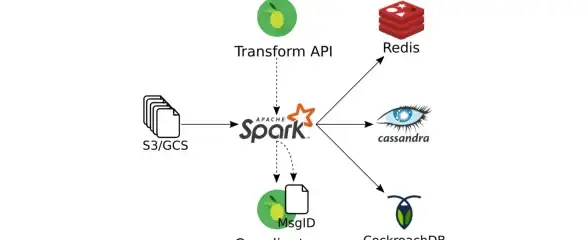

- 冷知识:Kafka 3.5+版本已支持分层存储(Tiered Storage),迁移前评估是否改用S3归档历史数据

- 血泪教训:某厂因迁移时未同步ACL策略,导致新集群权限失控,被安全部门通报…

最后一句:数据迁移不是“搬硬盘”,而是业务连续性的精密手术——预案、监控、回滚缺一不可! 🔧

(注:本文策略基于Kafka 3.4+版本及2025年运维实践)

本文由 贵嘉福 于2025-07-31发表在【云服务器提供商】,文中图片由(贵嘉福)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/491067.html

发表评论