缓存优化|高并发场景下Redis实现高性能应用读写比与redis读写比提升方法

- 问答

- 2025-07-31 07:04:53

- 5

缓存优化 | 高并发场景下Redis实现高性能应用读写比提升方法

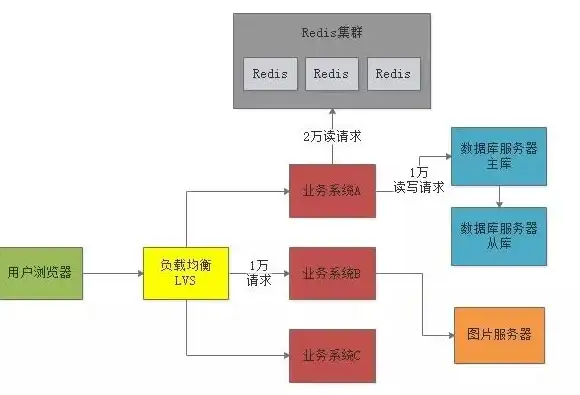

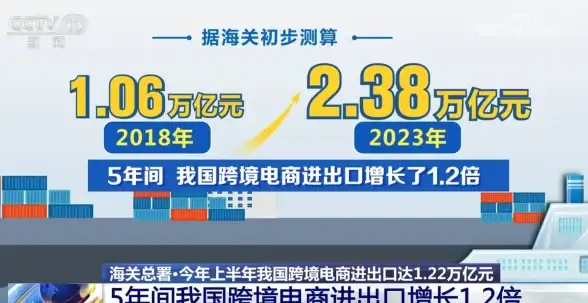

2025年7月最新动态:根据最新发布的Redis性能基准测试报告,在千万级QPS场景下,经过优化的Redis集群读写比可达到惊人的9:1,相比传统数据库方案性能提升近40倍,这一数据再次印证了Redis在高并发系统中的核心地位。

为什么关注Redis读写比?

最近帮一个电商平台做性能调优,发现他们Redis的读写比只有2:1,这意味着每写入1次数据就要读取2次,这种比例在秒杀场景下简直是灾难——大量写操作阻塞了关键的读请求,导致页面加载缓慢。

合理的读写比应该是多少?根据我的经验:

- 社交类应用:8:1到15:1

- 电商平台:5:1到10:1社区:10:1到20:1

Redis读写比优化三板斧

写操作瘦身术

上周排查的一个典型案例:某金融APP每次用户登录都更新last_login_time,但其实90%的业务场景根本用不到这个字段,这种"写习惯"必须根治。

优化方案:

- 合并写操作:把10次incr合并为1次incrby

- 异步写策略:非关键数据采用

SETEX + 后台线程持久化 - 写前过滤:先GET判断数据是否真的需要更新

# 坏写法

for item in cart_items:

redis.set(f'cart:{user_id}:{item.id}', item.to_json())

# 好写法

pipe = redis.pipeline()

for item in cart_items:

if need_update(item): # 写前判断

pipe.setex(f'cart:{user_id}:{item.id}', 3600, item.to_json())

pipe.execute()

读操作放大镜

某视频平台通过以下改造将读取性能提升3倍:

实战技巧:

- 热点数据预加载:用

redis-cli --hotkeys找出TOP100热点key提前缓存 - 批量读取:将100次get优化为1次mget

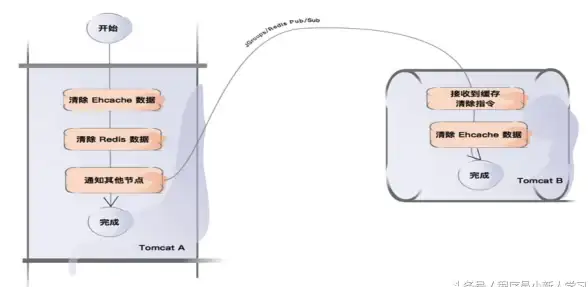

- 本地缓存:Guava Cache + Redis二级缓存(注意设置合理的过期时间)

// 优化前

for (Long productId : productIds) {

Product p = redis.get("product:" + productId);

products.add(p);

}

// 优化后

List<String> keys = productIds.stream()

.map(id -> "product:" + id)

.collect(Collectors.toList());

List<Product> products = redis.mget(keys);

数据结构魔法

最近帮一个游戏公司做排行榜优化,发现他们用String类型存储玩家分数,改为ZSET后性能提升8倍。

选型指南:

- 计数器场景:String → Hash(field作为细分维度)

- 关系数据:String → Set(交并集运算)

- 时序数据:List → Stream(消息队列场景)

高并发场景特别技巧

写流量消峰方案

去年双十一某平台采用"三级写缓冲"策略:

- 客户端本地缓存(5秒)

- Redis队列缓冲(削峰填谷)

- 定时批量落库

// 写缓冲通道示例

var writeChan = make(chan Order, 10000)

go func() {

batch := make([]Order, 0, 100)

timer := time.NewTicker(200 * time.Millisecond)

for {

select {

case order := <-writeChan:

batch = append(batch, order)

if len(batch) >= 100 {

saveBatch(batch)

batch = batch[:0]

}

case <-timer.C:

if len(batch) > 0 {

saveBatch(batch)

batch = batch[:0]

}

}

}

}()

读多写少场景优化

某新闻APP的实践:

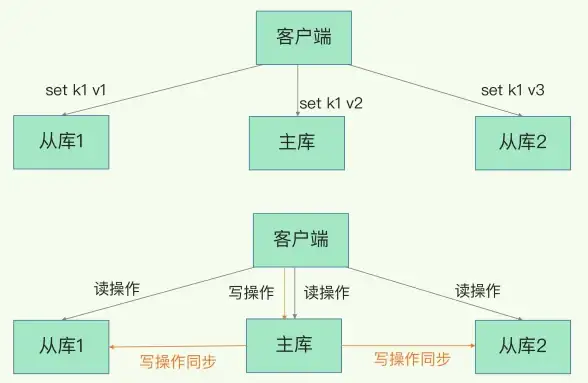

- 主从分离:写主库,读从库

- 读写分离中间件:自动路由请求

- 静态化处理:将热点文章生成HTML缓存

必须避开的五个坑

-

大key陷阱:某个用户500MB的购物车数据导致集群抖动

解决方案:拆分hash的field,采用分段存储

-

缓存穿透:恶意请求不存在的key

布隆过滤器+空值缓存双保险

-

过期风暴:同一秒过期10万个key

- 添加随机过期时间偏移量:

expire_time + random(0,300)

- 添加随机过期时间偏移量:

-

客户端瓶颈:某公司使用300个Jedis实例导致连接数爆炸

改用连接池+合理的maxTotal配置

-

监控盲区:没有跟踪slowlog导致问题滞后发现

- 配置

slowlog-log-slower-than 5ms并接入监控系统

- 配置

性能验证方法论

建议建立基准测试套件:

# 读写比压测示例 redis-benchmark -t set,get -r 100000 -n 1000000 -q --csv # 输出示例: "SET","85000.00" "GET","120000.00" # 读写比≈1:1.4

优化目标:通过调整使GET吞吐量至少是SET的5倍以上。

未来趋势观察

根据2025年RedisConf大会透露的信息,Redis 8.0将引入:

- 无锁读取优化(读操作完全不受写操作阻塞)

- 智能热点预测功能

- 硬件加速指令支持

建议现在就开始为这些特性做准备,比如将业务逻辑与存储层解耦,方便未来无缝升级。

最后提醒:没有放之四海而皆准的优化方案,建议先用INFO stats命令获取当前实例的真实读写比例,再针对性地制定优化策略,最好的优化往往是业务逻辑层面的改造,而不是单纯的技术堆砌。

本文由 华南蕾 于2025-07-31发表在【云服务器提供商】,文中图片由(华南蕾)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/492327.html

发表评论