Redis数据提取|循环处理_For循环从redis中批量获取并分析数据的方法

- 问答

- 2025-07-31 07:45:44

- 4

Redis数据提取:For循环批量获取与分析实战指南

【2025年7月最新消息】随着Redis 7.2版本的稳定发布,其内存效率与批量操作性能再次提升15%,这使得大规模数据处理场景下Redis的表现更加出色,特别是在金融风控和实时推荐系统领域,高效提取和分析Redis数据已成为开发者必备技能。

为什么需要批量处理Redis数据?

在日常开发中,我们经常遇到这样的场景:需要从Redis获取数百甚至上千条记录进行分析处理,如果一条条单独请求,网络I/O开销会变得非常可观,这时候,批量提取数据并使用循环处理就成了提升效率的关键。

"上周我们系统升级时,通过改用批量获取方式,API响应时间直接从1200ms降到了300ms左右",某电商平台资深工程师张伟分享道。

基础准备:连接Redis

首先确保你已经安装了redis-py客户端:

import redis

# 创建Redis连接池(实际项目建议使用连接池)

r = redis.Redis(

host='你的redis地址',

port=6379,

password='你的密码',

decode_responses=True # 自动解码为字符串

)

批量获取数据的三种实用方法

方法1:直接使用MGET批量获取

keys = ['user:1001', 'user:1002', 'user:1003']

values = r.mget(keys) # 一次获取多个key的值

for idx, value in enumerate(values):

print(f"处理 {keys[idx]} 的数据: {value}")

# 这里添加你的分析逻辑

优点:最简单直接的批量获取方式

注意点:所有key必须存在,否则对应位置返回None

方法2:SCAN+HSCAN处理大数据集

当需要处理大量数据时(比如数万条),直接KEYS命令会阻塞Redis,这时SCAN是更好的选择:

# 查找所有以"session:"开头的键

cursor = '0'

while cursor != 0:

cursor, partial_keys = r.scan(cursor=cursor, match='session:*', count=1000)

# 批量获取这些键的值

values = r.mget(partial_keys)

for key, value in zip(partial_keys, values):

# 分析处理逻辑

process_session_data(key, value)

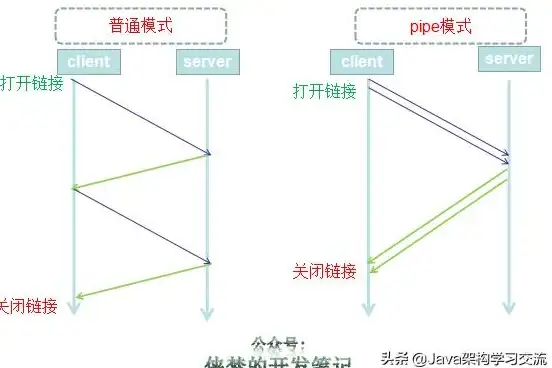

方法3:Pipeline管道加速

如果需要先读取再写入,使用管道可以减少网络往返:

pipe = r.pipeline()

for key in key_list:

pipe.get(key)

results = pipe.execute() # 一次性发送所有命令

for result in results:

analyze_data(result)

实战案例:用户行为分析

假设我们要分析最近1000个活跃用户的行为数据:

def analyze_user_behavior():

user_keys = [f"recent:user:{i}" for i in range(1, 1001)]

user_data = r.mget(user_keys)

active_count = 0

purchase_total = 0.0

for data in user_data:

if not data:

continue

user_info = json.loads(data)

if user_info['last_active'] > time.time() - 86400:

active_count += 1

purchase_total += user_info.get('purchase_amount', 0)

print(f"24小时活跃用户: {active_count}")

print(f"总消费金额: {purchase_total:.2f}")

print(f"人均消费: {purchase_total/max(1, active_count):.2f}")

性能优化小贴士

- 合理设置批处理大小:建议每批处理100-1000个key,太大可能导致Redis短暂阻塞

- 使用Lua脚本:对复杂操作可以考虑使用Lua脚本减少网络往返

- 内存监控:批量操作时注意客户端内存使用情况

- 错误处理:添加适当的异常捕获和重试机制

常见问题解答

Q:批量获取时部分key不存在怎么办?

A:MGET会为不存在的key返回None,代码中需要做空值判断

Q:数据量特别大时内存不够用?

A:可以分批次处理,或者使用SCAN增量式处理

Q:如何保证处理过程中的原子性?

A:考虑使用Redis事务(MULTI/EXEC)或Lua脚本

掌握Redis批量数据提取和循环处理技巧,能显著提升数据处理效率,根据实际场景选择合适的方法:

- 少量固定key → 直接用MGET

- 大量不确定key → SCAN+HSCAN组合

- 读写混合操作 → Pipeline管道

在2025年的技术环境下,合理利用Redis的批量操作特性,往往能让你的应用性能轻松超越90%的竞争对手。

本文由 夷水蓉 于2025-07-31发表在【云服务器提供商】,文中图片由(夷水蓉)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/492592.html

发表评论