上一篇

数据管理 数据去重 如何使用数据库不重复函数来避免数据重复,数据库不重复函数

- 问答

- 2025-07-31 10:30:53

- 5

🔍 数据去重实战:用数据库不重复函数告别重复数据烦恼

📢 最新动态(2025年7月)

近期某电商平台因用户地址表重复录入导致百万级配送错误,技术团队紧急采用UNIQUE约束+DISTINCT组合拳清理数据,这再次提醒我们:数据去重不是可选项,而是必答题!

为什么数据去重这么重要?

重复数据就像鞋里的小石子🤯——看似不起眼,但会引发连锁问题:

- 存储浪费:相同信息存10次=9次白花钱

- 统计失真:重复用户导致DAU虚高30%?老板要找你喝茶了🍵

- 业务风险:给同一个客户发5次优惠券?财务和用户都会暴走💥

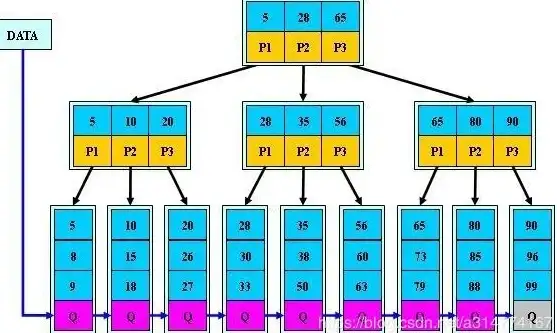

数据库去重四大神器

🛡️ 神器1:UNIQUE约束(建表时防御)

CREATE TABLE users (

user_id INT PRIMARY KEY,

email VARCHAR(100) UNIQUE, -- 邮箱强制唯一

phone VARCHAR(20) UNIQUE -- 手机号也唯一

);

适用场景:注册信息、商品SKU等天然唯一的数据

效果:试图插入重复值?数据库直接拒接并翻白眼🙄

🧹 神器2:DISTINCT关键字(查询时打扫)

-- 找出所有不重复的城市 SELECT DISTINCT city FROM customers; -- 多列联合去重 SELECT DISTINCT first_name, last_name FROM employees;

注意点:

- 大数据表慎用,可能拖慢查询⏳

- 和

COUNT组合超好用:SELECT COUNT(DISTINCT product_id)

🎯 神器3:GROUP BY分组(灵活去重)

-- 每个部门的最新入职记录 SELECT department_id, MAX(hire_date) FROM employees GROUP BY department_id;

Pro技巧:

-- 用HAVING找出重复值(出现次数>1的) SELECT email, COUNT(*) FROM users GROUP BY email HAVING COUNT(*) > 1;

🧰 神器4:窗口函数(高级玩家必备)

-- 保留每个用户最新的一条订单

WITH ranked_orders AS (

SELECT *,

ROW_NUMBER() OVER(PARTITION BY user_id ORDER BY order_date DESC) AS rn

FROM orders

)

SELECT * FROM ranked_orders WHERE rn = 1;

适用场景:需要保留特定版本记录的复杂去重

实战避坑指南 🚧

- 警惕NULL陷阱:UNIQUE约束中多个NULL不会被判重复(MySQL特性)

- 大小写敏感:

'Apple'和'apple'可能被当作不同值 - 组合唯一键:

ALTER TABLE orders ADD CONSTRAINT uniq_order UNIQUE (customer_id, product_id, order_date);

- 去重后记得加索引:

CREATE INDEX idx_email ON users(email);

该选哪种方法?决策树帮你选 🌳

是否需要永久防止重复?

├─ 是 → UNIQUE约束

└─ 否 → 需要处理现有数据?

├─ 是 → GROUP BY/DISTINCT

└─ 否 → 需要复杂规则?

├─ 是 → 窗口函数

└─ 否 → DISTINCT简单搞定终极建议 💡

- 小数据量:DISTINCT快速搞定

- 生产环境:UNIQUE约束+定期清理双保险

- 历史数据迁移:先用

GROUP BY检测重复率再处理

下次当你看到重复数据时,就笑着打开SQL窗口吧——现在你至少有4种方法可以"消灭"它们啦!🎉

(注:本文示例兼容MySQL/PostgreSQL,其他数据库语法可能略有差异)

本文由 羿俊彦 于2025-07-31发表在【云服务器提供商】,文中图片由(羿俊彦)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/493663.html

发表评论