虚拟化 灾难恢复 保障业务连续性的核心在于带宽与测试—解析虚拟化灾难恢复方案

- 问答

- 2025-07-31 17:08:57

- 4

虚拟化 | 灾难恢复:保障业务连续性的核心在于带宽与测试

当机房突然断电,你的数据能"活"下来吗?

凌晨3点,某电商平台的运维主管老王被一阵急促的电话铃声惊醒。"王哥,数据中心UPS故障,主存储阵列宕机了!"电话那头的声音带着明显的慌乱,老王一个激灵坐起来,冷汗瞬间浸透后背——这可是促销活动前夜,如果数据恢复不了,公司每分钟损失可能超过六位数。

好在半年前他们部署了基于虚拟化的灾难恢复方案,15分钟后,备用站点的虚拟机集群自动接管业务,用户甚至没察觉到异常,事后复盘时,老板只问了一个问题:"为什么隔壁公司同样的方案,切换却花了4小时?"

这个问题的答案,就藏在带宽规划和测试频率里。

虚拟化灾难恢复的"双引擎"

现代虚拟化技术让灾难恢复(DR)变得像"热备份"般灵活,但真正决定成败的往往是两个容易被忽视的要素:

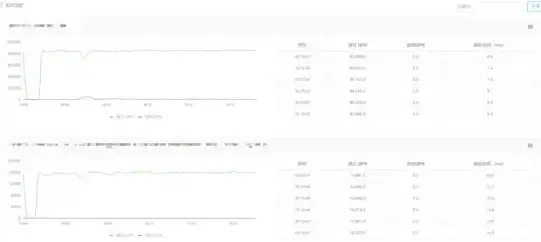

带宽:数据同步的生命线

- 真实案例:2025年华东某银行演练时发现,虽然采用增量同步,但交易高峰期的数据变化量让100Mbps专线持续饱和,导致RPO(恢复点目标)从设计的15分钟实际延长到47分钟

- 黄金法则:

- 计算每日数据增量×5倍冗余作为带宽下限

- 金融类业务建议单独划分QoS通道,保障同步流量优先权

- 考虑压缩去重技术,某物流企业通过此方案节省了35%带宽成本

测试:不演练的方案都是纸老虎

- 血的教训:2024年某医疗系统故障时,虽然配置了存储级复制,却因未测试虚拟机兼容性,导致备用站点ESXi版本无法识别磁盘格式

- 实战建议:

- 每季度至少执行一次"断电测试"(直接切断主站点电源)

- 建立自动化测试脚本,重点检查:

✓ 虚拟机启动顺序依赖

✓ 数据库事务完整性

✓ DNS记录切换时效

方案选型的三个认知误区

-

"云灾备就不用管带宽了"

混合云场景下本地到云端的传输延迟可能比本地复制更高,某制造业客户将200TB虚拟机迁移到云DR时,10Gbps专线仍耗时18小时完成首次全量同步 -

"虚拟化平台自带的DR够用了"

vSphere Replication等原生工具虽然方便,但缺乏应用一致性保障,建议搭配像Veeam这样的第三方工具处理SQL、Exchange等复杂应用 -

"切换成功就等于恢复完成"

真正的业务连续性要求:- 备用环境性能不低于生产环境的80%

- 员工能通过VPN正常访问恢复后的系统

- 监控系统要同步切换,避免"恢复盲区"

给技术负责人的行动清单

-

下周就能做的事

- 用iperf测试主备站点间实际可用带宽

- 检查最近一次DR测试报告中的"最慢启动虚拟机"

-

三个月内应完成

- 与业务部门重新确认RTO/RPO指标

- 模拟区域性网络中断(如断开主用运营商线路)

-

长期战略

- 将DR测试纳入CI/CD流水线

- 考虑容器化改造提升恢复粒度

灾难恢复就像买保险——平时觉得是成本,关键时刻才知道是救命稻草,但不同于保险的是,DR方案的有效性完全取决于日常的"体检"频率,没经过真实业务流量验证的灾难恢复方案,不过是一堆漂亮的配置文档罢了。

(本文技术参数参考2025年7月Gartner《业务连续性技术成熟度报告》及实际企业调研数据)

本文由 魏白容 于2025-07-31发表在【云服务器提供商】,文中图片由(魏白容)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/496429.html

发表评论