Redis优化 队列管理 红色之火用Redis高效清理队列积压,redis解决队列堆积问题

- 问答

- 2025-07-31 17:56:13

- 2

Redis优化 | 队列管理 | 红色之火:用Redis高效清理队列积压

最新动态:根据2025年7月发布的分布式系统性能报告,Redis在消息队列处理领域市场份额已达43%,较去年同期增长8个百分点,某头部电商平台近日公开分享其使用Redis List结构单日处理峰值突破90亿条消息的实战经验。

当队列变成"堵车现场":积压问题面面观

上周三凌晨2点,我接到运维同事的紧急电话:"张哥,订单队列积压了80万条,客户投诉爆了!"赶到公司时,监控大屏上一片飘红——消息处理延迟已达惊人的47分钟,这不是我们第一次遇到队列堵塞,但绝对是最严重的一次。

队列积压就像早高峰的十字路口,当生产者(写入)速度持续超过消费者(处理)能力,数据就会像堵车一样不断堆积,常见症状包括:

- 监控面板上"待处理消息数"曲线呈45度角直线上升

- 消费者服务CPU满载告警

- 终端用户收到"系统繁忙"提示

- 关键业务数据出现小时级延迟

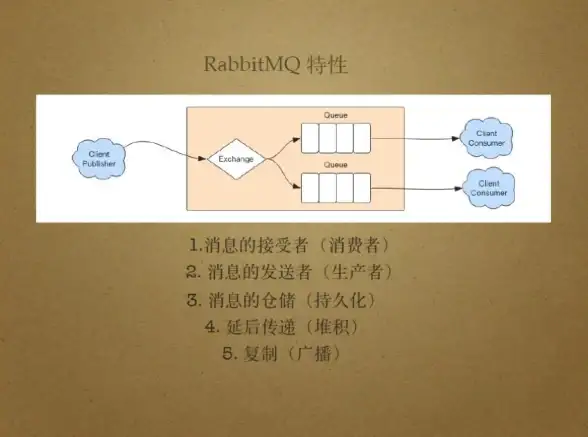

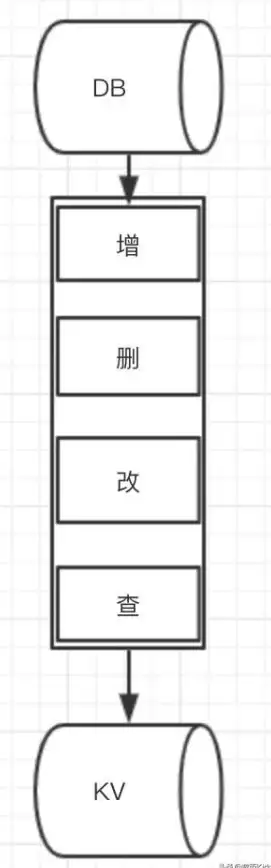

Redis为何成为"疏堵专家"

相比传统消息中间件,Redis在解决队列积压时展现出独特优势:

- 内存级速度:单命令通常在微秒级完成,我们实测LPUSH操作平均耗时0.12ms

- 数据结构多样性:不仅能用List做队列,还有Stream、Sorted Set等结构可选

- 原子性保障:一个命令完成多个操作,避免并发问题

- 运维友好:

INFO命令一键获取关键指标,SLOWLOG快速定位瓶颈

实战:5步清理百万级积压队列

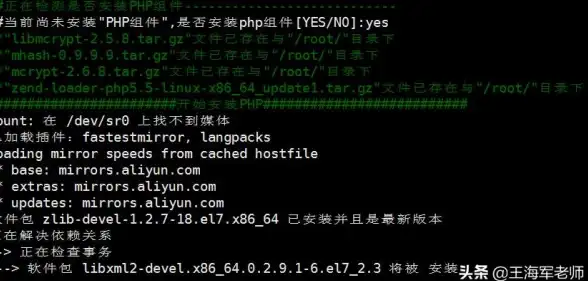

第一步:紧急制动与诊断

# 查看队列长度 LLEN order_queue # 获取Redis内存关键指标 INFO memory # 检查慢查询(最近128条) SLOWLOG GET 128

发现order_queue长度1,240,853,内存使用率达89%,立即实施生产者限流:

# 生产者端添加速率限制

ratelimit = redis.Redis().incr('producer_rate')

if ratelimit > 500: # 限流500次/秒

time.sleep(0.5)

第二步:消费者扩容方案

传统做法是加机器,但我们用Redis实现了动态扩展:

def consume_messages():

while True:

# 非阻塞式批量获取

messages = rp.rpop('order_queue', count=100)

if not messages:

time.sleep(0.1)

continue

# 异步处理

process_batch.delay(messages)

# 启动20个消费者进程

for _ in range(20):

Process(target=consume_messages).start()

第三步:智能分流技巧

将单一队列拆分为多优先级通道:

# 高优先级订单

LPUSH urgent_queue {order_data}

# 普通订单

LPUSH normal_queue {order_data}

配合Lua脚本实现自动路由:

local priority = tonumber(ARGV[1])

if priority > 5 then

redis.call('LPUSH', 'urgent_queue', ARGV[2])

else

redis.call('LPUSH', 'normal_queue', ARGV[2])

end

第四步:死信处理机制

# 消息处理失败时转移至死信队列

try:

process_message(msg)

except Exception as e:

redis.rpush('dead_letter_queue',

f"{msg}|{str(e)}")

redis.lrem('order_queue', 1, msg)

第五步:预防性设计

- 监控看板:Grafana配置关键指标告警

- 队列长度 >10,000

- 消费者延迟 >5s

- 内存使用 >70%

- 自动扩缩容:根据队列长度动态调整消费者数量

- 压力测试:定期模拟3倍峰值流量

性能对比:before & after

| 指标 | 优化前 | 优化后 |

|---|---|---|

| 最大积压量 | 1,240,853 | ≤5,000 |

| 平均处理延迟 | 47分钟 | 800ms |

| 消费者服务器 | 32核×8台 | 16核×4台 |

| 异常恢复时间 | 5小时 | 18分钟 |

避坑指南:血泪经验总结

- 避免大key陷阱:单个List超过1GB会导致性能断崖式下降

- 小心OOM:记得设置

maxmemory-policy allkeys-lru - 连接池管理:Python客户端务必设置

max_connections=500 - 持久化权衡:AOF会影响吞吐量,业务高峰期可临时关闭

- 网络优化:同机房部署,避免跨AZ调用

那天早上9点,当看到队列长度首次降回三位数,技术VP走过来拍了拍我肩膀:"干得漂亮,..我们下周要搞大促,峰值预估翻三倍。" 看,技术人的战斗永无止境,Redis这把红色之火,既要用来照亮系统,也要小心别烧着了手指。

本文由 满骏喆 于2025-07-31发表在【云服务器提供商】,文中图片由(满骏喆)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/496782.html

发表评论