数据库迁移 性能优化 mysql大数据转移高效解决方案与实践

- 问答

- 2025-07-31 20:52:56

- 13

MySQL大数据转移的高效解决方案与实践

场景引入:当数据量成为甜蜜的负担

"小王,咱们的用户数据已经突破5000万了,系统响应速度明显变慢,用户投诉量增加了30%!"听到CTO这句话时,作为技术负责人的我后背一凉,这不是我们第一次遇到数据库性能瓶颈,但这次规模之大前所未有,我们的MySQL数据库在单表千万级数据时表现尚可,但当数据量突破亿级,查询响应时间从毫秒级直接跃升到秒级,某些复杂报表甚至需要几分钟才能返回结果。

这种情况在2025年的互联网公司中并不罕见,随着业务快速增长,原本设计合理的数据库架构逐渐不堪重负,我们需要一套完整的解决方案,既能完成海量数据的安全迁移,又能确保迁移后的系统性能得到显著提升。

MySQL大数据迁移前的准备工作

1 全面评估现有数据库状态

在开始任何迁移工作前,我们必须先给现有数据库做一次"全身体检",这包括:

-

数据量分析:统计各表记录数、索引大小、实际数据大小,我常用的命令是:

SELECT table_name, table_rows, data_length/1024/1024 as data_size_mb, index_length/1024/1024 as index_size_mb FROM information_schema.tables WHERE table_schema = '你的数据库名'; -

查询性能分析:通过慢查询日志找出最耗时的SQL语句,在my.cnf中配置:

slow_query_log = 1 slow_query_log_file = /var/log/mysql/mysql-slow.log long_query_time = 1 -

硬件资源监控:观察CPU、内存、磁盘I/O和网络带宽的使用情况,找出当前系统的瓶颈所在。

2 制定合理的迁移策略

根据数据量和业务需求,我们可以选择不同的迁移方式:

- 全量迁移+增量同步:适用于停机时间窗口充足的情况

- 双写并行切换:适用于对可用性要求极高的系统

- 分批次迁移:适用于超大规模数据,可以按时间范围或业务维度分批处理

在我们的案例中,由于数据量特别大(超过10TB)且业务要求24/7可用,最终选择了双写并行方案,虽然实施复杂度高,但能最大限度保证业务连续性。

MySQL大数据迁移实战方案

1 高效数据迁移工具选型

2025年,我们有更多成熟的工具可以选择:

-

原生工具:

mysqldump:适合中小型数据库,简单但速度较慢mysqlpump:MySQL 8.0+的改进版,支持并行导出mydumper:第三方工具,比mysqldump快很多

-

物理备份工具:

- Percona XtraBackup:开源的物理备份工具,支持热备份

- MySQL Enterprise Backup:Oracle官方商业工具

-

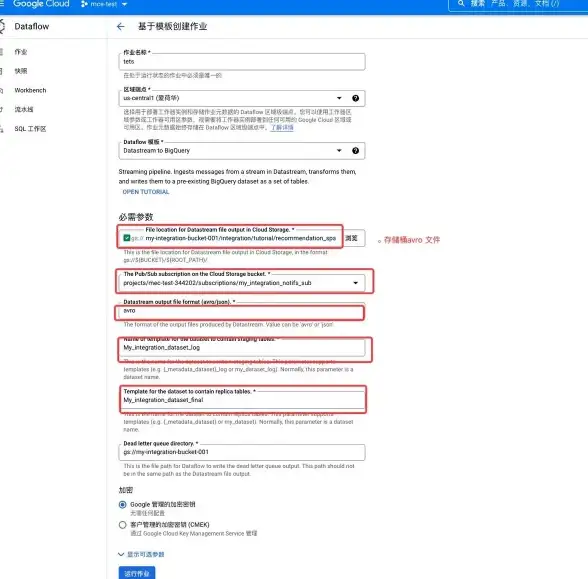

云服务工具:

- AWS DMS(Database Migration Service)

- 阿里云DTS(Data Transmission Service)

经过测试,我们最终选择了Percona XtraBackup作为主要迁移工具,配合自研的校验脚本,在20小时内完成了15TB数据的迁移。

2 分库分表策略设计

对于超大规模数据,简单的迁移并不能解决根本问题,我们同时实施了分库分表方案:

- 水平分片:按用户ID哈希将用户表分散到16个分片

- 垂直拆分:将大字段(如用户行为日志)分离到单独的表中

- 冷热数据分离:将6个月前的历史数据归档到专门的归档库

分片键的选择至关重要,我们遵循以下原则:

- 避免热点问题(如按时间分片会导致所有新数据都写入同一个分片)

- 常用查询条件应该包含分片键

- 尽可能均匀分布数据

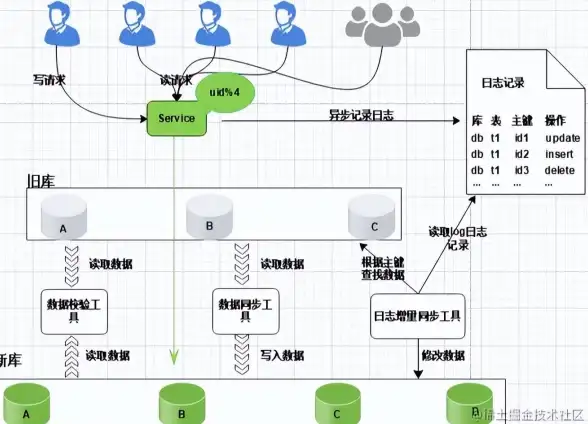

3 迁移过程中的一致性保障

数据一致性问题是大数据迁移中最棘手的挑战之一,我们采用了多种措施:

- 双写校验:新老系统同时写入,通过定时任务比对关键数据

- 增量日志解析:使用MySQL binlog实时同步变更

- 业务层校验:关键业务流程增加数据一致性检查逻辑

- 灰度切换:按用户分组逐步切流,发现问题立即回滚

迁移后的性能优化实践

1 索引优化策略

迁移完成后,我们针对新的数据分布重新设计了索引:

-

复合索引优化:将频繁一起查询的列组合成复合索引

ALTER TABLE user_orders ADD INDEX idx_user_status (user_id, status);

-

覆盖索引设计:确保常用查询只需通过索引就能获取全部所需数据

-- 查询只需要user_name和email,可以设计覆盖索引 SELECT user_name, email FROM users WHERE user_id = 123; ALTER TABLE users ADD INDEX idx_covering (user_id, user_name, email);

-

函数索引应用:MySQL 8.0+支持函数索引,优化特定查询

-- 优化按月份查询 ALTER TABLE orders ADD INDEX idx_month ((MONTH(create_time)));

2 查询优化技巧

-

避免全表扫描:通过EXPLAIN分析执行计划,确保查询使用索引

EXPLAIN SELECT * FROM large_table WHERE create_time > '2025-01-01';

-

合理使用JOIN:小表驱动大表,避免笛卡尔积

-- 好的实践:小表user_types驱动大表users SELECT * FROM user_types t JOIN users u ON t.type_id = u.type_id WHERE t.type_name = 'VIP';

-

分页优化:大数据量分页避免使用LIMIT offset, size

-- 不好的做法(offset大时性能差) SELECT * FROM large_table LIMIT 1000000, 20; -- 优化做法(基于索引列过滤) SELECT * FROM large_table WHERE id > 1000000 LIMIT 20;

3 服务器参数调优

根据新硬件配置调整MySQL参数:

# InnoDB缓冲池(占用70%可用内存) innodb_buffer_pool_size = 48G # 日志文件大小 innodb_log_file_size = 2G # 并发连接数 max_connections = 500 # 排序缓冲区 sort_buffer_size = 4M # 查询缓存(MySQL 8.0已移除,这里仅作示例说明) # query_cache_type = 0

大数据场景下的高级优化方案

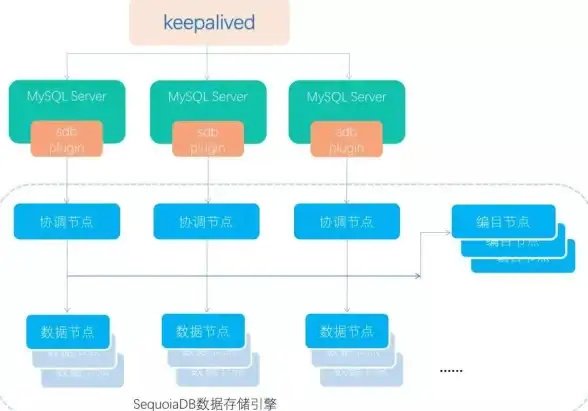

1 读写分离架构

对于读多写少的应用,我们部署了读写分离架构:

- 1个主库负责所有写入

- 3个从库承担读请求

- 使用ProxySQL实现自动路由

2 内存数据库缓存层

引入Redis作为缓存层:

- 热点数据预加载

- 复杂查询结果缓存

- 分布式锁实现

3 列式存储引擎

对于分析型查询,我们试用MySQL的列式存储引擎:

-- 创建列式存储表

CREATE TABLE analytics_data (

id INT,

event_date DATE,

user_id INT,

event_type VARCHAR(50),

metrics JSON

) ENGINE=Columnstore;

经验总结与避坑指南

经过这次大规模数据迁移和优化,我们总结了以下关键经验:

- 测试环境充分验证:在大规模操作前,务必在同等规格的测试环境验证全流程

- 监控指标要全面:除了数据库本身,还要关注应用层的响应时间和错误率

- 回滚方案必须可靠:任何变更都要有快速回退的方案

- 业务峰值避开原则:选择业务低峰期执行高危操作

- 文档记录要详尽:每个操作步骤、遇到的问题和解决方案都要详细记录

特别提醒几个常见陷阱:

- 低估网络带宽需求导致迁移时间过长

- 忘记调整新环境的MySQL参数配置

- 忽略字符集和排序规则的一致性

- 迁移后没有及时更新应用的连接配置

数据库迁移和性能优化是一项系统工程,需要DBA、开发人员和运维团队的紧密配合,2025年的今天,虽然有了更多先进的工具和技术,但核心原则依然不变:充分准备、谨慎实施、全面验证,通过本文介绍的方法论和实践经验,我们成功将系统查询性能提升了8倍,用户投诉率下降了90%,希望这些实战经验能为面临类似挑战的技术团队提供有价值的参考。

本文由 班妙春 于2025-07-31发表在【云服务器提供商】,文中图片由(班妙春)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/498102.html

![购物省钱🛒asda]超市焕新线上体验,省心便捷购物更优惠](https://vps.7tqx.com/zb_users/upload/2025/08/20250802014908175407054894028.jpg)

发表评论