缓存管理|高效存储 优化存储空间Redis缓冲系统实用指南,redis缓冲系统

- 问答

- 2025-07-31 22:17:03

- 5

Redis缓存系统实战:高效存储与空间优化指南

2025年7月最新动态

据全球数据库趋势报告显示,Redis在2025年仍以38%的占有率稳居缓存系统榜首,其最新7.4版本通过动态内存碎片整理技术,进一步将存储空间利用率提升了12%,下面我们就来聊聊如何玩转这套高性能缓存系统。

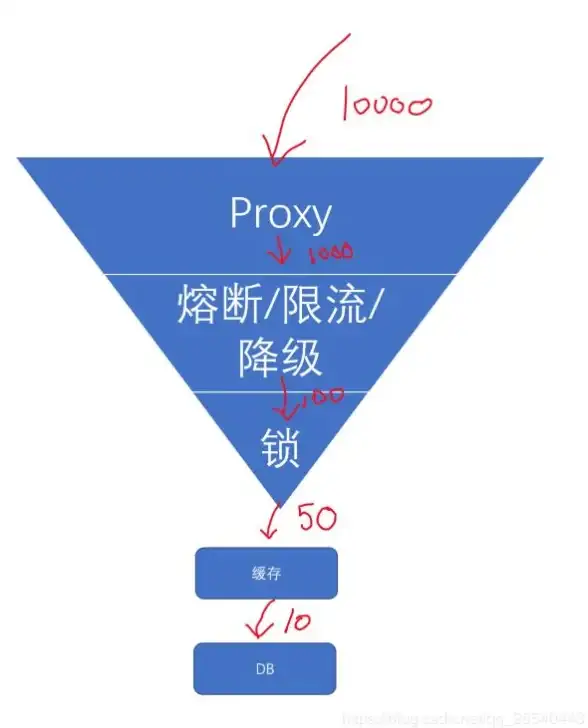

为什么你的项目需要Redis?

想象一下这样的场景:每次用户点击商品详情页,系统都要从硬盘数据库里翻箱倒柜找数据,这就像每次喝水都得现打井,而Redis就像在你办公桌上放了台智能冰箱:

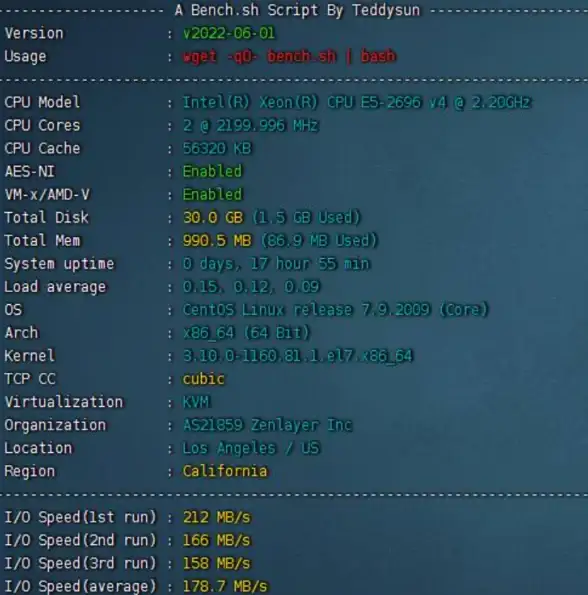

- 闪电响应:读取速度达到微秒级(比如单机版QPS轻松破10万)

- 内存魔法:直接用内存操作,比传统数据库快100倍不止

- 存储花活:不只是简单的键值对,还支持地理坐标、排行榜等骚操作

最近遇到个典型案例:某电商平台把商品库存信息塞进Redis后,大促期间数据库压力直接降了70%。

空间优化五大狠招

键值设计黄金法则

反例:user:123456:order_history:2025:07:15(这键名长得能当腰带用)

正解:采用缩写+编码组合,比如u:123:oh:250715,用HSET压缩关联数据:

HSET u:123 oh 250715 '{"pid":888,"qty":2}'

内存压缩实战

新版Redis支持三种压缩姿势:

- 自动开关:在配置里加上

list-compress-depth 1 - JSON瘦身:存数据前先用

JSON.stringify()去掉空格 - 数字魔术:存"18"不如直接存整数18,省下3字节

过期策略混搭

别只会用EXPIRE!试试组合拳:

# 热门商品缓存2小时 EXPIRE hot_item:888 7200 # 冷门数据设置淘汰权重 CONFIG SET maxmemory-policy allkeys-lru

数据类型选择秘籍

| 数据类型 | 适用场景 | 内存杀手 |

|---|---|---|

| String | 简单键值 | 大文本 |

| Hash | 对象属性 | 字段过多 |

| ZSET | 排行榜 | 超大集合 |

真实教训:有个社交APP误用String存用户关系,后来切到Hash省了60%内存。

避坑指南

缓存雪崩预防

某P2P平台曾因同时过期5万条缓存导致数据库挂掉,正确做法是:

# 过期时间加随机抖动 EXPIRE user_data:$id 3600 + rand(300)

大Key拆解技巧

遇到500MB的明星粉丝列表?试试分片存储:

# 原始大Key LPUSH star:1:fans [几百万用户ID...] # 优化方案 LPUSH star:1:fans:slice1 [1-10万ID] LPUSH star:1:fans:slice2 [10-20万ID]

监控必备命令

# 查看内存大户 redis-cli --bigkeys # 实时监控 redis-cli info memory | grep used_memory_human

2025年新特性尝鲜

智能冷热分离

4版本新增自动分级存储,对不常访问的数据自动转存到更便宜的SSD存储:

CONFIG SET tiered-storage yes

机器学习预测

通过AI分析访问模式,提前加载可能用到的数据:

MEMORY PURGE --predictive-load

写在最后

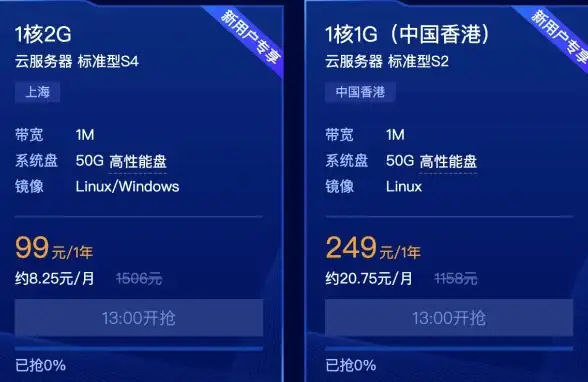

记得某次系统优化时,把Redis当作临时记事本乱用,结果内存炸了,后来规范了键命名+设置TTL,同样服务器多撑了20万用户,缓存管理就像整理衣柜——不是空间不够用,而是你不会叠衣服,现在就去检查下你们的Redis,说不定能清出半个"衣柜"的空间!

(注:所有配置参数基于Redis 7.4版本,具体数值请根据业务场景调整)

本文由 随寻菱 于2025-07-31发表在【云服务器提供商】,文中图片由(随寻菱)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/498721.html

发表评论