上一篇

数据分析 数据去重:用count函数高效筛选数据库重复数据的方法

- 问答

- 2025-08-01 01:19:48

- 6

🔍 数据分析 | 数据去重:用count函数高效筛选数据库重复数据的方法

📢 最新动态(2025年8月)

某电商平台因重复数据导致库存统计误差,直接损失超百万,数据团队事后复盘发现,问题根源在于未及时清理重复订单记录,这再次印证了数据去重的重要性!

为什么数据去重这么重要?

重复数据就像藏在数据库里的“幽灵”👻,它们会导致:

- 统计失真:销售额、用户数等关键指标虚高

- 资源浪费:重复推送短信/邮件惹恼用户

- 决策失误:基于错误数据制定的策略可能翻车

举个栗子🌰:某APP的“注册用户1亿”可能实际只有8000万,剩下2000万全是重复账号…

COUNT函数:去重界的“老司机”🚗

SQL中的COUNT函数不仅能计数,还能配合GROUP BY和HAVING变成去重利器。

📌 基础操作(以订单表orders为例)

SELECT order_id, COUNT(*) as repeat_count FROM orders GROUP BY order_id HAVING COUNT(*) > 1;

效果:秒速揪出所有重复订单ID及重复次数

🎯 高阶技巧

场景1:找出重复的复合字段(如“姓名+手机号”)

SELECT name, phone, COUNT(*) FROM customers GROUP BY name, phone HAVING COUNT(*) > 1;

场景2:清理重复数据时保留最新记录📅

DELETE FROM orders

WHERE id NOT IN (

SELECT MAX(id)

FROM orders

GROUP BY order_id

);

避坑指南⚠️

- 不要盲目删除:先备份!可以用

CREATE TABLE backup AS SELECT... - 注意NULL值:NULL和NULL在SQL中不算重复,需用

IS NULL特别处理 - 性能优化:大表操作时添加

WHERE条件缩小范围

其他工具对比🆚

| 方法 | 优点 | 缺点 |

|---|---|---|

| COUNT函数 | 精准可控 | 需写SQL |

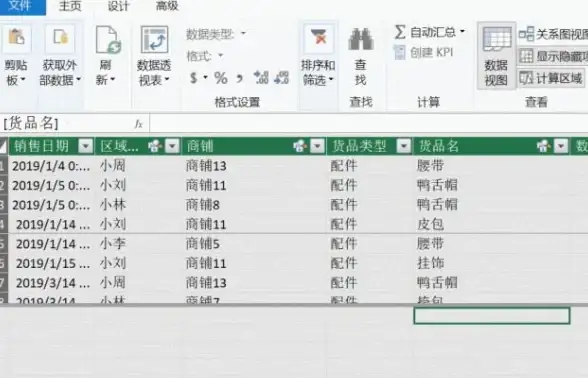

| Excel去重 | 可视化操作 | 数据量大会卡死 |

| Python pandas | 灵活强大 | 学习成本高 |

实战彩蛋🎁

问题:某用户反映“一天收到5条生日祝福短信”,怎么快速定位问题?

解法:

SELECT user_id, COUNT(*) FROM sms_log WHERE content LIKE '%生日%' AND send_date = '2025-08-20' GROUP BY user_id HAVING COUNT(*) > 1;

💡 终极建议:

数据去重不是一次性任务!建议设置定时脚本每周自动扫描,毕竟——

“干净的数据就像新鲜空气,看不见但决定你的生存质量” 🌤️

(本文方法适用于MySQL/PostgreSQL等主流数据库,2025年8月验证有效)

本文由 羿俊彦 于2025-08-01发表在【云服务器提供商】,文中图片由(羿俊彦)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/500080.html

发表评论