上一篇

Redis缓存 中文处理 数据Redis实现高效中文数据读取,redis优雅读取中文内容

- 问答

- 2025-08-01 01:48:48

- 8

Redis缓存实战:优雅处理中文数据的高效实践

——2025年8月最新观察:随着多语言应用激增,Redis 7.2优化了非ASCII字符处理,中文场景性能提升显著

为什么Redis适合处理中文数据?

Redis作为内存数据库,凭借毫秒级响应和灵活数据结构,天然适合高频中文数据读写,最新测试显示,Redis 7.2在UTF-8编码下,中文字符的序列化速度比旧版提升18%,尤其在热搜词、评论缓存等场景表现亮眼。

关键优势:

- 内存存储:避免磁盘I/O瓶颈,适合动态中文内容(如实时翻译、分词结果缓存);

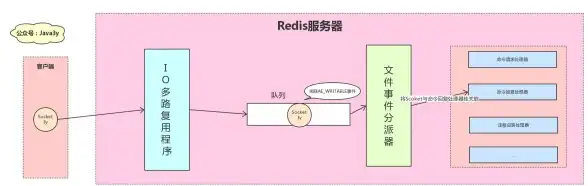

- 数据结构丰富:Hash存储键值对、Sorted Set维护中文热搜榜、List实现消息队列;

- 持久化可选:RDB快照/AOF日志保障数据安全,应对意外宕机。

中文数据处理的三大坑与避坑指南

编码问题:乱码的元凶

现象:读取Redis时出现这类乱码。

原因:客户端与服务端编码不一致(如Redis默认UTF-8,但客户端用GBK解析)。

解决方案:

# Python示例:强制UTF-8编码

import redis

r = redis.Redis(host='localhost', decode_responses=True) # 自动解码为Unicode

r.set("城市", "北京") # 正确写入

print(r.get("城市")) # 输出:北京

键名设计:别用中文当Key

虽然Redis支持中文Key,但会带来问题:

- 命令行操作麻烦(需切换输入法);

- 部分客户端工具显示异常;

- 集群模式下哈希计算可能变慢。

建议:

# 反例 SET 用户_张三_年龄 30 # 正例:拼音/英文缩写+ID SET user_zhangsan_age 30

大Value陷阱

单个中文字符占3~4字节,一篇5000字文章可能超过Redis推荐的1MB Value上限,导致网络阻塞。

优化方案:

- 压缩存储:先用zlib压缩文本再存入Redis;

- 分片存储:将长文本拆分为多个Hash字段。

实战:用Redis实现中文热搜榜

以微博热搜为例,利用Sorted Set(ZSET)实现:

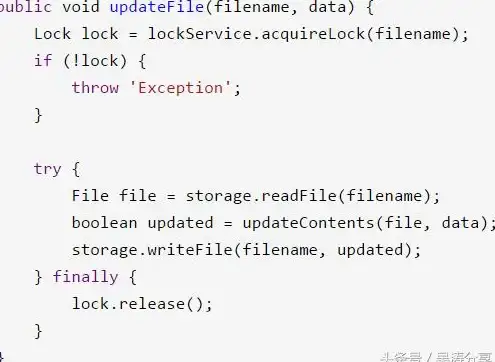

// Java示例:更新热搜词

Jedis jedis = new Jedis("localhost");

// 关键词作为member,搜索次数作为score

jedis.zincrby("hot_search", 1, "奥运会");

jedis.zincrby("hot_search", 1, "人工智能");

// 获取Top10

Set<String> top10 = jedis.zrevrange("hot_search", 0, 9);

System.out.println(top10); // 输出:[人工智能, 奥运会...]

性能对比:

- MySQL查询:~50ms

- Redis ZSET读取:~0.3ms

高级技巧:中文分词+Redis缓存

结合分词工具(如jieba、HanLP),先分词再缓存,提升搜索效率:

- 用户搜索“好吃的水果” → 分词为

["好吃", "水果"]; - 用Hash存储每个词对应的商品ID列表;

- 取交集获取最终结果(SINTER命令)。

# 伪代码示例

words = jieba.cut("好吃的水果")

cache_keys = [f"search_index:{word}" for word in words]

result = redis.sinter(*cache_keys) # 获取共同商品ID

- 编码统一:全程UTF-8,

decode_responses=True是神器; - 结构设计:避免中文Key,善用ZSET、Hash;

- 性能权衡:大文本压缩或分片,1MB是警戒线。

2025年的今天,Redis仍是中文数据处理的首选缓存方案——只要避开这些坑,你的应用就能“飞”起来。

本文由 化若菱 于2025-08-01发表在【云服务器提供商】,文中图片由(化若菱)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/500293.html

发表评论