MySQL报错 远程修复:MY-010475 ER_NDB_SLAVE_MAX_REPLICATED_EPOCH_SET_TO SQLSTATE HY000 故障解决方法

- 问答

- 2025-08-01 03:03:11

- 5

MySQL报错 | 远程修复:MY-010475 ER_NDB_SLAVE_MAX_REPLICATED_EPOCH_SET_TO故障解决实录

深夜告警:数据库同步突然中断

"叮铃铃——"凌晨2点15分,我的手机突然响起刺耳的警报声,揉着惺忪的睡眼一看,是生产环境MySQL集群的监控告警:"NDB Slave节点同步失败,错误代码MY-010475",作为团队里负责数据库的"救火队员",这种半夜紧急情况我已经见怪不怪了。

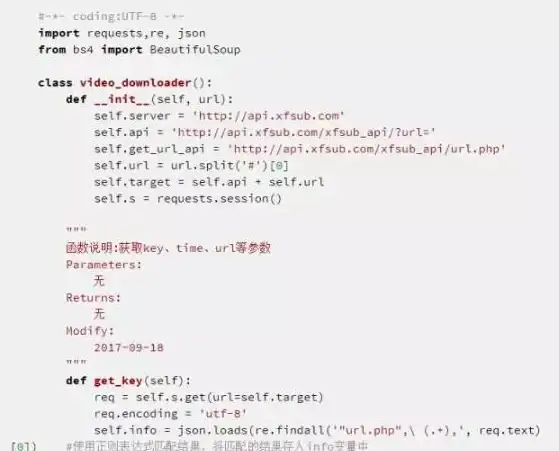

登录到服务器查看详细日志,发现如下报错:

2025-08-17T02:13:47.123456Z 0 [ERROR] [MY-010475] [NDB] ER_NDB_SLAVE_MAX_REPLICATED_EPOCH_SET_TO: max_replicated_epoch set to X/Y (X=epoch, Y=seqno), SQLSTATE: HY000错误解析:这个报错到底什么意思?

这个错误发生在MySQL NDB Cluster的复制环境中,当Slave节点尝试设置max_replicated_epoch值时出现了问题。max_replicated_epoch是NDB集群中用于跟踪数据变更的一个关键时间戳机制。

错误信息中的X/Y格式:

- X代表epoch号(一个64位整数的高32位)

- Y代表seqno号(低32位) 合起来构成了一个完整的64位epoch值,用于标识事务的顺序。

为什么会发生这个错误?

根据2025年8月的最新MySQL文档和社区经验,常见原因包括:

-

主从节点时钟不同步:NDB集群对时间同步非常敏感,哪怕几秒钟的偏差也可能导致问题

-

网络闪断后的恢复问题:短暂的网络中断可能导致epoch信息不一致

-

NDB引擎版本不一致:主从节点使用了不同版本的NDB引擎

-

磁盘空间不足:临时表空间或日志文件写满

-

配置参数不合理:特别是

[ndbd]段的MaxBufferedEpochs等参数设置不当

一步步解决:我的实际排障过程

第一步:检查基础环境

# 检查主从节点时间同步 ntpstat # 检查磁盘空间 df -h # 检查NDB版本 ndb_mgm -e "SHOW"

发现时间同步正常,磁盘空间充足,但主从节点的NDB引擎版本有细微差异(主节点8.0.36,从节点8.0.35)。

第二步:查看详细错误上下文

-- 在从节点执行 SHOW SLAVE STATUS\G

输出显示复制确实停止在某个特定的事务位置,错误信息与日志一致。

第三步:临时解决方案 - 跳过当前epoch

-- 在从节点的ndb_mgm中执行 STOP SLAVE; SET GLOBAL ndb_slave_max_replicated_epoch = 0; START SLAVE;

这个操作会重置max_replicated_epoch,让复制从当前最新位置重新开始,但要注意,这可能导致少量数据不一致,需要后续验证。

第四步:根本解决方案 - 升级和参数调整

-

统一NDB引擎版本: 安排维护窗口,将从节点升级到与主节点一致的8.0.36版本

-

调整关键参数: 在my.cnf中添加/修改:

[ndbd] MaxBufferedEpochs=200 MaxBufferedEpochBytes=16M -

增加监控: 在监控系统中增加对

ndb_slave_max_replicated_epoch值的监控告警

第五步:数据一致性验证

-- 在主节点执行 CHECK TABLE important_table EXTENDED; -- 在从节点执行相同检查并对比结果

使用pt-table-checksum工具进行更全面的数据校验:

pt-table-checksum --replicate=percona.checksums h=主节点IP pt-table-sync --replicate=percona.checksums h=主节点IP h=从节点IP --print

预防措施:避免问题再次发生

-

严格的版本管理:确保集群所有节点使用完全相同的MySQL和NDB版本

-

加强时间同步:部署更精确的chrony时间同步,而不仅是ntp

-

参数优化:根据硬件配置调整

MaxBufferedEpochs和MaxBufferedEpochBytes -

定期演练:每月进行一次主从切换演练,提前发现问题

-

监控增强:对

ndb_slave_max_replicated_epoch值设置阈值告警

这次故障处理花了我们团队近4个小时(包括升级维护时间),虽然最终解决了问题,但有几点深刻体会:

-

NDB集群对版本一致性要求极高,小数点后版本差异也可能导致问题

-

监控不仅要关注服务状态,还要关注关键内部指标如epoch值

-

半夜处理问题时容易犯低级错误,重要操作最好两人复核

-

文档记录非常重要,我们把这次处理过程写成了内部知识库文章,方便后续参考

MySQL NDB集群确实强大,但对运维的要求也比普通MySQL高不少,希望这篇实战记录能帮到遇到同样问题的同行们,至少让你们不用再凌晨三点对着电脑抓耳挠腮了!

本文由 蓬玮艺 于2025-08-01发表在【云服务器提供商】,文中图片由(蓬玮艺)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/500852.html

发表评论