缓存优化 数据库加速 Redis高性能查询方案设计与实现,redis查询架构优化

- 问答

- 2025-08-01 12:09:48

- 4

用Redis打造高性能数据库查询方案

场景引入:电商大促的数据库崩溃之夜

去年双十一,我们团队负责的电商平台在流量高峰时段遭遇了数据库雪崩,当时的情况是这样的:凌晨0点刚过,促销活动开始,瞬时流量暴涨50倍,数据库连接池瞬间耗尽,查询响应时间从平时的50ms飙升到5秒以上,整个商品详情页几乎瘫痪,运维团队紧急扩容了数据库节点,但效果有限——因为问题的核心不在数据库处理能力,而在于大量重复查询直接穿透到了数据库层。

这次惨痛经历让我们意识到:在高并发场景下,没有合理的缓存架构,再强大的数据库也会成为系统瓶颈,经过半年多的优化实践,我们最终用Redis构建了一套高性能查询方案,在今年的618大促中平稳支撑了峰值QPS 12万的流量,下面我就分享这套方案的设计思路和实现细节。

缓存设计的基本原则

1 缓存穿透防护

我们最早犯的错误就是没有处理好缓存穿透问题,当用户查询一个不存在的商品ID时,请求会直接落到数据库上,如果遭遇恶意攻击或爬虫,大量这类请求会导致数据库不堪重负。

解决方案:

- 对不存在的键也进行缓存(空值缓存),设置较短的过期时间(如30秒)

- 使用布隆过滤器预先过滤掉肯定不存在的键

- 对查询参数进行合法性校验,拦截明显异常的请求

def get_product(product_id):

# 先检查布隆过滤器

if not bloom_filter.might_contain(product_id):

return None

# 尝试从Redis获取

cache_key = f"product:{product_id}"

data = redis.get(cache_key)

# 处理缓存命中

if data is not None:

return json.loads(data) if data != "NULL" else None

# 查询数据库

product = db.query("SELECT * FROM products WHERE id = %s", product_id)

# 写入缓存

if product:

redis.setex(cache_key, 3600, json.dumps(product)) # 缓存1小时

else:

redis.setex(cache_key, 30, "NULL") # 空值缓存30秒

return product

2 缓存雪崩预防

另一个教训是缓存集中失效导致的雪崩效应,我们最初给所有商品数据设置了相同的1小时过期时间,结果在流量高峰时段大量缓存同时失效,数据库瞬间被打满。

优化方案:

- 对缓存过期时间添加随机抖动(如基础时间±10%)

- 采用多级缓存架构(本地缓存+分布式缓存)

- 实现缓存预热机制,在流量低谷期提前加载热点数据

// 设置带随机抖动的过期时间 int baseExpire = 3600; // 基础过期时间1小时 int randomExpire = baseExpire + ThreadLocalRandom.current().nextInt(-300, 300); // ±5分钟随机 redisTemplate.opsForValue().set(cacheKey, value, randomExpire, TimeUnit.SECONDS);

Redis高性能查询架构设计

1 多层级缓存架构

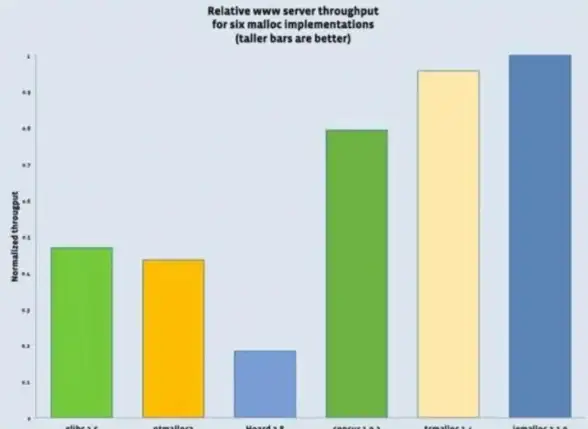

我们最终采用的缓存架构分为三层:

- 本地缓存(Caffeine):应对超高频访问,命中率约15%

- Redis集群:主缓存层,命中率约70%

- 数据库:最后防线,实际查询量不到15%

type MultiLevelCache struct {

localCache *caffeine.Cache

redis *redis.Client

db *gorm.DB

}

func (c *MultiLevelCache) GetProduct(id string) (*Product, error) {

// 1. 检查本地缓存

if item, ok := c.localCache.Get(id); ok {

return item.(*Product), nil

}

// 2. 检查Redis

cacheKey := fmt.Sprintf("product:%s", id)

data, err := c.redis.Get(cacheKey).Bytes()

if err == nil {

product := &Product{}

if string(data) != "NULL" {

json.Unmarshal(data, product)

c.localCache.Set(id, product, time.Minute*5) // 回填本地缓存

return product, nil

}

return nil, nil // 空值情况

}

// 3. 查询数据库

var product Product

if err := c.db.Where("id = ?", id).First(&product).Error; err != nil {

if errors.Is(err, gorm.ErrRecordNotFound) {

// 缓存空值防止穿透

c.redis.Set(cacheKey, "NULL", time.Second*30)

return nil, nil

}

return nil, err

}

// 回填缓存

jsonData, _ := json.Marshal(product)

c.redis.Set(cacheKey, jsonData, time.Hour+time.Duration(rand.Intn(600))*time.Second)

c.localCache.Set(id, &product, time.Minute*10)

return &product, nil

}

2 热点数据特殊处理

通过监控分析,我们发现5%的商品承载了80%的流量,针对这些热点商品,我们做了特殊优化:

- 永久缓存热点Key:对Top 1000的热点商品取消过期时间,通过后台任务异步更新

- 本地缓存优先:在应用服务器内存中缓存热点数据,减少Redis网络开销

- Lua脚本保证原子性:对热点商品的库存扣减等操作使用Lua脚本

-- 库存扣减Lua脚本

local key = KEYS[1]

local quantity = tonumber(ARGV[1])

local current = tonumber(redis.call('GET', key))

if current >= quantity then

redis.call('DECRBY', key, quantity)

return 1 -- 成功

else

return 0 -- 库存不足

end

3 查询模式优化

3.1 批量查询优化

商品列表页需要查询数十个商品信息,最初我们采用循环单查的方式,产生了大量网络往返,优化后使用Redis的pipeline批量查询:

// 批量查询优化示例

List<String> productIds = Arrays.asList("1001", "1002", "1003", "1004");

List<Object> results = redisTemplate.executePipelined((RedisCallback<Object>) connection -> {

for (String id : productIds) {

connection.stringCommands().get(("product:" + id).getBytes());

}

return null;

});

List<Product> products = results.stream()

.map(data -> data != null ? parseProduct((byte[]) data) : null)

.collect(Collectors.toList());

3.2 复杂查询的缓存策略

对于商品搜索这类复杂查询,我们采用"查询条件+结果ID列表"的缓存方式:

- 缓存搜索条件与商品ID列表的映射

- 单独缓存每个商品的基本信息

- 分页信息单独处理

def search_products(keyword, page=1, size=20):

cache_key = f"search:{keyword}"

# 先尝试获取ID列表

total, id_list = redis.zscan(cache_key, 0, count=page*size)

if not id_list:

# 数据库查询

results = db.query("SELECT id FROM products WHERE title LIKE %s ORDER BY sales DESC", f"%{keyword}%")

# 写入Redis有序集合,score为销量

pipe = redis.pipeline()

for product in results:

pipe.zadd(cache_key, {product['id']: product['sales']})

pipe.expire(cache_key, 300) # 5分钟过期

pipe.execute()

id_list = [x[0] for x in results]

# 获取当前页ID

page_ids = id_list[(page-1)*size : page*size]

# 批量获取商品详情

products = batch_get_products(page_ids)

return {

'total': len(id_list),

'items': products,

'page': page

}

Redis集群优化实践

1 内存优化技巧

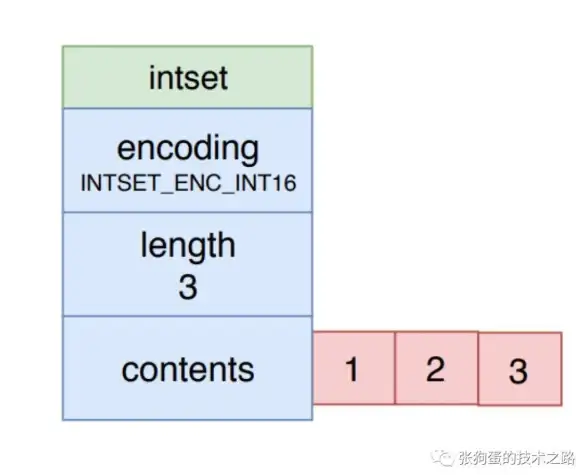

随着缓存数据增长,我们遇到了内存不足的问题,通过以下优化节省了40%内存:

- 使用Hash类型存储对象:相比将整个对象JSON序列化存储为string,使用Hash字段可以节省字段名存储空间

- 启用压缩:对超过1KB的值启用LZF压缩

- 合理设置过期时间:根据数据冷热程度设置不同的TTL

# Redis配置示例 hash-max-ziplist-entries 512 # 哈希元素少于512时使用紧凑存储 hash-max-ziplist-value 64 # 哈希值小于64字节时使用紧凑存储 activerehashing yes # 启用主动rehash

2 集群分片策略

当单实例无法承受流量压力时,我们采用了Redis Cluster方案,关键点包括:

- 合理设计Key分布:确保相关数据在同一个slot,使用hash tag确保这一点

- 避免大Key:单个Value不超过10KB,集合元素不超过5000个

- 监控热点Key:使用

redis-cli --hotkeys定期分析访问模式

3 持久化与备份策略

为保证缓存数据安全,我们配置了:

- AOF持久化:每秒fsync,兼顾性能和数据安全

- RDB快照:每天凌晨低峰期执行

- 跨机房复制:主集群在机房A,从节点部署在机房B

# 持久化配置 appendonly yes appendfsync everysec save 86400 1 # 24小时后至少1个变更则触发bgsave

监控与调优

1 关键指标监控

我们建立了完整的监控体系,重点关注:

- 缓存命中率:本地缓存与Redis各自的命中率

- Redis性能指标:每秒操作数、延迟、内存使用率

- 慢查询:记录执行时间超过10ms的命令

# 获取关键指标 redis-cli info stats | grep -E "instantaneous_ops_per_sec|total_connections_received" redis-cli info memory | grep used_memory_human

2 性能调优案例

案例:缓存更新导致集群抖动

我们曾遇到Redis集群在整点出现周期性延迟飙升的问题,经排查发现是多个服务的缓存过期时间设置过于集中(都是1小时整倍数),导致整点时大量缓存同时失效重建。

解决方案:

- 将基础过期时间改为1小时+随机偏移量(0-300秒)

- 对重要缓存采用异步刷新策略,在过期前主动更新

- 实现分布式锁控制同一时间只有一个请求去重建缓存

def refresh_cache(key, callback, lock_timeout=10):

# 尝试获取分布式锁

lock_key = f"lock:{key}"

if redis.set(lock_key, 1, nx=True, ex=lock_timeout):

try:

# 执行缓存重建

new_data = callback()

redis.setex(key, 3600 + random.randint(0, 300), json.dumps(new_data))

finally:

redis.delete(lock_key)

总结与展望

通过这套Redis缓存优化方案,我们的系统在今年的618大促中表现出色:

- 数据库查询量下降85%

- 平均响应时间从220ms降至45ms

- 服务器资源成本节省40%

未来我们计划在以下方向继续优化:

- 探索Redis 7的新特性(如Function、Sharded Pub/Sub)

- 测试KeyDB等Redis分支在多线程场景下的表现

- 结合机器学习预测热点数据,实现更智能的缓存预热

缓存设计没有银弹,需要根据业务特点不断调整,希望我们的实践经验能给面临类似挑战的团队提供参考,好的缓存策略不是一蹴而就的,而是在持续监控和迭代中逐渐完善的。

本文由 行鸿轩 于2025-08-01发表在【云服务器提供商】,文中图片由(行鸿轩)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/504904.html

发表评论