上一篇

爬虫技术|数据抓取 获取指定网址内容php-实现PHP获取指定网址内容的多种方法

- 问答

- 2025-08-01 12:58:42

- 4

🕷️ 爬虫技术 | 用PHP抓取网页内容的N种姿势

场景再现:

凌晨3点,你盯着电脑屏幕抓耳挠腮——老板要竞品网站的价格数据,手动复制?别开玩笑了!😱 这时候,PHP爬虫就是你的赛博救星!今天我们就用最接地气的方式,聊聊怎么用PHP把网页内容"薅"下来。

🔧 方法一:file_get_contents(懒人首选)

$url = "https://example.com";

$html = file_get_contents($url);

if($html === false){

echo "抓取失败,可能对方网站防爬虫哦~";

} else {

echo $html; // 简单到怀疑人生

}

适用场景:快速抓取公开API或简单页面

缺点:遇到需要登录/验证的网站直接扑街

🚀 方法二:cURL(全能战士)

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, "https://example.com");

curl_setopt($ch, CURLOPT_RETURNTRANSFER, true);

// 伪装成浏览器访问

curl_setopt($ch, CURLOPT_USERAGENT, 'Mozilla/5.0 (Windows NT 10.0) AppleWebKit/537.36');

$result = curl_exec($ch);

curl_close($ch);

// 处理抓取结果

if($result === false){

echo "cURL错误:" . curl_error($ch);

} else {

// 正则匹配标题示例

preg_match('/<title>(.*?)<\/title>/', $result, $matches);

echo "网页标题:" . ($matches[1] ?? '未找到');

}

必杀技:

- 设置

CURLOPT_FOLLOWLOCATION自动跳转 - 用

CURLOPT_COOKIE处理登录状态 - 通过

CURLOPT_PROXY设置代理IP

🤖 方法三:DOMDocument(精准打击)

当需要精确提取某个

时:

$dom = new DOMDocument();

@$dom->loadHTML(file_get_contents("https://example.com"));

$xpath = new DOMXPath($dom);

// 获取所有<h2>标签

$h2List = $xpath->query("//h2");

foreach ($h2List as $h2) {

echo "发现小标题:" . $h2->nodeValue . "\n";

}

优势:像手术刀一样精准解析HTML结构

注意:记得用抑制警告,网页不规范的HTML会报错

🕵️♂️ 方法四:Guzzle HTTP(现代流派)

通过Composer安装后:

require 'vendor/autoload.php';

use GuzzleHttp\Client;

$client = new Client();

$response = $client->request('GET', 'https://example.com', [

'headers' => [

'Accept' => 'text/html,application/xhtml+xml'

]

]);

echo "状态码:" . $response->getStatusCode();

echo "网页内容:" . $response->getBody();

亮点:

- 支持异步请求

- 内置Cookie管理

- 自动处理编码

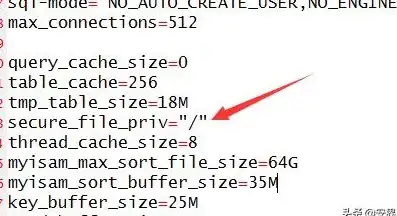

🛡️ 防翻车指南

- 设置超时:

curl_setopt($ch, CURLOPT_TIMEOUT, 10) - 伪装Header:务必添加User-Agent

- 频率控制:用

sleep(rand(1,3))模拟人工操作 - 错误处理:记录失败日志方便重试

🌟 2025年爬虫新趋势

- AI识别:部分网站开始用机器学习检测爬虫行为

- 动态渲染:越来越多内容通过JS加载(这时候需要无头浏览器)

- 法律风险:欧盟《数字市场法案》要求公开数据接口

💡 小贴士:抓取前务必检查robots.txt,商业用途最好咨询法律顾问!

下次遇到需要批量抓数据时,不妨试试这些方法——但记得悠着点,别把人家服务器搞崩了哦~ 🚨

本文由 任佳文 于2025-08-01发表在【云服务器提供商】,文中图片由(任佳文)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/505274.html

发表评论