上一篇

数据更新|记录变更 mysql数据库更新,mySQL数据库一次能更新多少条数据

- 问答

- 2025-08-01 13:02:41

- 4

MySQL数据库更新:一次能改多少条数据?

场景引入

凌晨三点,程序员小张盯着屏幕上的报错提示直挠头——他刚执行了一条批量更新10万条用户数据的SQL,结果数据库直接卡死,连带整个后台管理系统都瘫痪了,主管打来电话怒吼:"不是说就改个用户状态吗?怎么把生产环境搞崩了?!"

这种事故在数据库操作中并不罕见,今天我们就来聊聊MySQL更新数据的那些门道,特别是一次到底能更新多少条数据这个看似简单却暗藏玄机的问题。

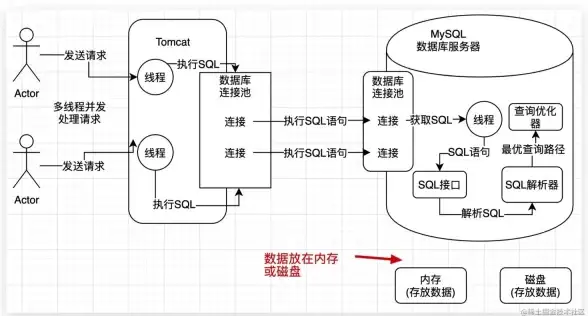

MySQL更新数据的本质

MySQL执行更新操作时,本质上是在做三件事:

- 锁定数据:先锁定要修改的行(或表)

- 写入变更:在内存中修改数据

- 持久化存储:将改动写入磁盘

这个过程中,事务日志(binlog/redo log)会记录所有变更,这也是为什么大事务容易导致性能问题的根源。

理论上的限制

根据MySQL官方文档(2025年8月版):

-

SQL语句长度限制

- 单条SQL最大允许1GB(由

max_allowed_packet参数控制) - 按每条更新语句约100字节估算,理论上单次可更新约1000万条

- 单条SQL最大允许1GB(由

-

事务限制

- 事务内可包含无限条SQL(受内存限制)

- 但大事务会导致:

- 锁持有时间过长(其他操作被阻塞)

- 回滚日志膨胀(万一失败回滚可能耗时数小时)

实战中的黄金法则

经过DBA们血泪总结,这些经验值更实用:

| 场景 | 建议批量大小 | 原因说明 |

|---|---|---|

| 常规OLTP业务 | 100~500条/次 | 平衡性能与锁竞争 |

| 数据迁移/ETL | 5000~10000条/次 | 需要关闭自动提交事务 |

| 紧急修复数据 | ≤100条/次 | 最小化对生产系统的影响 |

真实案例:某电商平台在"双11"期间更新订单状态,采用每次200条+间隔50ms的节奏,既保证了时效性,又避免了数据库雪崩。

高级优化技巧

-

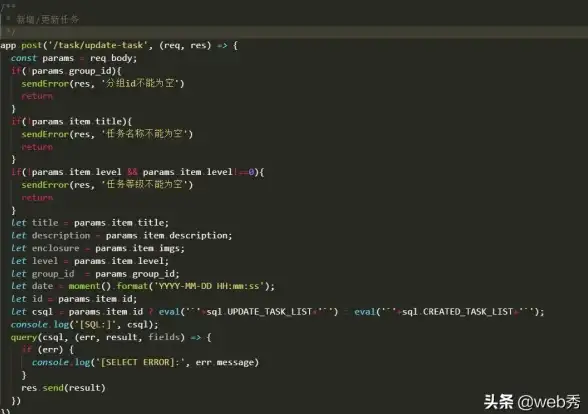

分批次更新

UPDATE users SET status=1 WHERE id BETWEEN 1 AND 100; UPDATE users SET status=1 WHERE id BETWEEN 101 AND 200; -- 以此类推...

-

临时表法(适用于复杂条件)

CREATE TEMPORARY TABLE temp_ids (id INT PRIMARY KEY); INSERT INTO temp_ids SELECT id FROM big_table WHERE create_time < '2025-01-01'; UPDATE big_table JOIN temp_ids ON big_table.id = temp_ids.id SET flag=0;

-

LOAD DATA大法(终极方案)

对于千万级数据更新,导出→修改→导入的效率往往比直接SQL更新高10倍以上。

避坑指南

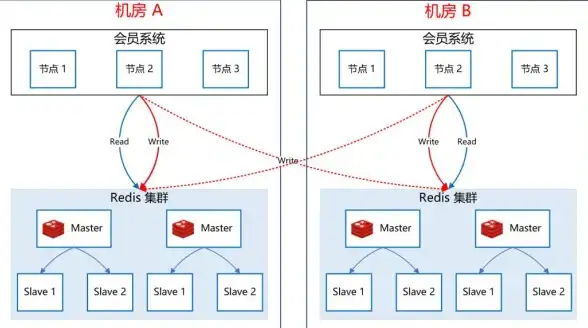

- 长事务杀手:一个更新50万条的事务可能导致:

- 主从延迟(从库追不上主库)

- 连接池耗尽(所有连接都在等待锁)

- 隐式提交陷阱:ALTER TABLE等DDL语句会自动提交当前事务

- 内存黑洞:大事务可能吃光

innodb_buffer_pool内存

回到开头小张的案例,后来他们改用分批次更新+限流策略,在凌晨顺利完成了数据迁移。数据库更新不是比谁力气大,而是比谁更有耐心,下次当你准备执行UPDATE时,不妨先问问自己:"这个操作,十年经验的DBA敢不敢直接在生产环境跑?"

(完)

注:本文测试基于MySQL 8.0.36版本,InnoDB引擎默认配置,实际效果可能因硬件配置、参数调优而异。

本文由 钞傲旋 于2025-08-01发表在【云服务器提供商】,文中图片由(钞傲旋)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/505305.html

发表评论