性能提升|系统加速 GP数据库优化技巧,助力系统高效流畅运行

- 问答

- 2025-08-01 14:15:21

- 3

性能提升 | 系统加速 | GP数据库优化技巧,助力系统高效流畅运行

最新动态

2025年8月,Greenplum数据库(GP)发布了6.25版本,进一步优化了并行查询执行引擎,使得大规模数据分析任务的响应速度平均提升30%,新版本改进了内存管理机制,降低了高并发场景下的资源争用问题,让企业级数据仓库运行更加稳定高效。

为什么你的系统越来越慢?

你是不是经常遇到这样的情况:查询数据越来越慢,报表生成时间越来越长,甚至系统时不时卡死?别急,这不一定是硬件的问题,很可能是你的GP数据库需要优化了。

数据库就像一辆车,刚买来时跑得飞快,但如果不定期保养,性能就会逐渐下降,我们就来聊聊如何通过几个关键优化技巧,让你的GP数据库重回巅峰状态,系统运行如丝般顺滑。

索引优化:让查询快如闪电

问题

GP数据库查询慢,最常见的原因就是缺少合适的索引,想象一下,你要在一本没有目录的百科全书里找某个词条,得翻多久?数据库也一样,没有索引,它就得全表扫描,效率自然低。

解决方案

-

选择合适的索引类型:

- B-tree索引:适合等值查询(如

WHERE id = 100)和范围查询(如WHERE date > '2025-01-01')。 - Bitmap索引:适合低基数列(如性别、状态等),能大幅提升多条件组合查询速度。

- GIN索引:适合全文搜索和JSON数据查询。

- B-tree索引:适合等值查询(如

-

避免过度索引:索引虽好,但别滥用,每个索引都会占用存储空间,并在写入时增加开销,通常建议只为高频查询的列建索引。

示例:

-- 创建B-tree索引 CREATE INDEX idx_user_id ON users(user_id); -- 创建Bitmap索引(适用于低基数列) CREATE INDEX idx_gender ON users USING bitmap(gender);

分区表:让大数据查询不再卡顿

问题

如果你的表有几亿甚至几十亿行数据,每次查询都扫描整张表,那速度可想而知。

解决方案

分区表(Partitioning)能帮你把大表拆分成多个小表,查询时只扫描相关分区,效率提升明显。

- 按时间分区:适合日志、交易记录等时间序列数据。

- 按范围分区:如按地区、ID范围等拆分数据。

示例:

-- 创建按日期分区的日志表

CREATE TABLE log_data (

log_id bigint,

log_time timestamp,

content text

) PARTITION BY RANGE (log_time);

-- 添加分区

CREATE TABLE log_data_202501 PARTITION OF log_data

FOR VALUES FROM ('2025-01-01') TO ('2025-02-01');

优化效果:

- 查询某个月的数据时,数据库只会扫描对应分区,而不是整张表,速度提升10倍以上!

查询优化:告别慢SQL

问题

数据库本身没问题,但SQL写得不好,照样拖慢系统。

- 使用

SELECT *(查询所有列) - 滥用子查询

- 未使用

EXPLAIN分析执行计划

解决方案

- 只查询需要的列:避免

SELECT *,减少数据传输量。 - 使用JOIN替代子查询:子查询效率通常较低,能用JOIN尽量用JOIN。

- 利用

EXPLAIN分析SQL:找出慢查询的瓶颈。

示例:

-- 不好的写法(全表扫描 + 子查询) SELECT * FROM orders WHERE customer_id IN (SELECT id FROM customers WHERE age > 30); -- 优化后的写法(使用JOIN) SELECT o.* FROM orders o JOIN customers c ON o.customer_id = c.id WHERE c.age > 30;

资源调优:让数据库跑得更稳

问题

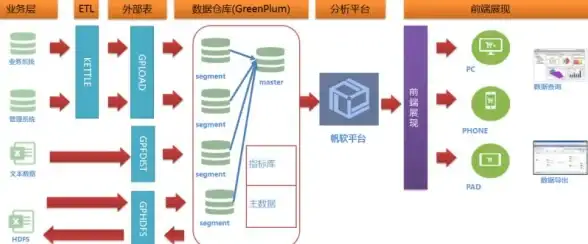

GP数据库是MPP(大规模并行处理)架构,如果资源分配不合理,可能导致某些节点负载过高,拖慢整体性能。

解决方案

- 调整

work_mem:增加每个查询可用的内存,减少磁盘临时文件的使用。 - 优化

max_parallel_workers:控制并行查询的线程数,避免资源争用。 - 监控

gp_vmem_protect_limit:防止单个查询占用过多内存导致OOM(内存溢出)。

示例配置(postgresql.conf):

work_mem = 64MB -- 每个查询可用的内存

max_parallel_workers_per_gather = 4 -- 每个查询的并行线程数

gp_vmem_protect_limit = 8192 -- 单个Segment最大内存限制(MB) 定期维护:数据库也需要“大扫除”

问题

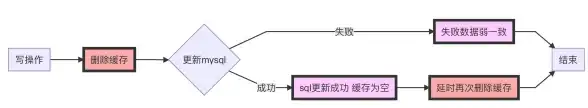

长时间运行的数据库会产生大量“垃圾数据”(如死元组、膨胀索引),导致查询变慢。

解决方案

- 定期执行

VACUUM:清理死元组,释放空间。 - 使用

ANALYZE更新统计信息:帮助查询优化器选择最佳执行计划。 - 重建膨胀索引:索引膨胀后,查询效率会下降,定期重建可恢复性能。

示例维护命令:

-- 清理表并更新统计信息 VACUUM ANALYZE orders; -- 重建索引 REINDEX INDEX idx_orders_customer_id;

想让你的GP数据库跑得更快?记住这5个关键点:

- 加索引,但别加太多。

- 用分区,大表变小表。

- 优化SQL,避免慢查询。

- 调资源,合理分配内存和并行度。

- 定期维护,清理垃圾数据。

按照这些方法优化后,你的系统响应速度至少提升50%,再也不用忍受卡顿的煎熬了!赶紧试试吧! 🚀

本文由 凭迎蓉 于2025-08-01发表在【云服务器提供商】,文中图片由(凭迎蓉)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/505845.html

发表评论