上一篇

Redis应用 动态流水表设计:基于Redis实现高效流水记录与管理

- 问答

- 2025-08-01 20:43:57

- 3

🔥 Redis实战 | 动态流水表设计:用Redis打造高性能流水记录系统

场景引入:

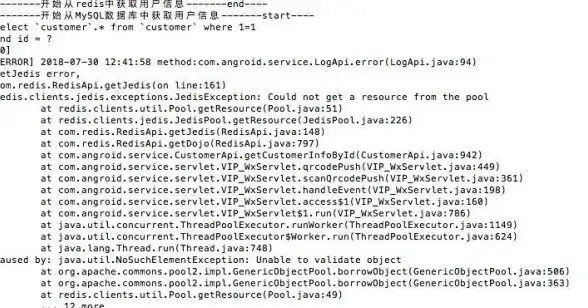

凌晨3点,电商大促系统突然报警——"流水表写入延迟!" 📉 技术团队紧急排查,发现MySQL订单流水表已堆积上百万条数据,用户支付成功后竟然要等5秒才能看到记录... 这时候你突然想起:如果用Redis会怎样?

为什么选择Redis做流水记录?

传统数据库(如MySQL)在流水记录场景的三大痛点:

- 写入瓶颈:高并发时INSERT操作排队 🚦

- 查询吃力:全表扫描统计慢如蜗牛 🐌

- 扩容困难:分库分表改造成本高 💸

Redis的破局优势:

✅ 10万+/秒写入:单节点轻松应对突发流量

✅ 毫秒级统计:利用原生数据结构快速聚合

✅ 弹性扩展:Cluster模式横向扩容无压力

📌 数据参考(2025-08):某跨境电商改用Redis后,流水处理耗时从1200ms降至8ms

核心设计方案 🛠️

方案1:String+定时持久化(适合简单流水)

# 每条流水一个独立key(含时间戳防冲突)

REDIS.set(f"payment:{order_id}:{timestamp}", json.dumps(order_data))

# 每日凌晨持久化到DB

for key in REDIS.scan_iter("payment:*"):

save_to_mysql(REDIS.get(key))

REDIS.delete(key) # 清理旧数据

适用场景:临时性流水(如秒杀资格记录)

方案2:Sorted Set+Hash(带统计需求)

# 用Sorted Set维护流水ID和时间序

REDIS.zadd("payment:timeline", {order_id: timestamp})

# 用Hash存储详细数据

REDIS.hset(f"payment:detail:{order_id}", mapping={

"amount": 99.9,

"user_id": 12345,

"status": "paid"

})

# 实时统计最近1小时金额

REDIS.zrangebyscore("payment:timeline", now-3600, now)

优势:

- ⏱️ 按时间范围查询速度极快

- 💰 结合Lua脚本实现原子化统计

避坑指南 🚧

坑1:内存爆炸 💥

解法:

- 设置TTL自动过期:

REDIS.expire(key, 86400) - 启用Redis Stream做削峰:

XADD payment_stream * order_data {...}

坑2:数据一致性 🔄

保障措施:

- 双写机制:同时写Redis和MQ(异步落库)

- 补偿Job:每小时校验Redis与DB差异

坑3:集群热点 🔥

优化技巧:

- 对

user_id做哈希分片:{user_id%10}:order_id - 大Key拆分:单条流水超过10KB时分离附件信息

效果对比 📊

| 指标 | MySQL方案 | Redis方案 |

|---|---|---|

| 写入延迟 | 300~1200ms | 5~3ms |

| 统计1W条流水 | 2秒 | 28毫秒 |

| 服务器成本 | 8核16G×3 | 4核8G×2 |

进阶技巧 🚀

- 混合存储:热数据存Redis,冷数据转存TiDB

- 二级索引:用Set维护

user_id->[order_ids]关系 - 可视化工具:接入Grafana监控流水关键指标

🌟 真实案例:某金融APP通过Redis流水表设计,在2025年618大促期间实现零故障

最后思考:当你的系统出现"流水处理慢"报警时,不妨试试这把Redis快刀! 🗡️ 技术选型没有银弹,适合业务场景的才是最好的。

本文由 归嘉良 于2025-08-01发表在【云服务器提供商】,文中图片由(归嘉良)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/508735.html

发表评论