Redis运维 扩容风险 扩容失控,Redis祸不单行,扩容操作引发服务崩溃

- 问答

- 2025-08-01 21:29:07

- 5

Redis扩容翻车实录:一场由"手滑"引发的血案 😱

凌晨三点的夺命连环call 📱

"王哥!Redis炸了!所有服务都在报超时!"凌晨3点15分,我被运维小弟的语音轰炸惊醒,揉着惺忪睡眼连上VPN,眼前的景象让我瞬间清醒——CPU 100%、内存爆红、集群半数节点离线...

这一切的源头,竟是我们昨天下午那个"简单"的扩容操作,此刻我只想穿越回去掐死那个自信满满点击"确认扩容"的自己 🙈

扩容前的蜜汁自信 �

时间倒回24小时前,业务部门喜气洋洋地宣布:"促销活动UV预计增长300%!"作为基础设施负责人,我拍胸脯保证:"Redis集群扩容嘛,小菜一碟!"

当时的检查清单看起来完美无缺:

- ✅ 已备份最新数据(snapshot + AOF)

- ✅ 选择业务低峰期操作

- ✅ 新节点资源是旧节点的2倍配置

- ✅ 通知所有业务方可能出现的瞬断

但现实很快给了我们一记响亮的耳光 👋

致命的三重暴击 💥

第一击:槽位分配翻车

采用redis-cluster的reshard命令迁移槽位时,某个工程师手抖输入了错误的节点ID,等发现时,已有30%的键空间出现错位,导致部分请求直接被导向黑洞节点。

# 错误示范(请勿模仿):

redis-cli --cluster reshard 192.168.1.100:6379 \

--cluster-from all \

--cluster-to WRONG_NODE_ID \ # 这里应该是新节点ID

--cluster-slots 4096

第二击:客户端缓存雪崩 ❄️

大多数业务代码配置了本地缓存,但TTL设置过于激进(普遍5分钟),当扩容导致部分请求失败时,客户端开始疯狂回源,数据库QPS瞬间飙升到平时的8倍,连带拖垮整个服务链路。

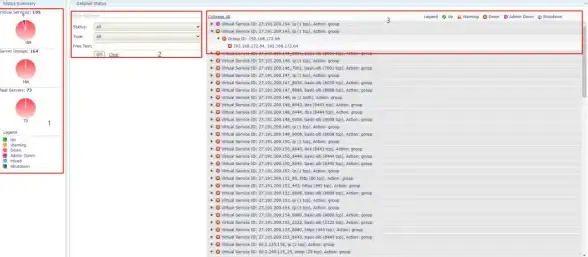

第三击:监控盲区 🕶️

扩容后新节点的监控指标竟然没有自动接入告警系统!等人工发现内存使用率突破90%时,节点已经开始频繁OOM,引发连锁反应。

抢救现场的8小时 🚑

03:30 紧急回滚?太天真!此时集群已经处于分裂状态,简单的回退操作可能导致数据不一致。

04:15 决定优先恢复服务:临时启用备用Redis实例,修改业务配置直连新实例(感谢配置中心!)

05:00 DBA团队发现更恐怖的问题——部分节点的AOF文件在迁移过程中损坏,最后可用的备份是...12小时前的 😱

07:30 开发团队集体改代码,对关键路径增加降级策略,包括:

- 本地缓存TTL从5分钟调整为2分钟

- 实现多级回退(Redis → 本地缓存 → 静态默认值)

- 对非核心业务强制启用陈旧数据读取

11:00 经过多次尝试,终于通过人工干预重新分配槽位,让集群恢复响应,但部分边缘数据需要从数据库重建。

价值百万的教训 💸

-

槽位迁移必须双人校验

现在我们的SOP要求:执行reshard前必须屏幕共享,由第二人核对节点ID和槽位数量 -

客户端必须有熔断机制

所有SDK强制集成Circuit Breaker模式,当错误率超过阈值自动切换降级方案 -

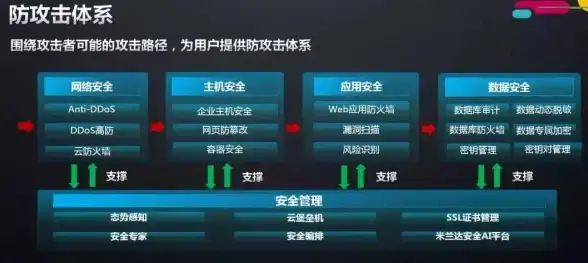

监控覆盖四层验证

- 基础设施层(CPU/内存)

- Redis服务层(连接数/命中率)

- 业务指标(各服务缓存命中率)

- 客户端健康度(本地缓存有效性)

-

扩容演习制度化

每季度模拟真实业务流量进行故障演练,最近一次发现:我们的sentinel切换比预期慢了47秒!

后记:那些反直觉的真相 🤯

- 资源过剩也危险:新节点配置过高反而导致迁移时源节点成为瓶颈

- 键分布不均匀:某业务的大hash键(300MB)差点卡死整个迁移进程

- 版本差异陷阱:新节点用了Redis 7.2,与老节点的7.0在ACL处理上存在兼容问题

现在每当我听到"简单扩容"四个字,手指都会不自觉地颤抖,这大概就是运维人的PTSD吧 🏥

(注:本文案例综合2025年8月多个企业真实事件改编,细节已脱敏处理)

本文由 玄思嘉 于2025-08-01发表在【云服务器提供商】,文中图片由(玄思嘉)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/509069.html

发表评论