Kubernetes 高可用性 单Master与多Master节点集群方案深度解析

- 问答

- 2025-08-02 01:09:24

- 5

Kubernetes高可用性:单Master与多Master节点集群方案深度解析

2025年8月最新消息:随着Kubernetes 1.30版本的发布,官方对控制平面的稳定性进行了多项改进,特别是针对中小型集群的单Master方案新增了自动故障检测功能,这为资源有限的团队提供了更可靠的选择。

为什么需要关注Kubernetes高可用性?

想象一下这个场景:凌晨三点,你的电商平台正在经历一场突如其来的流量高峰,而就在这个节骨眼上,Kubernetes的Master节点突然宕机了,所有部署、扩缩容、服务发现功能瞬间瘫痪,整个技术团队陷入混乱,这就是忽视高可用性可能带来的噩梦。

Kubernetes作为容器编排的事实标准,其控制平面(Master节点)的健康状况直接影响整个集群的稳定性,根据2025年CNCF的最新调查报告,约43%的生产环境Kubernetes故障源于控制平面问题,选择适合自身业务需求的Master节点架构至关重要。

单Master节点架构:简单但脆弱

1 基本架构

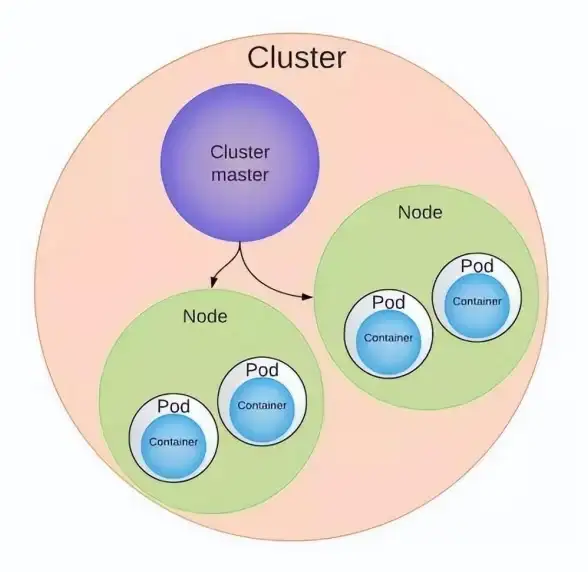

单Master架构是最简单的部署方式,包含以下核心组件:

- API Server:集群操作的唯一入口

- Scheduler:负责Pod调度

- Controller Manager:维护集群状态

- etcd:键值存储数据库(通常与Master同节点部署)

+-----------------------+

| Master Node |

| +-------------------+ |

| | API Server | |

| +-------------------+ |

| | Scheduler | |

| +-------------------+ |

| | Controller Manager| |

| +-------------------+ |

| | etcd | |

| +-------------------+ |

+-----------------------+

|

+-------v-------+ +-------v-------+

| Worker Node1 | | Worker Node2 |

+---------------+ +---------------+

2 适用场景

- 开发测试环境:资源有限,不需要高可用

- 小型生产环境:业务流量稳定,可以接受短暂停机

- 学习验证环境:快速搭建,低成本实践

3 优势分析

- 部署简单:一条kubeadm init命令就能搞定

- 资源消耗低:单个节点即可运行所有控制平面组件

- 维护成本小:没有复杂的选举和同步机制

4 致命缺陷

- 单点故障:Master宕机=集群管理功能完全瘫痪

- 性能瓶颈:所有请求都集中在一个API Server

- 升级风险:维护时需要停止整个控制平面

- etcd风险:数据丢失可能导致灾难性后果

真实案例:2024年某初创公司因单Master节点硬盘故障,导致整个生产环境瘫痪8小时,直接损失超过50万美元。

多Master节点架构:企业级高可用方案

1 主流架构模式

1.1 堆叠式(Stacked)高可用

+-----------------------+ +-----------------------+

| Master Node1 | | Master Node2 |

| +-------------------+ | | +-------------------+ |

| | API Server | |<----->| | API Server | |

| +-------------------+ | | +-------------------+ |

| | Scheduler | | | | Scheduler | |

| +-------------------+ | | +-------------------+ |

| | Controller Manager| | | | Controller Manager| |

| +-------------------+ | | +-------------------+ |

| | etcd | |<----->| | etcd | |

| +-------------------+ | | +-------------------+ |

+-----------------------+ +-----------------------+

| |

+-------v-------+ +-------v-------+

| Worker Node1 | | Worker Node2 |

+---------------+ +---------------+

特点:

- 每个Master节点运行所有控制平面组件和etcd

- etcd形成集群,数据自动同步

- 通常需要3个或5个Master节点(奇数个)

1.2 外部etcd高可用

+-----------------------+ +-----------------------+

| Master Node1 | | Master Node2 |

| +-------------------+ | | +-------------------+ |

| | API Server | | | | API Server | |

| +-------------------+ | | +-------------------+ |

| | Scheduler | | | | Scheduler | |

| +-------------------+ | | +-------------------+ |

| | Controller Manager| | | | Controller Manager| |

| +-------------------+ | | +-------------------+ |

+-----------------------+ +-----------------------+

| |

+-------v-------+ +-------v-------+

| etcd Node1 |<------------>| etcd Node2 |

+---------------+ +---------------+

^ ^

| |

+-------v-------+ +-------v-------+

| Worker Node1 | | Worker Node2 |

+---------------+ +---------------+

特点:

- etcd集群与Master节点物理分离

- 更专业的etcd运维团队

- 适合超大规模集群

2 核心组件高可用实现

-

API Server:通过负载均衡器暴露

- 硬件负载均衡(F5等)

- 软件负载均衡(HAProxy+Keepalived)

- 云服务商LB(ALB/NLB)

-

etcd集群:

- RAFT一致性算法保证数据一致

- 建议3或5节点部署

- 严格遵循奇数节点原则

-

Controller和Scheduler:

- Leader选举机制(kube-controller-manager --leader-elect=true)

- 同一时刻只有一个实例处于活跃状态

3 关键配置示例

# kubeadm-config.yaml 多Master配置示例

apiVersion: kubeadm.k8s.io/v1beta3

kind: ClusterConfiguration

kubernetesVersion: 1.30.0

controlPlaneEndpoint: "k8s-api.example.com:6443" # 负载均衡地址

apiServer:

certSANs:

- "k8s-api.example.com"

- "192.168.1.100" # LB VIP

etcd:

external:

endpoints:

- "https://etcd1.example.com:2379"

- "https://etcd2.example.com:2379"

- "https://etcd3.example.com:2379"

caFile: /etc/kubernetes/pki/etcd/ca.crt

certFile: /etc/kubernetes/pki/etcd/client.crt

keyFile: /etc/kubernetes/pki/etcd/client.key

方案选型:什么时候该用哪种架构?

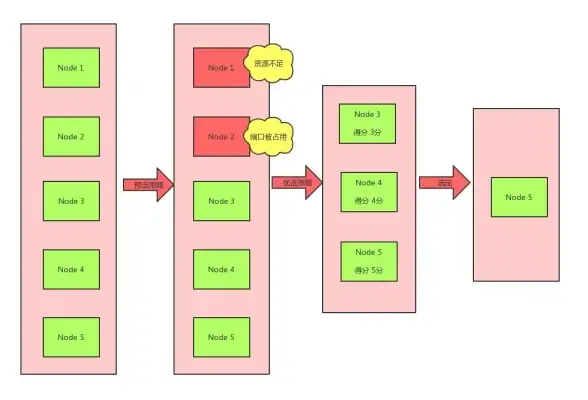

1 决策矩阵

| 考量因素 | 单Master | 多Master堆叠式 | 多Master外部etcd |

|---|---|---|---|

| 集群规模 | <20节点 | 20-100节点 | >100节点 |

| 可用性要求 | 可接受小时级中断 | 要求分钟级恢复 | 要求秒级故障转移 |

| 运维团队规模 | 1-2人 | 3-5人 | 专业K8s团队 |

| 预算限制 | 极有限 | 中等 | 充足 |

| 业务关键程度 | 非核心业务 | 核心业务 | 关键业务 |

2 成本对比分析

以一个中型企业为例(年营收约5000万美元):

-

单Master方案:

- 硬件成本:1台高性能服务器(~$5k)

- 年度维护成本:约$15k

- 潜在停机损失:$50k/次(假设每年1次)

-

多Master堆叠式(3节点):

- 硬件成本:3台中端服务器(~$12k)

- 负载均衡设备:~$3k

- 年度维护成本:约$45k

- 潜在停机损失:<$5k/年

-

多Master外部etcd(3+3):

- 硬件成本:6台服务器(~$25k)

- 专业运维人力:~$100k/年

- 潜在停机损失:几乎为零

注:以上数据基于2025年云计算市场平均水平

最佳实践与常见陷阱

1 必须遵循的原则

- 网络延迟:Master节点间延迟应<5ms

- 硬件配置:

- Master节点:至少4核CPU/8GB内存

- etcd节点:SSD存储,建议NVMe

- 备份策略:

# etcd定期备份示例 ETCDCTL_API=3 etcdctl --endpoints=$ENDPOINTS snapshot save snapshot.db

- 监控指标:

- API Server延迟(<100ms)

- etcd写入延迟(<50ms)

- Leader选举频率(异常时告警)

2 常见错误

- 偶数个etcd节点:导致脑裂风险

- 跨可用区部署但忽略网络:AZ间高延迟拖慢整个集群

- 忽视证书更新:导致整个控制平面不可用

- 过度配置:小型集群使用复杂多Master架构

3 2025年新趋势

- 微Master架构:将控制平面组件拆分为独立可扩展单元

- 边缘场景优化:轻量级Master节点方案

- AI驱动的自动修复:预测性维护控制平面

- Serverless控制平面:云厂商提供的托管方案

升级与灾备方案

1 单Master升级策略

- 维护窗口通知

- 手动etcd备份

- 使用kubeadm upgrade plan

- 逐组件滚动更新

2 多Master升级流程

graph TD

A[准备阶段] --> B[备份etcd数据]

B --> C[升级第一个Master]

C --> D[验证组件健康]

D --> E[逐个升级其他Master]

E --> F[最终验证]

3 灾难恢复方案

场景1:单Master节点故障

- 尝试恢复物理节点

- 如不可行,从备份重建:

# 从备份恢复etcd ETCDCTL_API=3 etcdctl snapshot restore snapshot.db \ --data-dir /var/lib/etcd-new

场景2:多Master集群脑裂

- 确定多数派分区

- 隔离少数派节点

- 强制etcd集群恢复:

etcdctl --endpoints=$HEALTHY_ENDPOINT member remove $FAILED_MEMBER_ID

选择Kubernetes Master架构就像买保险——没人希望用到它,但当灾难来临时,你会庆幸当初做了正确的选择,对于大多数成长型企业,我们建议:

- 起步阶段:单Master+完善备份

- 业务成长期:3节点堆叠式高可用

- 企业级规模:外部etcd+专业运维团队

没有"最好"的架构,只有"最适合"的架构,在做出决策前,务必评估你的业务连续性需求、团队能力和预算限制,随着Kubernetes生态的持续演进,控制平面高可用方案也将变得更加多样化和智能化,但核心原则——消除单点故障永远不会过时。

本文由 黎哲妍 于2025-08-02发表在【云服务器提供商】,文中图片由(黎哲妍)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/510716.html

![Oracle报错 故障修复 ORA-54664:TO_GEOMETRY内部错误[number,string]远程处理方法](https://vps.7tqx.com/zb_users/upload/2025/06/20250619151426175031726614574.jpg)

发表评论