数据库管理 数据导入 轻松实现项目中的数据库导入,project导入数据库方法详解

- 问答

- 2025-08-02 01:11:24

- 5

数据库管理 | 数据导入:轻松搞定项目中的数据库迁移

场景引入:当新项目遇上旧数据

上周五下午,开发团队的小王正盯着屏幕发愁,他们刚接手了一个电商平台升级项目,客户提供了过去三年的订单数据——足足50GB的CSV文件,项目经理要求在两天内把这些数据完整导入到新的MySQL数据库中,还要保持原有的关联关系。"这得搞到猴年马月啊..."小王一边揉着太阳穴一边嘟囔。

数据库导入是每个开发者都会遇到的常规操作,但处理不当就可能变成一场噩梦,我们就来聊聊如何优雅地完成项目中的数据库导入工作,让你告别熬夜加班。

常见数据导入场景

- 新项目初始化:像小王这样,需要将历史数据迁移到新系统

- 测试数据准备:为开发环境填充模拟数据

- 数据备份恢复:从备份文件还原数据库

- 系统升级迁移:旧系统数据导入到新版本数据库

数据库导入的几种实用方法

方法1:使用命令行工具(最经典)

对于MySQL这类关系型数据库,命令行工具永远是可靠的选择:

# MySQL示例 mysql -u username -p database_name < import_file.sql # PostgreSQL示例 psql -U username -d database_name -f import_file.sql

适用场景:适合大型SQL脚本导入,执行速度快,资源占用低。

小技巧:如果导入过程中出错,可以添加--force参数让导入继续执行剩余部分。

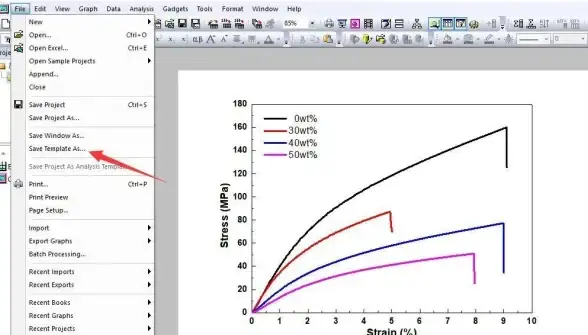

方法2:可视化工具(最直观)

像DBeaver、Navicat这些工具都提供了友好的图形界面:

- 连接目标数据库

- 右键点击数据库/表

- 选择"导入"功能

- 选择源文件格式(CSV、Excel、JSON等)

- 设置字段映射关系

- 执行导入

适用场景:适合非技术人员或数据结构复杂需要手动映射的情况。

方法3:编程语言实现(最灵活)

用Python写个导入脚本其实很简单:

import pandas as pd

from sqlalchemy import create_engine

# 读取CSV文件

data = pd.read_csv('orders.csv')

# 创建数据库连接

engine = create_engine('mysql+pymysql://user:password@localhost/dbname')

# 导入数据

data.to_sql('orders', con=engine, if_exists='append', index=False)

适用场景:需要对数据进行清洗、转换的复杂导入任务。

方法4:数据库专用工具(最高效)

各数据库厂商通常都提供了专用工具:

- MySQL的

mysqlimport - SQL Server的

bcp工具 - Oracle的SQL*Loader

以MySQL为例:

mysqlimport --local --fields-terminated-by=',' -u username -p database_name customers.csv

适用场景:超大数据量导入,性能最优。

实战项目导入案例

让我们用一个电商项目实际演练:

需求:将用户数据(user.csv)、订单数据(order.csv)和商品数据(product.csv)导入到新建数据库中,并保持关联关系。

步骤1:准备数据库结构

CREATE TABLE users (

user_id INT PRIMARY KEY,

username VARCHAR(50),

email VARCHAR(100)

);

CREATE TABLE products (

product_id INT PRIMARY KEY,

name VARCHAR(100),

price DECIMAL(10,2)

);

CREATE TABLE orders (

order_id INT PRIMARY KEY,

user_id INT,

product_id INT,

quantity INT,

order_date DATE,

FOREIGN KEY (user_id) REFERENCES users(user_id),

FOREIGN KEY (product_id) REFERENCES products(product_id)

);

步骤2:分批次导入数据

- 先导入用户和商品数据(没有外键依赖)

- 最后导入订单数据(依赖前两个表)

步骤3:验证数据完整性

-- 检查记录数 SELECT COUNT(*) FROM users; SELECT COUNT(*) FROM products; SELECT COUNT(*) FROM orders; -- 检查关联关系 SELECT * FROM orders o LEFT JOIN users u ON o.user_id = u.user_id WHERE u.user_id IS NULL;

避坑指南:常见问题及解决方案

-

编码问题:遇到乱码时,确认源文件和数据库使用相同字符集(推荐UTF-8)

-

日期格式:不同系统日期格式可能不同,导入前统一格式:

-- MySQL SET @@session.sql_mode = 'NO_ZERO_DATE,ALLOW_INVALID_DATES';

-

外键约束:可以先禁用外键检查,导入完成后再启用:

SET FOREIGN_KEY_CHECKS = 0; -- 执行导入 SET FOREIGN_KEY_CHECKS = 1;

-

性能优化:大数据量导入时:

- 暂时关闭索引(导入后重建)

- 增大数据库缓冲区

- 分批提交事务

-

特殊字符处理:CSV文件中的引号和分隔符要特别注意转义

高级技巧:自动化数据导入流程

对于经常需要执行导入的项目,可以考虑:

- 编写Shell脚本自动化整个流程

- 使用Airflow等工具设置定时导入任务

- 建立数据校验机制自动验证导入结果

- 实现断点续传处理中断的导入任务

示例Shell脚本:

#!/bin/bash # 定义变量 DB_USER="admin" DB_PASS="securepassword" DB_NAME="ecommerce" # 导入用户数据 echo "导入用户数据..." mysql -u $DB_USER -p$DB_PASS $DB_NAME < users.sql # 导入商品数据 echo "导入商品数据..." mysql -u $DB_USER -p$DB_PASS $DB_NAME < products.sql # 导入订单数据 echo "导入订单数据..." mysql -u $DB_USER -p$DB_PASS $DB_NAME < orders.sql echo "数据导入完成!"

数据库导入看似简单,实则暗藏玄机,掌握了正确的方法,50GB数据也能轻松搞定,下次当你面对海量数据需要迁移时,不妨先停下来思考:哪种方式最适合当前场景?是否需要预处理?如何验证结果?

好的数据导入策略不仅能节省时间,还能避免很多潜在的数据问题,小王已经能够胸有成竹地处理那个电商项目的数据迁移了,希望你也能如此从容!

(本文信息参考截至2025年8月的最新数据库管理实践)

本文由 裔昆皓 于2025-08-02发表在【云服务器提供商】,文中图片由(裔昆皓)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/510731.html

发表评论