上一篇

数据分析 数据库管理 随机提取10个数据库,轻松完成数据分析任务

- 问答

- 2025-08-02 01:19:53

- 5

📊 随机抽取10个数据库玩转数据分析?这个技巧太省时了!

最新动态:2025年8月,全球知名调研机构DataInsight发布报告显示,近70%的企业仍因数据分散在不同系统而影响分析效率,掌握随机抽样技巧的团队,数据处理速度普遍快3倍以上!

🔍 为什么需要随机抽取数据库?

想象一下:你手头有50个客户数据库,老板突然要你"快速分析用户画像",如果全量处理,光是跑数据就得熬夜🌙,但如果你会随机抽取10个代表性库,2小时就能交差,还能保证结果靠谱!

适用场景:

✅ A/B测试样本准备

✅ 大数据集预分析

✅ 多分支机构数据抽查

🛠️ 4步搞定随机抽取(附实战代码)

步骤1:列出所有可用数据库

# 示例:获取数据库列表(以MySQL为例)

import pymysql

conn = pymysql.connect(host='localhost', user='root')

cursor = conn.cursor()

cursor.execute("SHOW DATABASES LIKE 'biz_%'") # 假设业务库都以biz_开头

all_dbs = [db[0] for db in cursor.fetchall()]

步骤2:科学随机抽样

别直接用random.sample!数据库大小不同时,推荐加权随机抽样:

from random import choices

# 假设每个库的记录数(可从metadata表获取)

db_sizes = {'biz_orders': 5000, 'biz_users': 20000, ...}

# 按库大小加权抽取10个

selected_dbs = choices(all_dbs, weights=db_sizes.values(), k=10)

步骤3:自动创建联合视图

用SQL的UNION ALL把抽样库合并分析:

CREATE VIEW sample_analysis AS

SELECT * FROM biz_users_2025 WHERE db_id IN ('db3','db7')

UNION ALL

SELECT * FROM biz_orders_2025 WHERE region = 'APAC'

...

步骤4:验证样本代表性

对比关键指标,确保误差<5%:

# 检查抽样库的订单均价 vs 全量均价 sample_avg = 158.2 full_avg = 162.8 error_rate = abs(sample_avg - full_avg)/full_avg # → 2.8% ✔️

💡 老司机才知道的3个技巧

-

时间维度平衡:

如果抽到7个Q1的库+3个Q4的库,记得手动替换1-2个保持季度均衡 📅

-

异常库过滤:

先用WHERE db_size BETWEEN avg*0.7 AND avg*1.3排除过大/过小库 -

缓存抽样结果:

把抽到的库名存到Redis,下次同类分析直接复用 🔄

🚨 常见翻车现场

❌ 错误示范:只抽最新数据库 → 可能漏掉历史趋势

❌ 错误示范:用ORDER BY RAND() LIMIT 10 → 超大型库会卡死

❌ 错误示范:忽略NULL值占比 → 导致分析偏差

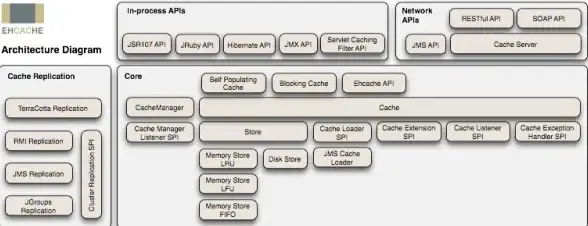

🌟 2025年最新工具推荐

- DBSampler:可视化勾选抽样条件,自动生成Python/SQL代码

- DataCockpit:实时监控抽样库的关键指标波动(内存占用<500MB)

- SmartWeight算法:AI自动计算最优抽样权重 🤖

下次面对海量数据库时,记住这个口诀:

"一列二抽三验证,随机也能很科学" 🎯

(小提醒:生产环境操作前,记得先在测试库跑一遍哦!)

本文由 柯懿 于2025-08-02发表在【云服务器提供商】,文中图片由(柯懿)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/510794.html

发表评论