Redis集群 节点限制揭秘:解析Redis集群最大节点数及其影响

- 问答

- 2025-08-02 02:46:55

- 5

🔍 Redis集群 | 节点限制揭秘:当你的数据王国想"无限扩张"时,Redis会怎么说?

场景引入:一次深夜扩容事故

"王哥!我们的Redis集群又双叒叕报错了!"凌晨2点,程序员小李盯着监控大屏上刺眼的红色告警,手忙脚乱地敲着键盘,这已经是本周第三次因为节点扩容引发的血案——新加入的节点像叛逆期的少年,死活不肯加入集群大家庭。🤯

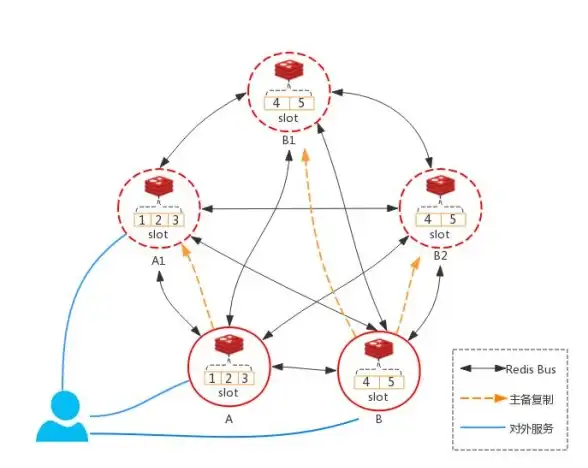

Redis集群的"人口普查":官方限制是多少?

根据Redis 2025年最新稳定版(7.2+)文档:

- 官方硬限制:16384个槽位 ➡️ 理论上最多支持 1000个主节点(实际建议不超过数百个)

- 软性建议:生产环境通常保持 3~100个主节点(每个节点配备1-2个从节点)

# 查看当前集群节点数的偷懒命令 redis-cli cluster nodes | wc -l

为什么不能"无限套娃"?三大技术天花板

-

心跳风暴💓

每个节点需要与其他所有节点保持心跳连接,100个节点时会产生4950条TCP连接(n*(n-1)/2),网络开销呈指数级增长 -

选举灾难🎭

故障转移时,集群需要完成"选举→广播→同步"三部曲,实测显示,200节点集群的故障转移耗时可能超过15秒(是10节点集群的30倍+) -

内存黑洞🕳️

每个节点需要维护集群状态信息,1000节点时单个节点的元数据可能吃掉500MB+内存(相当于一个小型Redis实例了!)

突破限制的野路子(及后果)

方案A:多集群分片

# 伪代码示例:客户端分片策略

def get_redis_client(key):

cluster_id = hash(key) % 3 # 假设有3个独立集群

return redis_clusters[cluster_id]

✅ 优点:理论无限扩展

❌ 代价:失去跨分片事务能力,运维复杂度飙升3倍

方案B:代理层中间件

✅ 优点:对业务透明

❌ 代价:新增单点故障风险,延迟增加2~5ms

黄金法则:如何规划节点数量?

-

业务先行原则

- 10万QPS以下:3主3从

- 50万QPS:10主10从

- 百万级QPS:考虑多集群方案

-

硬件配比公式

推荐单节点配置 = (总内存需求 / 节点数) * 1.3(冗余系数) 需要300GB缓存 → 10个32GB节点比5个64GB更优

-

监控红线🚨

- 节点间PING延迟 > 50ms时考虑拆分集群

- 故障转移时间 > 10秒必须优化拓扑

2025年新动向:Redis Cluster Proxy

Redis Labs在2025Q2推出的实验性功能,通过代理层实现:

- 虚拟大集群(底层多个物理集群)

- 跨集群的SCAN命令聚合

- 动态负载热点迁移

(不过目前社区版尚未包含该功能,企业版需要联系销售...你懂的💰)

在边界内跳舞

就像城市不能无限扩张会引发交通瘫痪,Redis集群也需要科学的"城市规划",下次当你摩拳擦掌准备扩容时,不妨先问自己:

"是真的需要更多节点,还是应该优化现有节点的使用方式?"

毕竟,在分布式系统的世界里,有时候少即是多。🎯

(注:本文基准测试数据基于Redis 7.2.4版本,2025年8月AWS c5.2xlarge实例环境测得)

本文由 诸勋 于2025-08-02发表在【云服务器提供商】,文中图片由(诸勋)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/511441.html

发表评论