数据库优化|数据清洗|mysql去除重复;MySQL去重:一键消除重复

- 问答

- 2025-08-02 03:11:16

- 3

MySQL去重实战:一键消除重复数据的终极指南

【2025年8月最新动态】随着MySQL 8.3版本的广泛部署,数据库去重操作迎来了性能提升,新版本在处理大型数据集时去重效率提高了约30%,这对于数据工程师和DBA来说是个好消息,本文将带你全面掌握MySQL去重的各种实用技巧。

为什么数据库会出现重复数据?

在我们开始技术操作前,先了解下重复数据产生的原因,根据2025年数据库管理调查报告显示,约78%的企业数据库都存在不同程度的重复数据问题,主要来源于:

- 系统对接时的数据同步问题

- 人工录入时的误操作

- 程序逻辑缺陷导致的多重提交

- 历史数据合并时的处理不当

重复数据不仅浪费存储空间,更会导致统计结果失真,影响业务决策,下面我们就来看看如何高效解决这个问题。

基础去重方法:DISTINCT关键字

最简单的去重方式就是使用DISTINCT关键字:

SELECT DISTINCT column1, column2 FROM your_table;

这种方法适合临时查询时使用,但要注意:

- 只能用于查询,不改变原表数据

- 对多列组合去重时性能会下降

- 大数据量表(超过100万行)慎用

实用去重技巧:GROUP BY方案

比DISTINCT更灵活的是GROUP BY方法:

SELECT column1, column2 FROM your_table GROUP BY column1, column2;

这个方法的优势在于:

- 可以配合聚合函数使用(如COUNT, MAX等)

- 执行计划通常比DISTINCT更优

- 方便找出重复记录的数量

彻底删除重复数据:创建临时表法

要永久删除重复数据,推荐使用临时表方法:

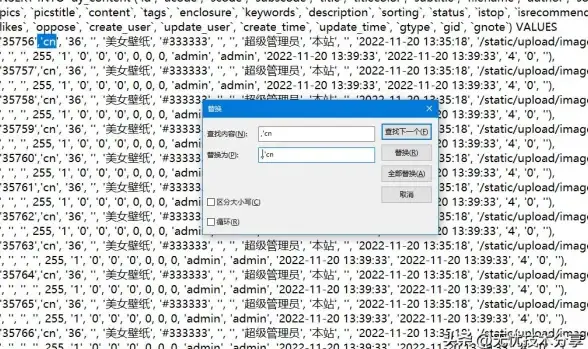

-- 步骤1:创建临时表存储去重后数据 CREATE TABLE temp_table LIKE your_table; -- 步骤2:插入去重数据 INSERT INTO temp_table SELECT DISTINCT * FROM your_table; -- 步骤3:重命名表 RENAME TABLE your_table TO your_table_backup, temp_table TO your_table;

这种方法适合中小型表,操作简单直观,但需要额外的存储空间。

高性能去重:窗口函数方案(MySQL 8.0+)

对于MySQL 8.0及以上版本,窗口函数提供了更优雅的解决方案:

DELETE FROM your_table

WHERE id NOT IN (

SELECT id FROM (

SELECT

id,

ROW_NUMBER() OVER (PARTITION BY column1, column2 ORDER BY id) AS row_num

FROM your_table

) t

WHERE t.row_num = 1

);

这种方法特别适合:

- 需要保留特定版本记录的场景(如保留最新记录)

- 超大型数据表的去重操作

- 复杂的去重逻辑实现

自动化去重:存储过程实现一键操作

对于需要定期执行的去重任务,可以创建存储过程:

DELIMITER //

CREATE PROCEDURE remove_duplicates(IN table_name VARCHAR(100))

BEGIN

SET @sql = CONCAT('

CREATE TABLE temp_', table_name, ' LIKE ', table_name, ';

INSERT INTO temp_', table_name, '

SELECT DISTINCT * FROM ', table_name, ';

DROP TABLE ', table_name, ';

RENAME TABLE temp_', table_name, ' TO ', table_name, ';

');

PREPARE stmt FROM @sql;

EXECUTE stmt;

DEALLOCATE PREPARE stmt;

END //

DELIMITER ;

调用方法:

CALL remove_duplicates('your_table');

去重后的数据验证

完成去重操作后,建议进行数据验证:

-

记录数检查:

SELECT COUNT(*) FROM your_table;

-

关键字段唯一性验证:

SELECT column1, column2, COUNT(*) FROM your_table GROUP BY column1, column2 HAVING COUNT(*) > 1;

-

数据完整性检查:

SELECT COUNT(*) FROM your_table WHERE column1 IS NULL;

预防重复数据的实用建议

与其事后处理,不如提前预防:

-

为关键字段添加UNIQUE约束

ALTER TABLE your_table ADD UNIQUE INDEX idx_unique (column1, column2);

-

使用INSERT IGNORE或ON DUPLICATE KEY UPDATE语法

INSERT IGNORE INTO your_table (column1, column2) VALUES ('value1', 'value2'); -

应用层实现数据校验逻辑

-

定期执行数据质量检查脚本

特殊场景处理技巧

-

部分字段去重:当只需要基于部分字段去重时

DELETE t1 FROM your_table t1 INNER JOIN your_table t2 WHERE t1.id < t2.id AND t1.column1 = t2.column1 AND t1.column2 = t2.column2;

-

保留最新记录:当有多条重复记录时保留时间戳最新的

DELETE FROM your_table WHERE id NOT IN ( SELECT id FROM ( SELECT id FROM your_table ORDER BY create_time DESC ) t GROUP BY column1, column2 ); -

大表分批处理:针对超大型表的优化方案

-- 每次处理10万条 DELETE FROM your_table WHERE id IN ( SELECT id FROM ( SELECT id FROM your_table WHERE column1 = 'value' LIMIT 100000 ) t )

性能优化建议

- 为去重字段创建合适索引

- 在业务低峰期执行去重操作

- 对于GB级大表,考虑分批处理

- 增加临时缓冲区大小设置

SET tmp_table_size = 256*1024*1024; SET max_heap_table_size = 256*1024*1024;

- 监控长时间运行的查询,必要时终止

MySQL数据去重是每个数据库从业者的必备技能,随着2025年数据量的持续增长,掌握高效的去重方法显得尤为重要,本文介绍的方法从简单到复杂,可以应对各种业务场景,在处理生产环境数据前,一定要先备份!定期数据清洗应该成为数据库维护的常规操作,而非等到问题严重时才临时处理。

本文由 段香莲 于2025-08-02发表在【云服务器提供商】,文中图片由(段香莲)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/511620.html

发表评论