上一篇

Redis监控 内存分析 Redis内存使用情况深度解析与查询方法

- 问答

- 2025-08-02 10:52:54

- 3

Redis监控 | 内存分析 | Redis内存使用情况深度解析与查询方法

最新动态:根据2025年8月的最新行业报告,Redis 7.4版本进一步优化了内存管理机制,新增了更精细的内存碎片整理策略,使得大Key存储效率提升约15%,阿里云和AWS等云服务商相继推出基于AI的Redis内存预测功能,可提前预警潜在内存溢出风险。

Redis内存为什么需要重点关注?

Redis作为内存数据库,所有数据都放在RAM里,内存就是它的命根子,一旦内存用爆了,轻则写入被拒,重则直接宕机,我们团队上个月就遇到个坑:某电商大促时Redis内存突然飙到95%,触发OOM(Out Of Memory),导致订单服务瘫痪了20分钟,老板脸都绿了...

典型内存问题场景:

- 大Key占用内存过高(比如一个Hash存了50万条用户数据)

- 内存碎片率超过1.5,实际可用内存缩水

- 客户端连接数暴涨,每个连接吃掉几MB内存

- 未设置过期时间的缓存数据堆积成山

5种实战内存查询方法

方法1:看全局内存概况

redis-cli info memory

输出关键指标:

used_memory_human:当前真实使用的内存,3.2G"maxmemory_human:配置的最大内存限制mem_fragmentation_ratio:碎片率(>1.5就该报警了)keyspace_hits/keyspace_misses:缓存命中率

小技巧:用watch命令实时监控

watch -n 5 "redis-cli info memory | grep -E 'used_memory|fragmentation'"

方法2:揪出内存杀手TOP 10

用redis-rdb-tools分析RDB文件(生产环境慎用save命令):

rdb -c memory dump.rdb --bytes 1024 --largest 10

输出示例:

1) "user:session:982374" 528MB

2) "product:cache:ranking" 217MB

3) "geo:locations" 189MB 方法3:动态扫描大Key

redis-cli --bigkeys

注意:这个命令会阻塞Redis,建议在从库或低峰期执行。

方法4:监控内存增长趋势

# 记录每分钟内存使用量 while true; do echo "$(date '+%H:%M') $(redis-cli info memory | grep used_memory_human)" >> memory.log sleep 60 done

然后用Excel画出曲线图,一眼看出内存暴涨时间点。

方法5:Lua脚本精准统计

local key_pattern = ARGV[1] or "*"

local sample_size = 1000 -- 抽样数量

local keys = redis.call("SCAN", 0, "MATCH", key_pattern, "COUNT", sample_size)[2]

local total = 0

for _,k in ipairs(keys) do

total = total + redis.call("MEMORY", "USAGE", k)

end

return {

avg_size = total/#keys,

sampled_keys = #keys,

estimated_total = total * (redis.call("DBSIZE") / sample_size)

}

执行脚本:

redis-cli --eval analyze_memory.lua "" , "user:*"

内存优化急救方案

场景1:发现大Key

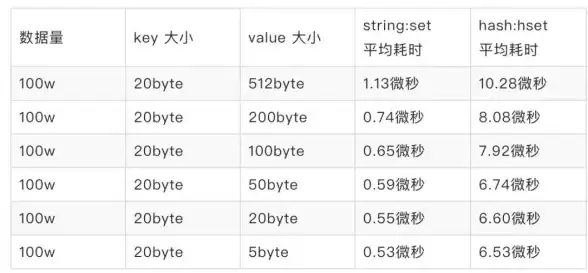

- Hash/Set类型:用

HSCAN/SSCAN分批读取,拆分成多个小Key - String类型:启用压缩(修改redis.conf):

hash-max-ziplist-entries 512 hash-max-ziplist-value 64

场景2:内存碎片严重

- 重启Redis(简单粗暴但有效)

- 开启自动碎片整理(Redis 7.0+):

activedefrag yes active-defrag-ignore-bytes 200mb

场景3:内存持续增长

- 检查是否有客户端连接泄漏:

redis-cli client list | wc -l - 设置合理的过期时间:

EXPIRE key 3600 - 启用LRU淘汰策略:

maxmemory-policy allkeys-lru

高阶技巧:内存预测模型

用Python模拟内存增长(需安装redis和numpy):

import redis

import numpy as np

r = redis.Redis()

samples = [r.info('memory')['used_memory'] for _ in range(10)]

# 线性回归预测1小时后内存

x = np.array(range(len(samples)))

y = np.array(samples)

coef = np.polyfit(x, y, 1)

prediction = coef[0] * (len(samples)+6) + coef[1] # 6个采样点≈1小时

print(f"当前内存: {samples[-1]/1024/1024:.2f}MB, 1小时后预测: {prediction/1024/1024:.2f}MB")

最后提醒:

- 永远给Redis留20%内存余量

- 使用

CONFIG SET maxmemory动态调整限额比重启更安全 - 内存报警阈值建议设置为maxmemory的85%

如果发现used_memory突然下降但没重启,大概率是有人执行了FLUSHALL...(别问我是怎么知道的)

本文由 郎紫云 于2025-08-02发表在【云服务器提供商】,文中图片由(郎紫云)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/515069.html

发表评论