缓存优化|高可用架构|灵活运用Redis主从哨兵缓存技术,深入解析redis的主从哨兵缓存

- 问答

- 2025-08-02 10:58:54

- 7

深入玩转Redis主从哨兵缓存技术

场景引入:电商大促的缓存危机

"王工,咱们的秒杀系统又挂了!"凌晨3点,运维小张的紧急电话把我从睡梦中惊醒,打开监控一看,Redis节点CPU飙到100%,整个商品详情页全部超时——这已经是本月第三次了,作为电商平台的架构师,我意识到是时候彻底解决我们的缓存高可用问题了。

第二天晨会上,我提出了重构方案:"我们需要基于Redis主从复制和哨兵机制,构建真正可靠的缓存架构。"CTO老李眉头紧锁:"主从+哨兵?具体怎么落地?性能损耗如何?故障切换会不会影响交易?"这些问题,正是本文要深入探讨的核心。

Redis主从架构:不只是数据备份

1 主从复制的工作原理

主从复制不是简单的文件拷贝,当我们在从节点执行replicaof 192.168.1.100 6379命令时,背后发生了这些事:

-

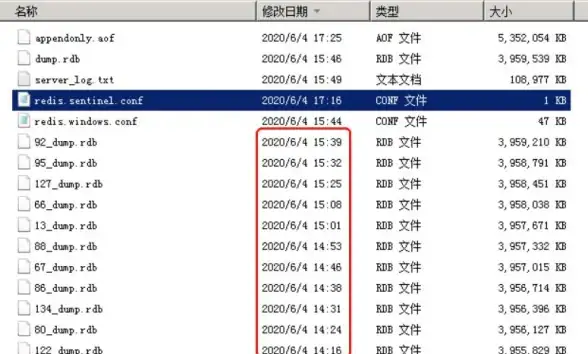

全量同步阶段:主节点执行BGSAVE生成RDB文件,同时用缓冲区记录新写入命令,我曾经在测试环境用

INFO replication观察到,一个10GB的实例同步耗时约8分钟。 -

增量同步阶段:主节点将写命令通过复制积压缓冲区(repl_backlog)发送给从节点,这个缓冲区大小很关键——我们曾经因为默认1MB设置导致网络抖动后全量同步,后来调整为

repl-backlog-size 256mb才解决。

# 生产环境推荐配置 repl-backlog-size 256mb repl-backlog-ttl 3600 client-output-buffer-limit replica 512mb 128mb 60

2 读写分离的实践陷阱

很多团队喜欢直接让应用读写分离:写主库,读从库,但我们在2024年双11踩过坑:

- 数据不一致:从库同步延迟导致用户看到"已售罄"却还能下单

- 连接风暴:某个热点商品查询压垮单个从节点

后来我们改用分级策略:

def get_product(product_id):

# 优先读本地缓存

data = local_cache.get(product_id)

if not data:

if is_hot_product(product_id): # 热点商品走主库

data = redis_master.get(product_id)

else:

data = redis_replica.get(product_id)

local_cache.set(product_id, data, 10)

return data

哨兵机制:自动故障转移的艺术

1 哨兵集群的部署要点

三个哨兵节点是最低要求,我们生产环境采用5节点部署,关键配置:

sentinel monitor mymaster 192.168.1.100 6379 3 sentinel down-after-milliseconds mymaster 5000 sentinel failover-timeout mymaster 60000 sentinel parallel-syncs mymaster 1

去年有一次机房断电,让我深刻理解了这些参数的意义:

down-after-milliseconds设为5秒,太短会导致网络抖动误判parallel-syncs控制新主库同时同步的从库数量,过大影响性能

2 故障转移全流程解析

当主节点真正宕机时,哨兵的工作流程像一场精密手术:

- 主观下线:某个哨兵检测到主节点无响应

- 客观下线:其他哨兵确认后投票达成共识

- 选举领导者:采用Raft算法选出主哨兵

- 故障转移:选择最优从节点提升为主节点

我们通过SENTINEL failover mymaster命令手动模拟过整个过程,平均耗时12秒,期间客户端需要正确处理MOVED重定向。

性能优化实战技巧

1 主从复制的性能瓶颈

我们在压测时发现,单线程的Redis复制可能成为瓶颈,特别是当:

- 主库写入QPS超过5万

- 从库机器配置较低

- 网络带宽不足

解决方案是采用树状复制架构:

[Master]

|

---------------------

| |

[Replica1] [Replica2]

| |

[Replica3] [Replica4]2 内存优化关键参数

这些参数直接影响缓存系统的稳定性:

# 防止主库复制积压过大被杀死 client-output-buffer-limit replica 2gb 1gb 300 # 适当调大TCP缓冲区 repl-backlog-size 512mb tcp-keepalive 60

异常场景处理经验

1 脑裂问题及解决方案

2024年我们经历过一次经典脑裂:机房网络分区导致出现双主节点,最终通过以下策略预防:

min-replicas-to-write 2 min-replicas-max-lag 10

2 缓存雪崩应对方案

当主从同时重启时,我们采用分级预热策略:

- 先恢复10%流量

- 逐步加载热点数据

- 全量数据加载完成前限流

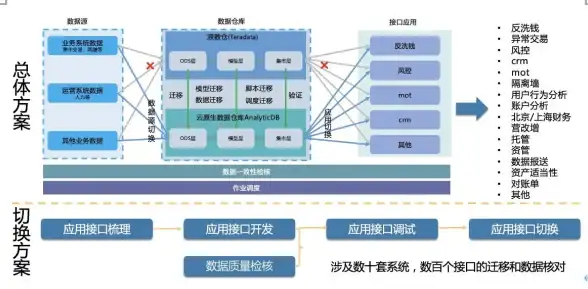

架构演进方向

随着业务发展,我们正在测试Redis Cluster方案,但主从+哨兵依然适用于:

- 数据量小于500GB的场景

- 需要简单易维护的架构

- 读写分离需求明确的业务

深夜的办公室里,我盯着监控屏幕上平稳运行的曲线——新的Redis架构已经稳定支撑了连续三个大促,技术选型没有银弹,理解主从哨兵这套经典组合的每个细节,才能在关键时刻做出正确决策,正如我们CTO常说的:"高可用不是买来的,是设计出来的。"

本文由 多文滨 于2025-08-02发表在【云服务器提供商】,文中图片由(多文滨)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/515114.html

发表评论