Redis优化 热点数据处理 解决Redis热点数据问题的有效方法探索

- 问答

- 2025-08-02 16:14:44

- 4

🔥 Redis优化 | 热点数据处理:当你的缓存系统遭遇"明星效应"

场景引入:双十一的崩溃瞬间

"小王,快看!我们的爆款商品页面又挂了!" 凌晨2点的办公室,技术主管老张拍着桌子喊道。🆘

这是电商公司第三次备战双十一,前两次都因为热点商品导致Redis集群崩溃,价值千万的促销活动,因为几个"明星商品"的超高访问量,让整个缓存系统不堪重负,服务器监控图上,那几个热点key的QPS曲线像火箭一样直冲云霄,而周围的其他key则平静如湖面...

这种"明星效应"在Redis中被称为热点数据问题,今天我们就来深入探讨如何驯服这些"数据明星"!

第一章:认识Redis热点数据问题

1 什么是热点数据?🤔

热点数据是指在短时间内被极高频率访问的少量数据,通常具有以下特征:

- 单个key的QPS远超平均水平(可能是其他key的百倍甚至千倍)

- 集中在特定时间段爆发(如秒杀活动、热门新闻发布)

- 通常只占全部数据的极小比例(不到1%)

2 热点数据的危害 💣

[监控警报] Redis节点CPU使用率100%! [用户反馈] 页面加载超时,无法下单! [老板震怒] 我们的系统就这么脆弱吗?!

热点数据会导致:

- 单节点过载:即使使用集群,相同key总是路由到同一节点

- 缓存击穿:热点key过期瞬间,海量请求直接压垮数据库

- 集群倾斜:数据分布不均,部分节点"忙死",其他节点"闲死"

第二章:热点数据检测三板斧 🕵️♂️

1 实时监控法 🔍

# 使用Redis命令实时监控

redis-cli --hotkeys

# 或者使用monitor命令采样分析

redis-cli monitor | head -n 1000 | awk '{print $5}' | sort | uniq -c | sort -nr

最佳实践:建立自动化监控系统,当单个key QPS超过阈值(如5000)时触发告警。

2 客户端埋点法 📌

在业务代码中添加访问统计:

// 伪代码示例

public Object getData(String key) {

metricsCollector.recordAccess(key); // 记录key访问

return redis.get(key);

}

3 代理层分析 🕵️♀️

如果使用Redis代理(如Twemproxy、Codis),可以在代理层实现热点统计:

# 伪代码:代理中间件记录key访问

def process_request(key):

hotspot_detector.record(key)

if hotspot_detector.is_hot(key):

trigger_cool_down(key)

第三章:六大解决方案实战 🛠️

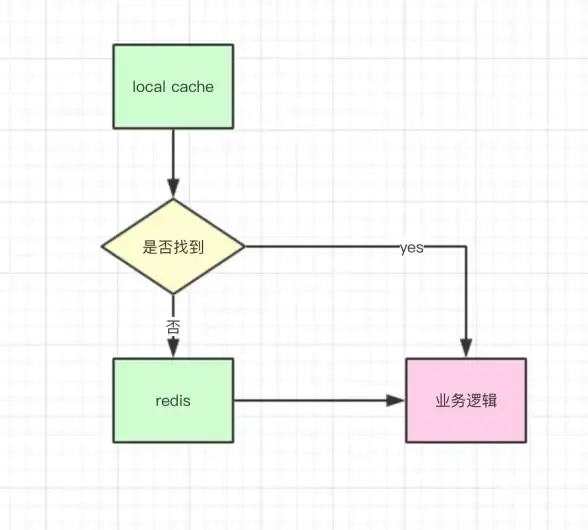

1 本地缓存盾牌 🛡️

对于极热点数据,使用多级缓存:

// 伪代码:Guava+Caffeine+Redis三级缓存

public Product getProduct(String id) {

// 1. 查本地缓存

Product product = localCache.get(id);

if (product == null) {

// 2. 查分布式缓存

product = redis.get(id);

if (product == null) {

// 3. 查数据库

product = db.get(id);

redis.setex(id, 300, product); // 设置5分钟过期

}

localCache.put(id, product); // 回填本地缓存

}

return product;

}

注意:本地缓存需要设置合理的过期时间(如1秒),避免数据不一致。

2 Key分片魔术 ✨

将热点key拆分为多个子key:

# 原始热点key

hot_key = "product_123"

# 分片方案

def get_sharded_key(base_key, shard_num=5):

import hashlib

shard = int(hashlib.md5(base_key.encode()).hexdigest()[:8], 16) % shard_num

return f"{base_key}_shard_{shard}"

# 写入时

for i in range(5):

redis.set(f"product_123_shard_{i}", data)

# 读取时

sharded_key = get_sharded_key("product_123")

data = redis.get(sharded_key)

3 随机过期时间 ⏳

避免热点key同时过期引发缓存雪崩:

// 伪代码:设置基础过期时间+随机偏移量 int baseExpire = 3600; // 1小时 int randomOffset = new Random().nextInt(600); // 0-10分钟随机 redis.setex(key, baseExpire + randomOffset, value);

4 读写分离策略 👥

配置Redis集群时,对热点key启用读写分离:

# Redis配置片段 replica-read-only yes

客户端代码调整:

// 伪代码:写请求走主节点,读请求可以走从节点

if (isWriteOperation(command)) {

sendToMaster(command);

} else {

sendToReplica(command);

}

5 限流熔断机制 🚦

使用令牌桶算法保护热点key:

// 伪代码:Golang限流实现

limiter := rate.NewLimiter(rate.Every(100*time.Millisecond), 10) // 每秒10个请求

func getHotData(key string) (interface{}, error) {

if !limiter.Allow() {

return nil, errors.New("too many requests")

}

return redis.Get(key)

}

6 热点数据预热 🔥

提前加载预期会成为热点的数据:

# 伪代码:活动开始前预热

def preheat_hot_items():

hot_items = predict_hot_items() # 预测热点商品

for item in hot_items:

redis.set(f"product_{item.id}", item.to_json())

redis.expire(f"product_{item.id}", 7200) # 2小时过期

print(f"🔥 已预热{len(hot_items)}个热点商品")

第四章:特殊场景解决方案 🎯

1 秒杀系统优化 ⚡

组合拳方案:

- 库存分段:将1000件库存拆分为10个100件的key

- 本地计数:客户端先本地扣减,批量提交

- 异步落库:最终一致性代替实时一致性

// 伪代码:秒杀核心逻辑

public boolean seckill(long itemId, long userId) {

// 1. 本地计数检查

if (!localCounter.tryAcquire()) {

return false; // 本地已售罄

}

// 2. 获取分布式分段锁

int segment = userId % 10;

String lockKey = "lock:" + itemId + ":" + segment;

try {

if (redis.setnx(lockKey, "1", 10)) { // 10秒锁

// 3. 检查分段库存

String stockKey = "stock:" + itemId + ":" + segment;

int stock = redis.decr(stockKey);

if (stock >= 0) {

// 4. 异步创建订单

mq.sendCreateOrderMessage(itemId, userId);

return true;

}

}

return false;

} finally {

redis.del(lockKey);

}

}

2 热点用户数据 👤

社交平台中明星用户的数据处理:

- 动态TTL:活跃用户设置较长缓存时间

- 主动刷新:用户发帖时主动更新缓存

- 差异缓存:粉丝看到的详细资料,路人看到精简版

def get_user_profile(user_id, is_fan=False):

cache_key = f"user:{user_id}:{'full' if is_fan else 'basic'}"

profile = redis.get(cache_key)

if not profile:

profile = db.get_profile(user_id, detailed=is_fan)

ttl = 86400 if is_active(user_id) else 3600 # 活跃用户缓存更久

redis.setex(cache_key, ttl, profile)

return profile

第五章:防坑指南 🚧

1 不要过度优化 🛑

"我们解决了热点问题,却创造了更多问题..." —— 某踩坑工程师

常见误区:

- 对所有数据都做多级缓存 → 内存爆炸💥

- 过度分片导致key数量膨胀 → 集群性能下降📉

- 复杂方案引入一致性风险 → 数据错乱🤯

2 性能测试必不可少 🧪

优化前后对比测试建议:

| 方案 | QPS提升 | 延迟降低 | 复杂度增加 | |----------------|--------|--------|----------| | 本地缓存 | 300% | 80% | 低 | | Key分片 | 150% | 40% | 中 | | 读写分离 | 120% | 20% | 高 |

3 监控-分析-优化闭环 🔄

建立持续优化机制:

- 监控:实时热点检测

- 分析:根因定位(是读多写少?还是大value?)

- 优化:针对性方案实施

- 验证:A/B测试效果

平衡的艺术 ⚖️

处理Redis热点数据没有银弹,关键在于找到性能与复杂度的平衡点,就像驯兽师面对猛兽,既不能放任不管,也不能过度控制,2025年的今天,随着Redis7.x新特性的出现(如Client-side caching、Function replication),我们有了更多武器来应对这一挑战。

最好的优化方案永远是适合你业务场景的那个,而不是看起来最高大上的那个,下次当你发现Redis监控图上出现那个熟悉的"高峰"时,希望你能会心一笑:"小样,这次我可准备好治你的招了!" 😎

最后的小贴士:在处理生产环境热点问题时,永远准备好回滚方案!一个小小的--rollback参数,可能比任何高深的技术更能保住你的年终奖。💰

本文由 宗政沙 于2025-08-02发表在【云服务器提供商】,文中图片由(宗政沙)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/517453.html

发表评论