缓存优化|高效更新 Redis缓存动态数据实时更新方法与实现,redis缓存动态更新

- 问答

- 2025-08-02 20:39:30

- 7

缓存优化 | 高效更新:Redis缓存动态数据实时更新方法与实现

场景引入:电商平台的库存困境

"小王,我们的秒杀活动又出问题了!"凌晨两点,运维主管的电话把我从睡梦中惊醒,打开电脑一看,数据库CPU已经飙到98%,原因是某款热门手机秒杀时,大量请求直接穿透缓存打到了数据库上。

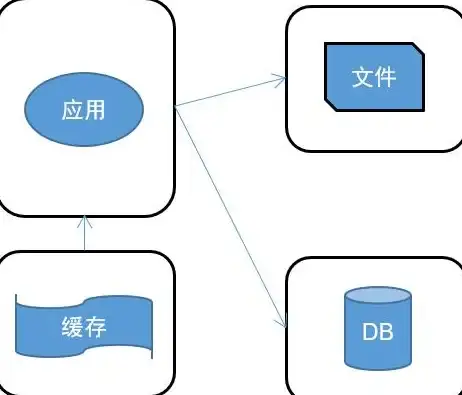

这已经是我们这个月第三次因为缓存更新不及时导致的线上事故了,作为一个电商平台的技术负责人,我深知在高并发场景下,缓存就是系统的"减震器",但动态数据(如库存、价格、用户余额)的实时更新一直是个棘手问题——更新太频繁影响性能,更新不及时又会导致数据不一致。

为什么动态数据缓存这么难?

动态数据不同于静态内容,它具有三个特点:

- 变化频率不可预测(可能一秒内变化几十次)

- 对一致性要求高(用户不能接受看到错误的库存或余额)

- 访问热点集中(80%请求集中在20%的热门商品)

传统的"先删缓存再更新数据库"策略在这种场景下会出现各种问题:

- 缓存击穿:热key失效瞬间大量请求直达数据库

- 数据不一致:并发更新时缓存与数据库不同步

- 缓存雪崩:批量过期导致系统瞬时过载

Redis实时更新四大实战方案

延迟双删策略(适合中等并发)

def update_product_info(product_id, new_data):

# 第一次删除缓存

redis.delete(f"product:{product_id}")

# 更新数据库

db.update("products", new_data, where={"id": product_id})

# 延迟500毫秒后再次删除(确保读请求期间的脏数据被清除)

time.sleep(0.5)

redis.delete(f"product:{product_id}")

适用场景:商品详情页更新、用户基础信息修改 优点:实现简单,能解决大部分并发问题 缺点:存在短暂不一致窗口,延迟时间需要根据业务调整

发布订阅模式(适合高频更新)

// 更新服务

public void updateStock(String productId, int delta) {

// 直接更新数据库

jdbcTemplate.update("UPDATE products SET stock=stock+? WHERE id=?", delta, productId);

// 发布变更消息

redisTemplate.convertAndSend("product:update", productId);

}

// 订阅服务

@RedisListener(topic = "product:update")

public void onProductUpdate(String productId) {

// 查询最新数据

Product product = productDao.findById(productId);

// 更新缓存

redisTemplate.opsForValue().set(

"product:" + productId,

product,

30, TimeUnit.MINUTES); // 设置合理过期时间

}

适用场景:秒杀库存、实时竞价系统 优点:解耦更新逻辑,保证最终一致性 缺点:系统复杂度增加,需要处理消息堆积问题

Binlog监听(适合强一致性要求)

func main() {

// 配置Canal客户端监听MySQL binlog

connector := canal.NewCanalConnector("canal-server:11111", "", "")

connector.Subscribe(".*\\..*") // 监听所有库表

for {

message := connector.Get(100, nil, nil)

for _, entry := range message.Entries {

if entry.Table == "products" {

// 解析变更事件

rowChange := parseRowChange(entry)

// 异步更新Redis

go updateRedisCache(rowChange)

}

}

}

}

func updateRedisCache(change RowChange) {

for _, row := range change.RowDatas {

productId := row.AfterColumns["id"].Value

redisClient.Set(ctx, "product:"+productId,

marshalProduct(row.AfterColumns),

time.Hour)

}

}

适用场景:金融账户余额、医疗系统关键数据 优点:数据一致性最强,对业务代码零侵入 缺点:架构复杂,延迟略高(通常在毫秒级)

多级缓存+本地标记(适合超高并发)

// 使用Node.js实现本地缓存标记

const localCache = new Map();

async function getProduct(productId) {

// 1. 检查本地标记

if (localCache.has(productId)) {

return localCache.get(productId);

}

// 2. 查询Redis缓存

let product = await redis.get(`product:${productId}`);

if (product) {

// 设置本地标记(短期缓存,比如5秒)

localCache.set(productId, product, 5000);

return product;

}

// 3. 查询数据库(加分布式锁防止击穿)

const lockKey = `lock:product:${productId}`;

if (await redis.setnx(lockKey, 1)) {

try {

product = await db.query('SELECT * FROM products WHERE id = ?', [productId]);

// 双写Redis(设置合理过期时间)

await redis.setex(`product:${productId}`, 3600, JSON.stringify(product));

localCache.set(productId, product, 5000);

} finally {

await redis.del(lockKey);

}

} else {

// 等待其他线程加载数据

await sleep(100);

return getProduct(productId); // 重试

}

return product;

}

适用场景:万人秒杀、热点新闻访问 优点:扛得住瞬时万级QPS 缺点:内存消耗大,本地缓存可能导致短时不一致

性能优化关键指标

在实施上述方案时,我们需要监控几个核心指标:

-

缓存命中率:保持在90%以上为佳

# Redis监控命令 redis-cli info stats | grep keyspace_hits redis-cli info stats | grep keyspace_misses

-

更新延迟:从数据库变更到缓存更新的时间差

// 可以在更新逻辑中加入时间戳记录 long start = System.currentTimeMillis(); updateCache(); long latency = System.currentTimeMillis() - start; metrics.record("cache.update.latency", latency); -

缓存穿透率:识别异常查询模式

-- 通过日志分析SQL查询特征 SELECT COUNT(*) FROM slow_query_log WHERE query LIKE '%SELECT * FROM products WHERE id =%' AND query_time > 1;

避坑指南:我们踩过的五个坑

-

过度依赖TTL过期:某个价值千万的促销活动,因为所有商品缓存设置了固定30分钟过期,导致活动开始时集体失效,数据库直接瘫痪。

解决方案:采用基础TTL(如1小时)+ 随机抖动(±10分钟)

-

大Value导致阻塞:某次把10MB的商品详情HTML片段存入Redis,导致网络传输和反序列化成为瓶颈。

解决方案:单个Value不超过1MB,大对象拆分为多个Key

-

热点Key单机瓶颈:某爆款商品缓存Key的QPS达到5万+/秒,单个Redis节点CPU跑满。

解决方案:采用Key分片(如product:{id}_{shard})+ 本地缓存

-

无底洞更新:用户画像系统对每个请求都更新缓存,结果90%的更新后来被覆盖。

解决方案:采用缓冲队列合并更新(如每5秒合并一次变更)

-

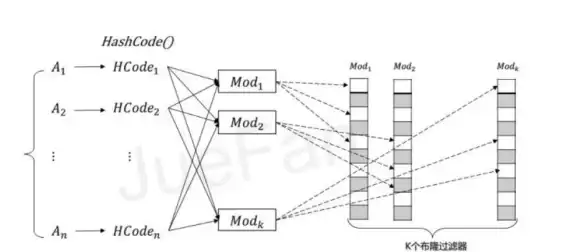

缓存污染:爬虫遍历不存在的ID,导致Redis被无效Key占满。

解决方案:布隆过滤器前置校验 + 空值缓存(设置较短TTL)

未来演进:我们在2025年的新实践

随着业务发展,我们又引入了两项新技术:

-

Redis模块化扩展:使用RedisGears实现更复杂的更新逻辑

# 注册一个在库存变更时自动更新缓存的处理器 redis.register_trigger( name="update_product_cache", on=['hset', 'hincrby'], key_prefix='inventory:', arg='__invalidate__', callback=function(client, data) local product_id = data.key:sub(11) client.call('del', 'product:'..product_id) end ) -

混合持久化缓存:热数据放Redis,温数据放KeyDB(兼容Redis协议的多线程版本),冷数据放Dragonfly(新兴的高性能缓存系统)

没有银弹,只有权衡

经过三年多的实践,我们总结出一个真理:缓存策略没有绝对的好坏,只有适合与否,对于金融核心系统,我们选择Binlog方案确保强一致性;对于内容推荐系统,我们采用发布订阅实现最终一致性;对于秒杀系统,多级缓存才是王道。

关键是要理解业务特征:你的数据变更频率如何?一致性要求多高?能容忍多少延迟?回答这些问题,才能找到最适合你的Redis动态更新方案。

本文由 勇珺 于2025-08-02发表在【云服务器提供商】,文中图片由(勇珺)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/519421.html

发表评论