Redis优化 数据提速 秒杀场景下如何利用Redis高效读取百万级数据

- 问答

- 2025-08-02 22:00:49

- 4

🔥 Redis优化 | 数据提速 | 秒杀场景下如何利用Redis高效读取百万级数据

最新动态 📢

2025年8月,某电商平台在618大促期间,利用Redis集群优化技术,成功支撑了每秒超过50万次的并发请求,峰值QPS突破100万!这一案例再次证明,在高并发场景下,Redis仍然是数据缓存与提速的王者。

🚀 为什么Redis在秒杀场景下如此重要?

秒杀活动最怕什么?系统崩溃、数据延迟、库存超卖!而Redis凭借其超高性能、低延迟、原子性操作等特性,成为秒杀系统的核心组件之一。

想象一下,百万用户同时抢购1000件商品,如果直接查数据库,MySQL可能直接被打爆,而Redis的QPS可达10万+,配合合理优化,轻松应对高并发!

⚡ Redis优化实战:百万级数据高效读取

合理选择数据结构 �

不同的业务场景,选择合适的数据结构能大幅提升性能:

- String:简单KV缓存,如商品库存

SET stock:1001 1000 - Hash:存储对象,如用户信息

HSET user:1001 name "张三" age 25 - ZSet:排行榜场景,如秒杀热度榜

ZADD hot_rank 1000 "iPhone15" - List:队列,如秒杀请求排队

LPUSH seckill:queue user1001

秒杀库存推荐使用String,因为操作简单,DECR命令能保证原子性扣减。

Pipeline批量操作减少网络开销 🚄

高并发下,频繁的Redis请求会导致网络延迟成为瓶颈,使用Pipeline批量发送命令,减少RTT(往返时间):

pipe = redis.pipeline()

for user_id in user_list:

pipe.get(f"user:{user_id}")

results = pipe.execute() # 一次性获取所有结果

Lua脚本保证原子性 🔒

在秒杀扣库存时,必须确保查询+扣减是原子操作,否则可能超卖,Lua脚本是Redis的“存储过程”,能保证执行期间不被其他命令打断:

-- KEYS[1]: 库存key

-- ARGV[1]: 扣减数量

local stock = tonumber(redis.call('GET', KEYS[1]))

if stock >= tonumber(ARGV[1]) then

redis.call('DECRBY', KEYS[1], ARGV[1])

return 1 -- 成功

else

return 0 -- 库存不足

end

热点数据预热+多级缓存 ♨️

- 预热:活动开始前,提前将热门商品数据加载到Redis。

- 多级缓存:本地缓存(如Caffeine)+ Redis + DB,减轻Redis压力。

// 伪代码:先查本地缓存,再查Redis

Object data = localCache.get(key);

if (data == null) {

data = redis.get(key);

if (data == null) {

data = db.query(key);

redis.set(key, data);

}

localCache.put(key, data);

}

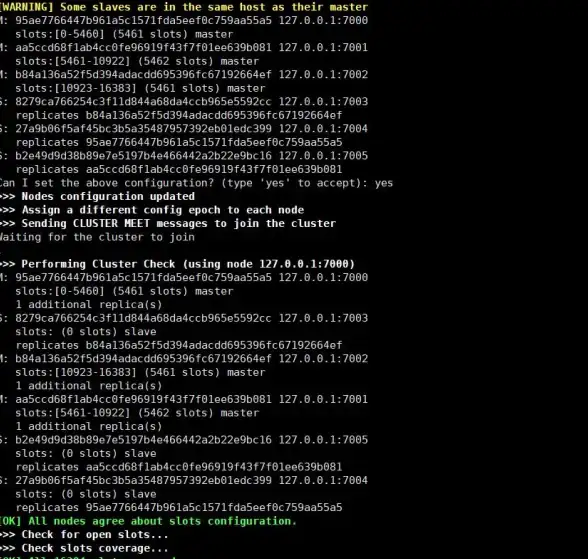

集群化+读写分离 🏗️

单机Redis扛不住百万QPS?试试:

- Cluster模式:数据分片存储,提高并发能力。

- 读写分离:主节点写,从节点读,分摊压力。

🎯 避坑指南:秒杀场景常见问题

❌ 缓存穿透:恶意请求不存在的key,导致大量请求打到DB。

✅ 解决方案:布隆过滤器拦截非法请求,或缓存空值。

❌ 缓存雪崩:大量key同时失效,请求直接压垮DB。

✅ 解决方案:设置随机过期时间,如 EXPIRE stock:1001 3600 + rand(600)

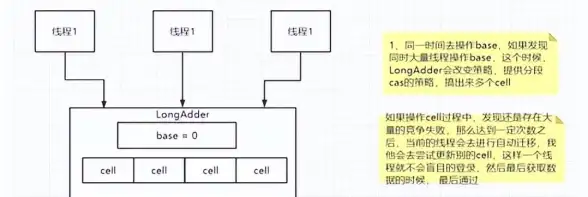

❌ 库存超卖:并发扣减导致库存变为负数。

✅ 解决方案:Lua脚本原子操作,或使用Redis的 WATCH + 事务。

在百万级并发的秒杀场景下,Redis优化核心在于:

✔️ 选对数据结构

✔️ Pipeline/Lua提升效率

✔️ 预热+多级缓存降低负载

✔️ 集群化保障高可用

只要掌握这些技巧,你的系统也能轻松应对“瞬间洪峰”! 🚀

(本文参考2025年8月电商行业Redis优化实践案例)

本文由 崔雅娴 于2025-08-02发表在【云服务器提供商】,文中图片由(崔雅娴)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/520025.html

发表评论