缓存优化|数据分析|Redis热点数据识别与挖掘革新方法

- 问答

- 2025-08-03 00:25:45

- 4

Redis热点数据识别:让缓存不再"冷场"的实战秘籍

当服务器开始"咳嗽":一个真实的性能危机

2025年8月的一个周五下午,某电商平台的运维总监李明盯着监控大屏上不断跳动的红色警报,额头渗出了细密的汗珠,大促预热活动刚开始半小时,核心商品接口的响应时间已经从50ms飙升到800ms,数据库CPU使用率突破90%,整个技术团队如临大敌。

"明明我们已经加了Redis缓存,为什么还会这样?"李明百思不得其解,直到他们使用新的热点数据识别工具分析后才发现:80%的请求竟然集中在全站0.1%的商品数据上,而这些"明星商品"因为未被识别为热点,仍然走的是常规缓存策略。

这个真实场景揭示了现代互联网系统中的一个关键挑战:在数据爆炸的时代,如何精准识别并优化那1%真正影响性能的热点数据?

热点数据:缓存世界的"二八定律"

所谓热点数据,就是那些被高频访问的数据项,它们通常遵循"二八定律"——20%的数据承载着80%的访问流量,但在实际生产环境中,这个比例往往更加极端,可能是1%的数据承载99%的流量。

传统缓存策略的盲点在于,它们通常采用均匀分布的假设,比如LRU(最近最少使用)算法,这种"民主平等"的缓存管理方式,在面对极端倾斜的访问模式时就会捉襟见肘,就像在演唱会现场,如果所有观众都获得相同的服务资源,那么最前排的狂热粉丝和后排的普通观众就会被同等对待,结果必然是前排体验不佳,后排资源浪费。

Redis热点识别的"三代进化史"

第一代:事后诸葛亮的监控分析

早期的方法依赖离线分析Redis的监控日志,通过统计各个key的访问频率来识别热点,这种方法就像医生通过查看病人昨天的体温记录来诊断当前病情——信息滞后,无法实时应对突发流量。

第二代:抽样与近似算法

为了降低性能开销,第二代方法采用了抽样技术,比如Redis自带的redis-cli --hotkeys命令,它就像在体育馆里随机采访几位观众来推测全场观众的偏好,虽然快速但不够精确,容易遗漏真正的热点。

第三代:实时精准识别的革新方法

我们有了更智能的工具和方法,以下是2025年最前沿的几种热点识别技术:

- 自适应滑动窗口计数器 这种方法为每个key维护一个时间衰减的访问计数器,最近访问的权重更高,通过动态调整窗口大小,可以同时捕捉突发热点和持久热点,实现起来类似这样:

def record_access(key):

now = time.time()

if key not in counters:

counters[key] = {'value': 0, 'last_update': now}

# 时间衰减计算

elapsed = now - counters[key]['last_update']

counters[key]['value'] *= (0.9 ** elapsed) # 衰减因子

counters[key]['value'] += 1 # 新增访问

counters[key]['last_update'] = now

-

机器学习预测模型 使用轻量级机器学习模型(如小规模的神经网络或决策树)分析访问模式的时间序列特征,预测哪些key可能成为热点,这种方法可以提前做好准备,防患于未然。

-

分布式一致性热点识别 在Redis集群环境下,使用Gossip协议或一致性哈希来汇总各个节点的访问统计,形成全局热点视图,这解决了单节点视角局限性的问题。

实战:构建你的热点数据雷达

让我们用一个完整的Python示例,实现一个简易但实用的热点识别系统:

import time

from collections import defaultdict

import heapq

class HotspotDetector:

def __init__(self, capacity=100, decay_factor=0.95, threshold=10):

self.capacity = capacity # 跟踪的key数量上限

self.decay_factor = decay_factor # 衰减系数

self.threshold = threshold # 热点阈值

self.counters = defaultdict(lambda: {'value': 0, 'last_update': time.time()})

self.heap = [] # 用于维护top K的堆

def record_access(self, key):

now = time.time()

entry = self.counters[key]

# 应用时间衰减

elapsed = now - entry['last_update']

entry['value'] *= (self.decay_factor ** elapsed)

entry['value'] += 1 # 当前访问

entry['last_update'] = now

# 维护堆结构

if len(self.heap) < self.capacity:

heapq.heappush(self.heap, (entry['value'], key))

else:

heapq.heappushpop(self.heap, (entry['value'], key))

def get_hotspots(self):

# 返回达到阈值的hot keys

return [key for key in self.counters

if self.counters[key]['value'] >= self.threshold]

def get_top_k(self, k):

# 返回访问量top k的keys

return heapq.nlargest(k, self.heap, key=lambda x: x[0])

这个实现包含了热点识别的几个关键要素:

- 时间衰减:更重视近期访问

- 空间效率:只跟踪有限数量的key

- 实时查询:随时获取当前热点

热点数据的"五星级服务"策略

识别出热点只是第一步,更重要的是如何给这些VIP数据提供特殊待遇:

-

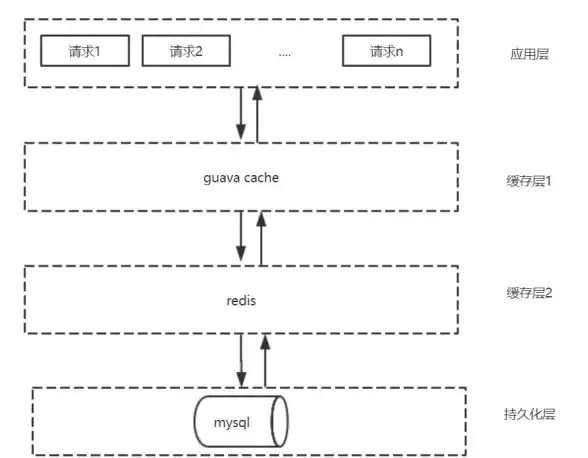

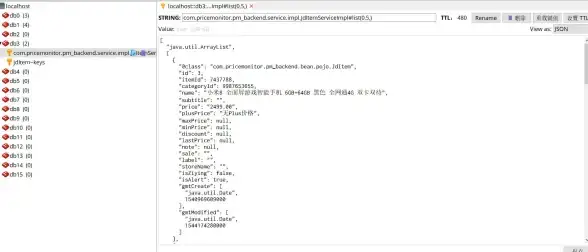

多级缓存策略 对热点数据实施"本地缓存+Redis集群+持久层"的多级缓存,比如使用Caffeine作为应用本地缓存,将热点数据的TTL设置得更长。

-

预加载与预热 在预测到某些数据可能成为热点时(如即将开始的秒杀商品),提前加载到缓存中,这就像在餐厅预期客流高峰前,先准备好招牌菜的半成品。

-

动态分片 对超级热点(如顶流明星的微博)进行数据分片,将压力分散到多个Redis节点,这相当于为超级明星安排多个专属通道,避免单一通道拥挤。

-

熔断降级 为热点数据接口设置特殊的熔断策略,当访问量超过阈值时,返回精简版数据或启用排队机制。

避坑指南:热点数据处理的常见误区

在实施热点数据优化时,有几个容易掉入的陷阱:

-

过度优化 不是所有热点都需要特殊处理,只有那些真正影响系统性能的热点才值得关注,优化前先确认瓶颈所在。

-

静态配置 热点会随时间变化,特别是在内容推荐系统中,配置需要能够自适应调整,而不是写死在配置文件中。

-

忽略冷启动 新上线商品或内容没有历史数据,传统方法难以识别其潜在热度,需要结合内容特征进行预测。

-

数据一致性 对热点数据的特殊缓存策略可能增加一致性维护的复杂度,需要权衡性能与一致性的需求。

当热点遇见AI

到2025年,热点数据识别技术正朝着更智能的方向发展:

- 强化学习动态调整:系统能够根据实时反馈自动调整热点识别参数,无需人工干预

- 跨系统协同优化:CDN、负载均衡、数据库与缓存层共享热点信息,形成端到端的优化

- 边缘计算集成:在靠近用户的位置处理热点数据,减少网络跳跃

- 量子计算应用:对于超大规模数据集,量子算法可能提供更高效的热点识别能力

让缓存真正"热"起来

回到开头的故事,李明团队在应用了新的热点识别方法后,不仅解决了当天的危机,还将系统峰值承载能力提升了8倍,关键在于他们不再把缓存视为静态资源,而是动态识别并优先服务那些真正重要的数据。

在数据驱动的时代,缓存优化已经从"有没有"的问题,转变为"准不准"的挑战,通过智能化的热点数据识别与处理,我们能够让每一份缓存资源都用在刀刃上,创造出既高效又经济的系统架构。

好的缓存策略不是平均主义,而是应该像聪明的管家一样,知道在什么时候给谁提供VIP服务。

本文由 素溥 于2025-08-03发表在【云服务器提供商】,文中图片由(素溥)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/520987.html

发表评论