上一篇

Kubernetes 通信机制 详解kubernetes各组件之间的通信方式与实现原理

- 问答

- 2025-08-03 06:10:49

- 6

Kubernetes通信机制:揭秘集群组件间的对话艺术

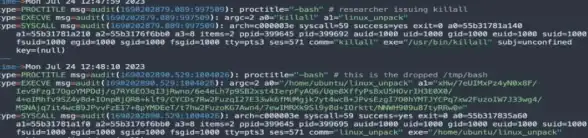

场景引入:凌晨三点,你的手机突然响起告警——某个生产服务Pod频繁重启,当你连入集群排查时,kube-controller-manager正在通过etcd获取节点状态,kubelet在向API Server汇报容器指标,而kube-proxy默默更新着iptables规则,这些组件如何像精密钟表般协同工作?今天我们就拆解Kubernetes内部的通信密码。

核心通信矩阵:谁在和谁对话?

Kubernetes的通信网络可以概括为三类关键路径:

- 控制平面内部:API Server、etcd、scheduler等组件的"高管会议"

- 控制面与数据面:API Server与kubelet、kube-proxy的"上下级沟通"

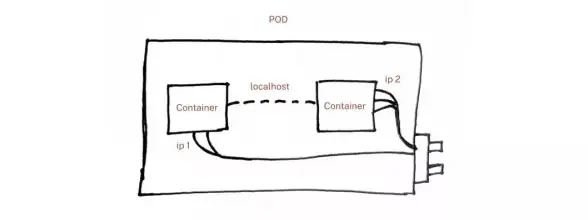

- 工作负载之间:Pod与Service的"平民社交"

(数据来源:CNCF 2025年集群网络调查报告)

通信协议与传输层

API Server:集群的通信枢纽

作为唯一的带状态组件,API Server采用分层架构处理请求:

- 认证层:Bearer Token、X509证书等

- 限流层:采用令牌桶算法(默认QPS=200,突发=400)

- 准入控制:Webhook调用如

ValidatingAdmissionWebhook

# 查看API Server支持的通信协议

kubectl get --raw=/ | jq '.paths[] | select(contains("v1"))'

etcd:键值存储的gRPC通道

所有集群数据通过gRPC协议存储,关键特性:

- 使用lease机制保持心跳(默认2秒续期)

- 写操作必须通过Raft共识(典型延迟<50ms)

- 监控重点:

etcd_wal_fsync_duration_seconds指标

组件级通信详解

Controller Manager的监听机制

通过Informer机制监听API Server:

informer := cache.NewSharedIndexInformer(

&cache.ListWatch{

ListFunc: listFunc,

WatchFunc: watchFunc,

},

&v1.Pod{},

resyncPeriod,

cache.Indexers{},

)

- 采用List-Watch模式避免轮询

- 本地维护Delta FIFO队列减少API压力

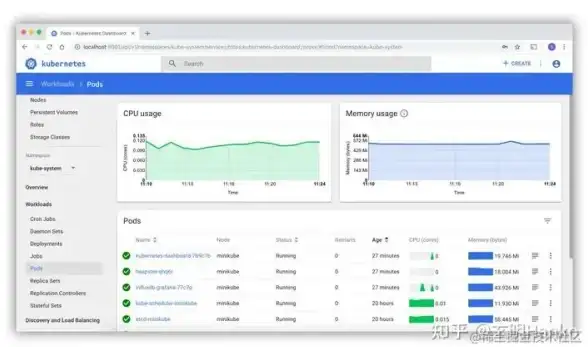

Kubelet的汇报流程

每10秒(可配置)通过以下通道上报:

- NodeStatus:CPU/内存等资源(通过API Server的

/api/v1/nodes/<node-name>/status) - CRI运行时:容器状态通过gRPC调用(如containerd的

runtime.v1alpha2服务)

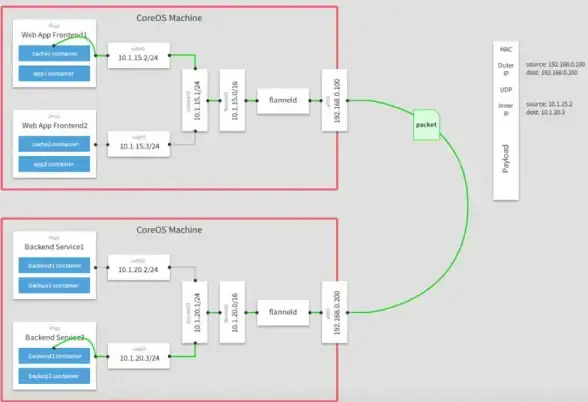

Kube-Proxy的规则同步

根据--proxy-mode选择不同实现:

- iptables模式:通过

nf_conntrack模块跟踪连接 - IPVS模式:使用内核的L4负载均衡器

- eBPF模式:内核态直接处理包转发(性能提升40%+)

安全通信实践

证书体系详解

certificate_hierarchy:

CA

├── API Server

├── etcd

└── kubelet

└── pod-bound-service-account

- kubelet需要

--rotate-certificates开启自动轮换 - ServiceAccount令牌默认1小时有效期(v1.29+)

网络策略实战

限制前端Pod只能与Redis通信:

kind: NetworkPolicy

spec:

ingress:

- from:

- podSelector:

matchLabels: { role: frontend }

ports:

- protocol: TCP

port: 6379

性能优化指南

-

API Server调优:

- 增加

--max-requests-inflight(建议值:800-1200) - 启用

--enable-priority-and-fairness避免饥饿

- 增加

-

etcd维护技巧:

# 压缩历史版本(保留2小时数据) etcdctl compact $(date -d "2 hours ago" +%s) # 定期整理碎片 etcdctl defrag

-

节点级优化:

- 将kubelet的

--node-status-update-frequency调整为20s(平衡精度与负载) - 为kube-proxy启用

--conntrack-max-per-core=32768

- 将kubelet的

本文由 诸勋 于2025-08-03发表在【云服务器提供商】,文中图片由(诸勋)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/523192.html

发表评论