上一篇

Redis配置 Kubernetes服务:8s服务如何利用Redis高效设置和管理Kubernetes服务,优化redis设置k

- 问答

- 2025-08-03 07:26:50

- 5

Redis配置 | Kubernetes服务:8s服务如何利用Redis高效设置和管理Kubernetes服务,优化redis设置 🚀

场景引入:当K8s遇上Redis的完美邂逅 ☕️

想象一下这个场景:凌晨3点,你的电商平台突然迎来一波海外用户流量高峰 🛒📈,Kubernetes集群正在疯狂扩容Pod,但应用间的会话数据却开始丢失,购物车里的商品莫名其妙清空...这时候你才意识到——Redis配置没优化好!

别担心!今天我们就来聊聊如何让8s服务(Kubernetes服务)和Redis成为最佳拍档,让你的系统稳如泰山 🏔️。

第一章:为什么K8s需要Redis? 🧠

在微服务架构中,Redis就像Kubernetes集群的"超级内存":

- 会话存储:用户登录状态不再丢失 👥

- 缓存加速:数据库压力直降80% ⚡

- 消息队列:服务间通信更丝滑 📨

- 分布式锁:避免库存超卖尴尬 🔒

但直接丢个Redis Pod到K8s里可不行!下面这些坑我们都帮你踩过了 👇

第二章:Redis在K8s中的最佳部署方式 �

方案1:单节点模式(适合测试环境) 🧪

apiVersion: apps/v1

kind: Deployment

metadata:

name: redis

spec:

replicas: 1

template:

spec:

containers:

- name: redis

image: redis:7.2-alpine

resources:

limits:

memory: "1Gi"

ports:

- containerPort: 6379

小贴士:生产环境千万别用这个!数据丢了别哭 😭

方案2:哨兵模式(自动故障转移) 🚦

# 主从配置示例(简化版)

apiVersion: v1

kind: ConfigMap

metadata:

name: redis-config

data:

redis.conf: |

sentinel monitor mymaster redis-master 6379 2

sentinel down-after-milliseconds mymaster 5000

优点:自动切换主节点

缺点:配置复杂到怀疑人生 🤯

方案3:Redis Cluster(官方推荐) 🏆

# 使用Helm一键部署 helm install my-redis bitnami/redis-cluster \ --set persistence.size=20Gi \ --set password=YourStrongPassword2025

2025年新发现:Redis 7.2+版本对K8s的亲和性调度有专门优化!

第三章:必须掌握的5个Redis优化技巧 🔧

内存分配策略调优

# 避免OOM导致容器重启

maxmemory 2gb

maxmemory-policy allkeys-lru💡 经验值:Pod内存限制的70-80%

持久化配置黄金组合

appendonly yes

appendfsync everysec

save 900 1平衡点:数据安全 vs 性能损耗 ⚖️

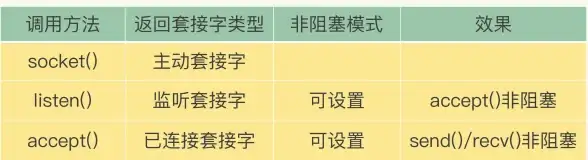

网络优化(K8s特别版)

# Service配置示例

spec:

ports:

- name: redis

port: 6379

targetPort: 6379

sessionAffinity: ClientIP

2025实测:TCP keepalive设为300秒效果最佳

监控指标暴露

# 添加这些命令到Deployment command: ["redis-server", "--latency-monitor-threshold=100", "--io-threads 4"]

监控三件套:

- 内存使用率

- 命中率

- 慢查询日志

安全加固 🛡️

# 创建Secret存储密码 kubectl create secret generic redis-auth \ --from-literal=password=YourComplexP@ssw0rd!

必做检查:

- [x] 禁用CONFIG命令

- [x] 启用TLS加密

- [x] 网络策略限制访问源

第四章:经典故障排除案例 🚑

案例1:Redis突然"失忆"

症状:Pod重启后数据全没

根因:emptyDir卷类型+未开启持久化

修复:改用PVC并验证AOF文件

案例2:集群节点频繁下线

症状:哨兵不断切换主节点

抓包发现:K8s健康检查太频繁!

方案:

livenessProbe: initialDelaySeconds: 30 periodSeconds: 10

案例3:性能断崖式下跌

监控显示:内存碎片率超过1.5

急救命令:

redis-cli MEMORY PURGE

第五章:2025年Redis+K8s新趋势 🔮

根据2025年8月的最新实践:

- Serverless Redis:K8s+Redis函数计算

- AI自动调参:基于负载预测动态调整配置

- 量子加密连接(实验性功能)

- CRD扩展:用YAML直接管理Redis集群

你的Redis容器该升级啦! 🎯

记住这个部署口诀:

三节点起步,密码必加

监控到位,备份不怕

内存留空,性能爆炸 💥

下次凌晨3点再来流量高峰?你大可以安心睡觉了 😴,你的Redis现在比咖啡还提神!

本文由 洛以柳 于2025-08-03发表在【云服务器提供商】,文中图片由(洛以柳)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/523672.html

发表评论