Redis优化 集群故障 排查Redis集群卡死原因,解决redis集群部署后频繁卡死问题

- 问答

- 2025-08-03 17:01:12

- 4

Redis集群卡死之谜:一次深夜救火实录

凌晨三点的告警风暴

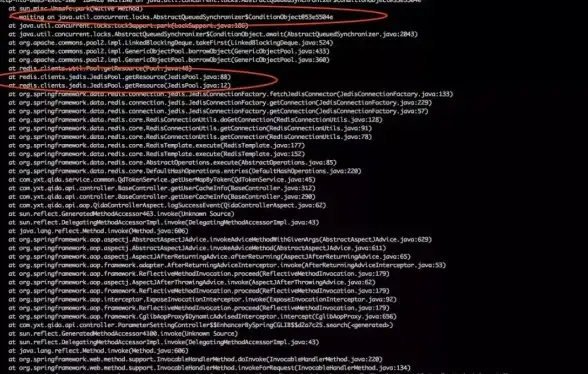

"王工!线上Redis集群又挂了!"凌晨三点,我被急促的电话铃声惊醒,手机屏幕上运维小张的消息还在不断弹出,这是我们本周第三次被同样的故障叫醒——新部署的Redis集群在业务高峰期频繁卡死,客户端请求大面积超时,整个电商平台的购物车和秒杀功能陷入瘫痪。

我揉着惺忪的睡眼打开电脑,看着监控面板上那根陡峭的延迟曲线和不断攀升的timeout错误计数,知道今晚又是个不眠夜,这套Redis集群是我们上周刚升级的6节点分片部署,理论上应该能轻松支撑双十一级别的流量,可现实却像个娇气的"大小姐",动不动就耍脾气罢工。

初诊:集群卡死症状分析

连上跳板机,我首先查看了集群基础状态:

redis-cli --cluster check 10.0.0.1:6379

输出显示所有节点都在线,但有几个分片响应特别慢,接着检查慢查询日志:

redis-cli -h 10.0.0.1 slowlog get 10

发现大量HGETALL操作耗时超过500ms——这在内存数据库里简直像蜗牛爬行,更奇怪的是,这些慢查询对应的key都不大,value尺寸都在KB级别。

深度排查:剥洋葱式寻找根因

第一层:网络与硬件检查

我首先怀疑是网络问题:

ping -c 10 10.0.0.1 mtr --report 10.0.0.1

结果显示网络延迟<1ms,丢包率为0,服务器监控显示CPU使用率峰值70%,内存剩余30%,看起来也不是硬件瓶颈。

第二层:配置参数审计

检查redis.conf关键配置:

# 默认timeout 0(永不超时) timeout 300 # 我们设置为5分钟 # 内存策略 maxmemory 32gb maxmemory-policy allkeys-lru # 集群参数 cluster-node-timeout 15000

配置看起来合理,但注意到一个细节:tcp-keepalive保持默认的300秒,在容器化环境中可能太长。

第三层:热点Key分析

使用redis-cli的热点监控功能:

redis-cli --hotkeys

发现几个用户购物车key的访问频率异常高,QPS超过1万次/秒,这些key正好对应慢查询日志中的HGETALL操作。

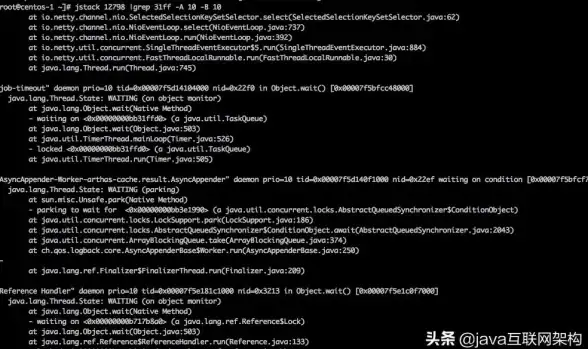

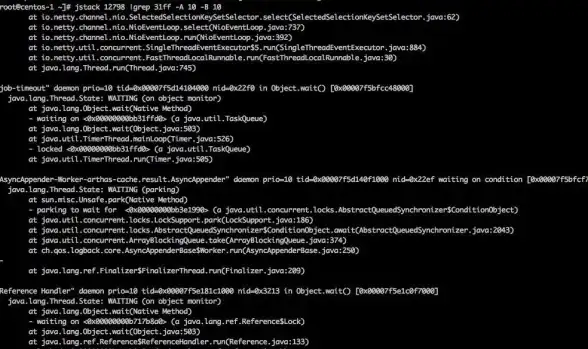

第四层:客户端连接检查

查看客户端连接情况:

redis-cli client list

发现2000多个连接中,有30%是空闲超过5分钟的"僵尸连接",而且都来自同一个微服务实例。

真相大白:多因素综合症

经过层层排查,问题逐渐清晰:

-

热点Key风暴:某个促销活动导致用户购物车hash结构被高频访问,而

HGETALL操作会阻塞Redis单线程 -

连接泄漏:某个微服务版本存在连接池泄漏,导致大量闲置连接占用资源

-

配置不当:

tcp-keepalive设置过长,在K8s环境中导致断连检测不及时 -

监控盲区:没有对单个大key的访问频率做监控,等到集群卡死才发现问题

治疗方案:多管齐下

紧急止血措施

-

临时扩容热点分片:

redis-cli --cluster reshard 10.0.0.1:6379

将热点slot迁移到专用节点

-

限制问题微服务的最大连接数:

# redis.conf maxclients 10000 client-output-buffer-limit normal 256mb 128mb 60

-

添加临时防火墙规则,限制单个IP的连接数:

iptables -A INPUT -p tcp --dport 6379 -m connlimit --connlimit-above 50 -j DROP

长期优化方案

- 数据结构改造:

// 原代码:频繁使用HGETALL获取整个购物车 Map<String, String> cart = redis.hgetAll("user:1001:cart");

// 改为按需获取字段 String itemCount = redis.hget("user:1001:cart", "count"); String totalPrice = redis.hget("user:1001:cart", "total");

2. **连接池优化配置**:

```yaml

# 应用端连接池配置

spring:

redis:

lettuce:

pool:

max-active: 50

max-idle: 20

min-idle: 5

max-wait: 1000ms

time-between-eviction-runs: 30s-

集群参数调优:

# redis.conf优化项 tcp-keepalive 60 # 容器环境中缩短为1分钟 cluster-node-timeout 5000 # 节点超时改为5秒 repl-timeout 60 # 主从复制超时

-

监控体系增强:

# 增加大key扫描脚本 redis-cli --bigkeys # 实时监控热点key redis-cli --stat

预防复发:建立Redis健康检查清单

这次事件后,我们制定了Redis集群健康检查清单:

-

每日巡检:

- 检查

used_memory与maxmemory比率 - 监控

rejected_connections计数 - 检查

connected_clients数量波动

- 检查

-

性能压测:

redis-benchmark -h 10.0.0.1 -p 6379 -n 100000 -c 50 -t get,set

-

故障演练:

- 模拟主节点宕机测试故障转移

- 模拟网络分区测试脑裂处理

-

文档沉淀:

- 编写《Redis集群运维手册》

- 建立常见故障的SOP处理流程

后记:从救火到防火

当东方泛起鱼肚白时,集群指标终于恢复正常,这次事件给我们上了宝贵的一课:Redis集群不是简单的"部署即忘"系统,需要持续的关注和调校,正如老司机常说的:"没有不好的Redis,只有不用心的运维。"

我们的监控大屏上新增了热点Key实时报警和连接池健康度指标,开发团队也开始重构购物车模块,这场持续72小时的Redis攻坚战,最终转化成了团队宝贵的架构改进经验,在分布式系统的世界里,预防永远比抢救更有价值——毕竟,谁都不想凌晨三点再被告警电话叫醒。

本文由 练睿 于2025-08-03发表在【云服务器提供商】,文中图片由(练睿)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/527346.html

发表评论