Kafka Zookeeper Kafka在Zookeeper中的数据结构一图全解

- 问答

- 2025-08-03 21:01:32

- 3

🚀 Kafka | Zookeeper | Kafka在Zookeeper中的数据结构一图全解

📢 最新动态(2025年8月)

Apache Kafka社区近期宣布将逐步减少对Zookeeper的依赖,Kafka 4.0版本预计在2026年推出完全去Zookeeper化的"Kafka Raft Metadata"模式,但现阶段,Zookeeper仍是Kafka集群元数据管理的核心组件,理解它们的协作机制至关重要!

🔍 为什么Kafka需要Zookeeper?

想象一下,Kafka是个高速运转的快递公司📦,而Zookeeper就是它的"调度中心"🗂️:

- 经纪人管理:记录哪些Broker活着(像快递网点营业状态)

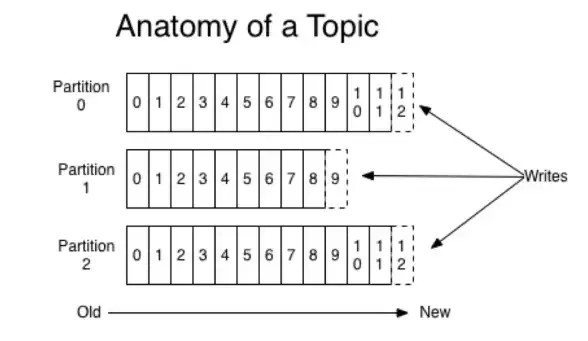

- 主题分区分配:保存Topic/Partition的Leader是谁(像记录包裹该由哪个网点发货)

- 配置中心:存储ACL、配额等配置(像快递公司的运输规则手册)

💡 有趣冷知识:早期Kafka用Zookeeper存储消息偏移量,后来才移到内部Topic

__consumer_offsets

🗂️ Kafka在Zookeeper中的数据结构全图解

用树形结构表示Zookeeper的znode布局(建议收藏⭐):

/

├── /cluster

│ └── id # 集群唯一ID(Kafka 2.1+)

├── /brokers

│ ├── ids/[0-N] # 在线Broker列表,每个节点含JSON元数据

│ ├── topics/[topic_name] # 每个Topic的分区分配方案

│ └── seqid # 全局序列号(防止脑裂)

├── /config

│ ├── topics/[topic_name] # Topic级别配置

│ └── clients # 客户端配额配置

├── /admin

│ ├── delete_topics # 待删除Topic列表

│ └── preferred_replica_election # 优先副本选举请求

└── /consumers (旧版消费者API使用)

├── [group_id]

│ ├── owners/[topic]/[partition] # 分区消费关系

│ └── offsets/[topic]/[partition] # 消费偏移量(已废弃)� 关键节点深度解析

1️⃣ /brokers/ids/[0-N]

每个Broker启动时在此注册临时节点,内容示例:

{

"listener_security_protocol_map":{"PLAINTEXT":"PLAINTEXT"},

"endpoints":["PLAINTEXT://broker1:9092"],

"jmx_port":9999,

"host":"broker1",

"version":"5",

"port":9092,

"timestamp":"1651234567890"

}

⚠️ 节点是临时节点(ephemeral),Broker宕机自动消失

2️⃣ /brokers/topics/[topic_name]

记录分区分配方案,例如3分区2副本的Topic:

{

"version":1,

"partitions":{"0":[1,2], "1":[2,3], "2":[3,1]}

}

数字代表Broker ID,"0":[1,2]表示分区0的Leader是Broker1,副本在Broker1和2

3️⃣ /controller

Kafka集群最重要的znode 🏆

- 存储当前Controller Broker的ID(如

{"version":1,"brokerid":1}) - 通过抢占式创建实现Controller选举

- 节点变化会触发Controller切换事件

💥 常见问题Q&A

Q:为什么我删了Topic但Zookeeper里还有残留?

A:检查/admin/delete_topics是否已清除,并确认delete.topic.enable=true

Q:Controller频繁切换怎么办?

A:可能是Zookeeper会话超时,调整:

# Kafka端 zookeeper.session.timeout.ms=18000 # Zookeeper端 tickTime=2000 initLimit=5 syncLimit=2

Q:能手动修改Zookeeper数据吗?

A:🛑 绝对禁止!可能导致集群状态不一致,紧急情况请用kafka-topics.sh等官方工具

🎯 最佳实践建议

- 监控关键znode:特别是

/brokers/ids和/controller - 版本对齐:确保Kafka与Zookeeper版本兼容(如Kafka 3.x配Zookeeper 3.6+)

- 备份配置:定期导出

/config下重要配置 - 隔离部署:Zookeeper集群独立于Kafka Broker,避免资源竞争

虽然Kafka未来将摆脱Zookeeper,但当前生产环境仍需掌握:

- Zookeeper是Kafka的"大脑"🧠,存储所有关键元数据

- 理解znode结构能快速定位集群问题🔧

- 官方工具 > 手动操作,避免直接修改Zookeeper数据

(附:手绘示意图建议用不同颜色区分永久/临时节点,并标注Watch监控点)

需要更详细的某个模块解析?评论区告诉作者 👇

本文由 漆雕清心 于2025-08-03发表在【云服务器提供商】,文中图片由(漆雕清心)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/528896.html

发表评论