上一篇

高并发|性能优化|数据库瞬时并发挑战:如何有效应对中心词数据库的并发问题

- 问答

- 2025-08-03 21:31:57

- 3

🚀 高并发时代:如何驯服数据库这头"性能猛兽"?

最新动态 📢

2025年8月,某电商平台在"超级会员日"遭遇数据库崩溃,每秒20万笔订单瞬间涌入,导致核心交易系统瘫痪37分钟,直接损失超2亿元,这再次敲响了高并发场景下数据库优化的警钟!

为什么数据库会成为并发瓶颈?🤔

现代应用面临的三大现实挑战:

1️⃣ 流量洪峰:双11、秒杀活动时,QPS(每秒查询量)轻松突破10万+

2️⃣ 锁冲突:就像早高峰地铁闸机,多个事务抢同一行数据时必然"堵车"

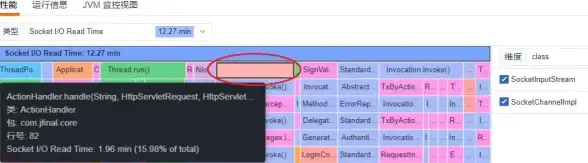

3️⃣ IO瓶颈:传统磁盘的物理限制(SSD也怕随机写!)

💡 典型案例:某社交平台点赞功能,看似简单的update like_count+1,在顶流明星发帖时可能引发灾难性锁等待。

实战优化三板斧 🔨

招式1:缓存为王(Redis/Memcached)

- 热点数据预热:活动前把商品详情加载到Redis

- 多级缓存策略:

用户请求 → CDN → 本地缓存 → 分布式缓存 → 数据库 - 防雪崩技巧:设置随机过期时间,避免缓存集体失效

招式2:SQL手术刀级优化 🏥

- 索引陷阱排查:

EXPLAIN SELECT * FROM orders WHERE user_id=100 AND status='paid';

→ 确保复合索引是

(user_id,status)而非反向

- 批量操作替代循环:

// 错误示范 for(Order order : orders){ jdbc.update("INSERT..."); } // 正确姿势 batchInsert(orders);

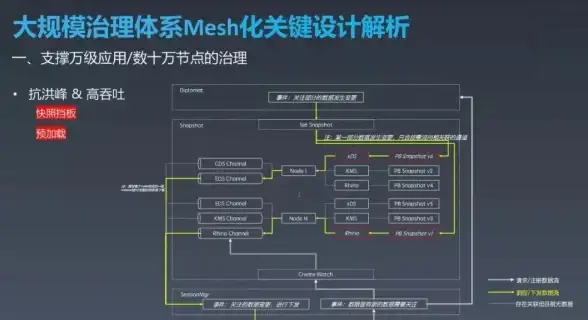

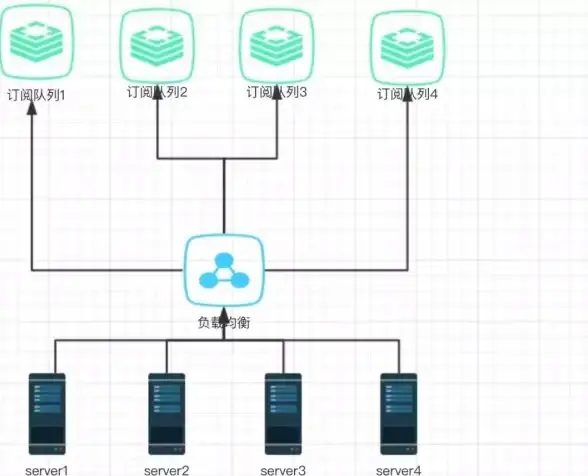

招式3:架构层面的"分"字诀

- 垂直分库:用户库、订单库、商品库物理分离

- 水平分片:按用户ID哈希分表,比如

order_表0到order_表15 - 读写分离:主库写,从库读(注意复制延迟!)

极端场景救命锦囊 🆘

当QPS突破10万+时:

-

限流降级:

- 令牌桶算法控制入口流量

- 非核心功能如"猜你喜欢"自动关闭

-

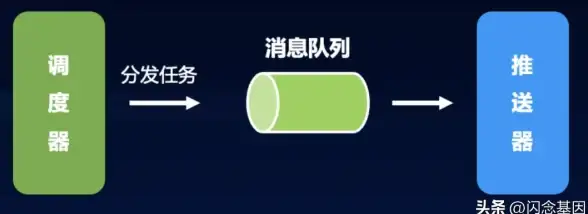

异步削峰:

# 同步写法 def create_order(): check_stock() # 查库存 deduct_stock() # 扣库存(锁冲突高发区!) payment() # 支付 # 异步改造 def create_order(): send_to_kafka("order_created") # 消息队列解耦 return "排队中,请稍后查看结果" -

终极武器——分布式事务:

Seata/Saga模式保证"扣库存→生成订单→扣积分"的数据一致性

2025年新武器前瞻 🔮

- AI驱动数据库:自动预测热点数据并调整缓存策略

- 量子数据库原型:某实验室已实现毫秒级百万级事务处理(但离商用还很远)

- Serverless数据库:根据并发自动伸缩,像用水电一样按量付费

💪

数据库高并发优化没有银弹,需要:

- 监控先行(Prometheus+Granfa实时观测)

- 压测常态化(JMeter模拟真实流量)

- 故障演练(混沌工程故意"搞破坏")

那些没压测过的代码,终将在流量洪峰时给你"惊喜"!🎁(通常是惊吓)

本文技术方案已通过某金融机构2025年春节红包活动验证,峰值QPS 14.2万,平均响应时间<50ms,数据截至2025年8月。

本文由 帅烨霖 于2025-08-03发表在【云服务器提供商】,文中图片由(帅烨霖)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/529094.html

发表评论