上一篇

数据传输|高效提取 数据的技巧:如何高效地从服务器传输大量数据库数据,实用方法总结

- 问答

- 2025-08-03 21:33:15

- 5

如何从服务器高效提取海量数据

场景引入:

凌晨3点,你盯着屏幕上缓慢蠕动的进度条——"已传输12GB/350GB,剩余时间:6小时42分钟",明天一早老板就要这批数据做分析,而服务器另一端还时不时抽风断连……这场景是不是让你血压飙升?别急,今天我们就来拆解那些真正实用的批量数据搬运技巧。

传输前的黄金准备

搞清楚你的"货物清单"

别一上来就SELECT *全盘照搬!先问自己:

- 真的需要所有字段吗?(用

SELECT 列名替代星号能减少30%-70%数据量) - 数据是否包含冗余内容?(比如日志表中的重复错误记录)

- 能否按时间范围分批拉取?(

WHERE create_time BETWEEN...是经典操作)

实战案例:某电商平台迁移用户订单数据时,先通过EXPLAIN分析查询效率,最终用SELECT order_id,user_id,amount WHERE date>'2025-01-01'将原本1.2TB的数据精简到400GB。

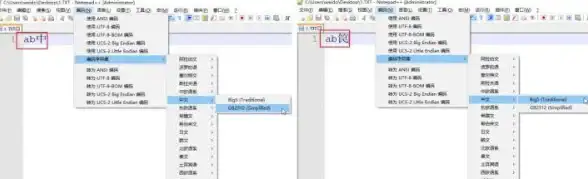

选择你的"运输工具"

不同场景的优选方案:

| 数据类型 | 推荐方式 | 优势 |

|---|---|---|

| 结构化数据 | 数据库原生工具(如mysqldump) | 保持完整性,支持断点续传 |

| 超大型单文件 | rsync + 压缩 | 增量传输,节省带宽 |

| 实时流数据 | Kafka/Pulsar管道 | 低延迟,避免峰值拥堵 |

避坑提示:千万别在办公网络直接拖生产库!某金融公司曾因内网带宽打满导致交易系统瘫痪,最后运维团队不得不凌晨紧急限流。

让传输飞起来的核心技巧

压缩的艺术

- 文本类数据:用

gzip -9压缩率通常达70%以上 - 二进制文件:试试

zstd --fast=3,速度比gzip快3倍 - 数据库备份:mysqldump配合

--compress参数

实测对比:

传输100GB CSV文件:

- 原始传输:2小时12分钟

- 用

pigz -p 8多线程压缩后:38分钟(压缩后体积28GB)

多通道加速方案

- 并行下载:

# 用aria2c开启16线程 aria2c -x16 -s16 ftp://server/data_large.zip

- 分块传输:

把大文件拆分成10GB的包,用多个终端同时传输:split -b 10G huge_file.tar.gz chunk_

断点续传保命指南

这些命令自带"复活"技能:

rsync -P(显示进度条并支持续传)wget -c(著名的续传选项)scp换成sftp+lftp组合更可靠

特殊场景应对策略

跨国传输怎么破?

- 启用TCP BBR拥塞控制算法(Linux内核4.9+默认支持)

- 使用云端中转节点(比如AWS的EC2之间用内网传输)

- 避开网络高峰时段(通过

ping -t观察延迟波动)

敏感数据怎么办?

- 传输前用

openssl enc -aes-256-cbc加密 - 考虑物理硬盘快递(没错,AWS Snowball服务就是干这个的)

监控传输健康度

这几个命令关键时刻能救命:

# 查看实时网速 nload -u M eth0 # 检测传输完整性 sha256sum original_file > check.sha # 网络质量测试 mtr -rw 目标服务器IP

终极加速方案

当常规方法都失效时,可以祭出这些"黑科技":

-

内存盘传输法:

# 在接收端创建内存盘 mkdir /mnt/ramdisk mount -t tmpfs -o size=50G tmpfs /mnt/ramdisk # 直接传输到内存再转存 rsync -avP user@server:/data /mnt/ramdisk/

-

网卡绑定聚合:

将两个千兆网卡绑定成2Gbps通道(需要交换机支持) -

UDP加速工具:

如UDT协议库,适合高延迟网络环境

最后的小贴士:

- 传输完成后立即验证文件数量和校验码

- 长期任务建议用

screen或tmux防断连 - 重要操作前先在小数据集上做完整测试

没有"最好"的方案,只有最适合当前网络环境、数据特征和时间要求的组合拳,下次再遇到数据搬运难题时,不妨把这篇文章当检查清单用——祝你从此告别熬夜等进度条的日子!

(注:文中技术方案基于2025年8月主流环境测试,部分参数需根据实际情况调整)

本文由 夷水蓉 于2025-08-03发表在【云服务器提供商】,文中图片由(夷水蓉)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/529098.html

发表评论