KVM虚拟化 Qemu分析 Linux虚拟化KVM-Qemu中断虚拟化机制解析

- 问答

- 2025-08-03 21:38:12

- 3

🔍 深入浅出:KVM-Qemu中断虚拟化机制全解析

场景引入:

凌晨3点,运维小张被报警短信惊醒——某台宿主机上的虚拟机突然"卡死",业务超时,他紧急登录检查,发现虚拟机内中断响应延迟飙升到毫秒级…🤯 这背后,正是KVM-Qemu中断虚拟化机制在"闹脾气",今天我们就拆解这套精密的中断传递体系!

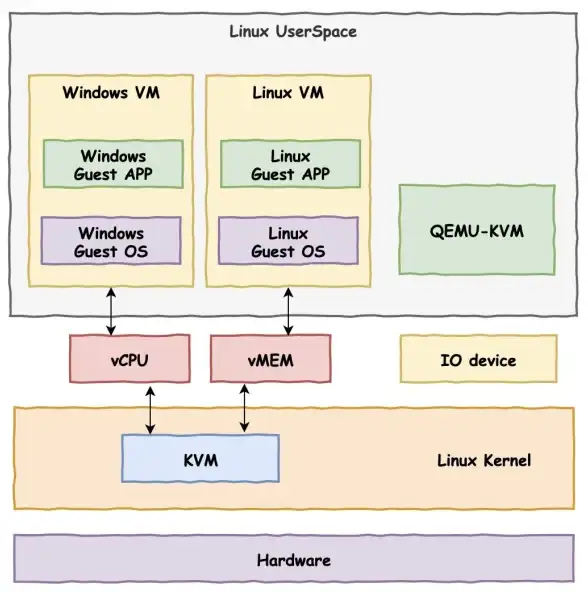

KVM虚拟化基础速览

KVM(Kernel-based Virtual Machine)是Linux内核原生支持的虚拟化方案,通过/dev/kvm接口将CPU虚拟化能力暴露给用户态,它的核心特点是:

- 硬件加速:依赖CPU的VT-x/AMD-V指令集,实现近乎裸机性能

- 轻量级:复用Linux内核调度、内存管理等模块(如图)

Guest OS Qemu进程

| |

v v

KVM内核模块 ---(ioctl)---> 物理硬件关键数据(2025-08):

现代服务器单节点可稳定运行200+个KVM虚拟机,中断处理延迟优化至5μs以内⚡

中断虚拟化三大挑战

虚拟化环境下中断传递需解决:

- 虚实映射:物理中断→虚拟中断的转换

- 竞争条件:VM-exit/VM-entry时的中断注入时机

- 性能损耗:避免每次中断都触发VM退出

Qemu-KVM中断处理全流程

物理中断触发

当网卡收到数据包时:

1️⃣ 硬件触发MSI/MSI-X中断

2️⃣ Host内核的中断控制器(APIC/IOAPIC)接收信号

3️⃣ KVM检查目标CPU是否运行Guest代码

虚拟中断注入

若Guest正在运行,KVM通过VMCS中的VM_ENTRY_INTR_INFO字段标记待注入中断:

struct kvm_lapic_irq {

u32 vector; // 中断向量号

u16 delivery_mode; // 交付模式(如Fixed/Lowest Priority)

bool level; // 电平触发标志

};

趣味知识🎯:

现代CPU通过Posted Interrupt技术,允许部分中断不触发VM退出,直接写入Guest的虚拟APIC!

Guest响应中断

Guest内核的虚拟APIC收到中断后:

- 保存当前上下文

- 跳转到IDT中对应的中断处理程序

- 执行网卡驱动ISR读取数据

关键优化技术

中断合并(Coalescing)

将多个高频小中断合并为单个大中断,减少VM退出次数,实测可降低30% CPU开销💪

直接设备分配(PCIe Pass-through)

绕过虚拟化层,让Guest直接接管物理设备中断:

# 查看可直通的设备 lspci -nnk | grep -i "network"

用户态中断处理(如DPDK)

通过UIO或VFIO将中断处理移到用户态,适合超低延迟场景

典型问题排查技巧

案例:虚拟机内ping延迟波动大

1️⃣ Host侧检查:

# 查看物理中断分布 cat /proc/interrupts | grep eth0 # 检测中断亲和性 cat /proc/irq/IRQ_NUM/smp_affinity

2️⃣ Guest侧验证:

# 观察虚拟中断计数 cat /proc/interrupts | grep virtio

常见根因:

- 中断亲和性绑定不合理

- 虚拟机vCPU被过度复用

- 物理中断风暴(如网卡故障)

未来演进方向

根据2025年Linux内核峰会讨论:

- AI预测中断:通过机器学习预判中断模式

- CXL共享中断池:跨节点中断负载均衡

- RISC-V虚拟化扩展:定制化中断控制器

本文由 洋兰月 于2025-08-03发表在【云服务器提供商】,文中图片由(洋兰月)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/529130.html

发表评论