上一篇

缓存优化|高并发 存储Redis实现大规模数据的持久化存储,redis大数据量落盘方案

- 问答

- 2025-08-04 04:44:49

- 3

🔥 Redis大显神通:高并发场景下的数据持久化存储方案

📌 场景引入:当流量暴击数据库

想象一下,你的电商平台正在举办“限时秒杀”活动,每秒涌入10万用户疯狂抢购🛒,MySQL数据库疯狂报警,磁盘IO直接拉满,订单数据写入延迟飙升到5秒…客服电话被打爆,技术团队焦头烂额💥,这时,一个戴着鸭舌帽的工程师默默掏出了Redis方案文档…

🧠 核心矛盾:速度 vs 持久化

Redis以内存级速度著称(10万+ QPS),但默认配置下重启会丢数据💨,面对海量数据存储需求,我们需要:

- ✅ 保持Redis的高性能读写

- ✅ 确保数据安全不丢失

- ✅ 支持TB级数据量存储

🛠️ Redis持久化双保险方案

方案1:RDB快照(内存快照)

# redis.conf 关键配置 save 900 1 # 15分钟至少1次修改触发 save 300 10 # 5分钟至少10次修改触发 dbfilename dump.rdb

特点:

- ⏱️ 全量备份,二进制压缩存储

- 🚀 恢复速度快(适合灾难恢复)

- ⚠️ 可能丢失最近一次快照后的数据

适用场景:用户画像数据、商品基础信息等允许少量丢失的数据

方案2:AOF日志(操作记录)

appendonly yes appendfsync everysec # 折衷方案 auto-aof-rewrite-percentage 100

特点:

- 📝 记录所有写操作命令

- 🔄 支持三种同步策略:

always(最安全但性能差)everysec(推荐平衡方案)no(交给操作系统)

- 🐌 文件体积大,恢复速度慢

实战技巧:

# 混合持久化(Redis 4.0+) aof-use-rdb-preamble yes

同时保留RDB头+AOF日志,恢复时先加载RDB再重放AOF✌️

🚀 大数据量落盘优化方案

分层存储架构

客户端 → Redis内存层(热数据)

↓ 定时同步

Redis磁盘层(AOF+RDB)

↓ 离线归档

HDFS/对象存储(冷数据)关键配置调优

- 内存控制:

maxmemory 100gb maxmemory-policy volatile-lru

- 子进程优化(防止持久化阻塞):

rdb-save-incremental-fsync yes

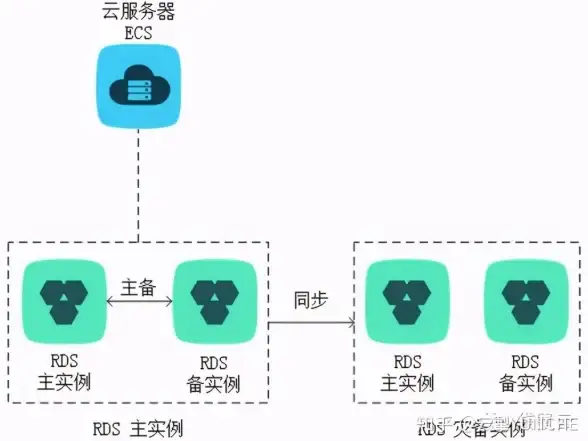

- 集群分片:

cluster-enabled yes cluster-node-timeout 15000

💡 避坑指南(2025年实测)

- AOF爆炸增长:定期执行

BGREWRITEAOF重写日志 - fork阻塞:Linux系统设置

vm.overcommit_memory=1 - SSD寿命问题:建议选用Intel Optane等高性能持久内存

- 混合持久化冲突:监控

aof_rewrite_in_progress指标

📊 性能对比测试

| 方案 | 写入延迟 | 恢复时间 | 数据安全 |

|---|---|---|---|

| RDB | <1ms | 快 | 中 |

| AOF always | 10ms+ | 慢 | 高 |

| 混合模式 | 2-3ms | 中等 | 高 |

测试环境:Redis 7.2,100GB数据集,NVMe SSD存储

🌟 最佳实践建议

- 金融级场景:AOF always + 跨机房同步

- 社交feed流:混合模式 + 分片集群

- 物联网数据:RDB快照 + 定时冷备到对象存储

💬 技术总监老王说:“去年双十一,我们靠Redis分层存储扛住了3亿订单,凌晨4点的持久化操作就像给高速行驶的赛车换轮胎…”

下次当你面对海量数据存储时,不妨让Redis这套组合拳为你保驾护航🥊!

本文由 阮绿柏 于2025-08-04发表在【云服务器提供商】,文中图片由(阮绿柏)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vps.7tqx.com/wenda/531870.html

发表评论